Noticias

El nuevo modelo AI de Voice AI de Openai GPT-4O-Transcribe le permite agregar discurso a sus aplicaciones de texto existentes en segundos

Únase a nuestros boletines diarios y semanales para obtener las últimas actualizaciones y contenido exclusivo sobre la cobertura de IA líder de la industria. Obtenga más información

Los modelos de AI de voz de OpenAi se han metido en problemas antes con el actor Scarlett Johansson, pero eso no impide que la compañía continúe avanzando en sus ofertas en esta categoría.

Hoy, el fabricante de chatgpt ha presentado tres, todos los nuevos modelos de voz propietarios llamados GPT-4O-transcribe, GPT-4O-Mini-transcribe y GPT-4O-MINI-TTSdisponible inicialmente en su interfaz de programación de aplicaciones (API) para que los desarrolladores de software de terceros creen sus propias aplicaciones en la cima, así como en un sitio de demostración personalizado, OpenAI.FM, que los usuarios individuales pueden acceder para pruebas y diversión limitadas.

Además, las voces del modelo GPT-4O-Mini-TTS se pueden personalizar desde varios pre-establecimiento a través de un mensaje de texto para cambiar sus acentos, tono, tono y otras cualidades vocales, incluida la transmisión de las emociones a las que el usuario les pide, lo que debería recorrer un largo camino para abordar cualquier inquietud que esté imitando deliberadamente la voz en particular (la compañía previamente se le dio el caso con el caso con Johansson, pero a la opción de abordar deliberadamente es que la Otración de la Otración es deliberadamente es deliberadamente que es una voz en particular del usuario (la compañía anteriormente negó que sea el caso con Johansson, pero a la Opción de la Otrada, que es más que imitando la voz en particular. de todos modos). Ahora depende del usuario decidir cómo quiere que suene su voz de IA al hablar.

En una demostración con VentureBeat entregado por videollamada, el miembro del personal técnico de Operai, Jeff Harris, mostró cómo usar el texto solo en el sitio de demostración, un usuario podría obtener la misma voz para sonar como un científico loco de carcajadas o un maestro de yoga zen y tranquilo.

Descubrir y refinar nuevas capacidades dentro de la base GPT-4O

Los modelos son variantes del modelo GPT-4O existente OpenAI lanzado en mayo de 2024 y que actualmente impulsa la experiencia de texto y voz de ChatGPT para muchos usuarios, pero la compañía tomó ese modelo base y lo capacitó con datos adicionales para que se produzca en la transcripción y el habla. La compañía no especificó cuándo los modelos podrían venir a ChatGPT.

“CHATGPT tiene requisitos ligeramente diferentes en términos de compensaciones de costo y rendimiento, por lo que aunque espero que se muden a estos modelos a tiempo, por ahora, este lanzamiento se centra en los usuarios de API”, dijo Harris.

Está destinado a reemplazar al modelo de texto a voz de código abierto de dos años de OpenAI, que ofrece tasas de error de palabras más bajas en los puntos de referencia de la industria y un mejor rendimiento en entornos ruidosos, con diversos acentos y a diferentes velocidades de voz, en más de 100 idiomas.

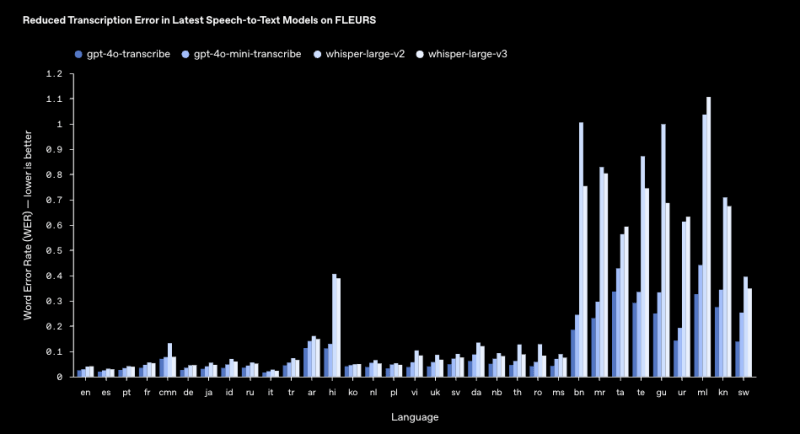

La compañía publicó una tabla en su sitio web que muestra cuánto más bajas son las tasas de error de los modelos GPT-4O-Transcribe para identificar palabras en 33 idiomas, en comparación con Whisper, con un 2.46% impresionantemente bajo en inglés.

“Estos modelos incluyen cancelación de ruido y un detector de actividad de voz semántica, que ayuda a determinar cuándo un altavoz ha terminado un pensamiento, mejorando la precisión de la transcripción”, dijo Harris.

Harris le dijo a VentureBeat que la nueva familia del modelo GPT-4O-Transcribe no está diseñada para ofrecer “diarización” o la capacidad de etiquetar y diferenciar entre diferentes altavoces. En su lugar, está diseñado principalmente para recibir una (o posiblemente múltiples voces) como un solo canal de entrada y responder a todas las entradas con una sola voz de salida en esa interacción, por mucho tiempo que tarda.

La compañía está organizando aún más una competencia para el público en general para encontrar los ejemplos más creativos de usar su sitio de voz de demostración OpenAI.FM y compartirlos en línea etiquetando la cuenta de @openai en X. El ganador recibirá una radio de ingeniería adolescente personalizada con logotipo de OpenAi, que Openai Head of Product, la plataforma Olivier Godement dijo que es uno de los tres en el mundo.

Una mina de oro de aplicaciones de audio

Las mejoras los hacen particularmente adecuados para aplicaciones como los centros de llamadas de los clientes, la transcripción de notas de reunión y los asistentes con IA.

Impresionantemente, los agentes recién lanzados de la compañía SDK de la semana pasada también permiten a aquellos desarrolladores que ya han creado aplicaciones sobre sus modelos de idiomas grandes basados en texto como el GPT-4O regular para agregar interacciones con voz fluida con solo “nueve líneas de código”, según un presentador durante un livestro de YouTube OpenAi que anuncia los nuevos modelos (embarcados anteriormente).

Por ejemplo, una aplicación de comercio electrónico creada en la cima de GPT-4O ahora podría responder a las preguntas de los usuarios por turnos como “Cuéntame sobre mis últimos pedidos” en el habla con solo segundos de ajuste el código agregando estos nuevos modelos.

“Por primera vez, presentamos la transmisión de voz a texto, lo que permite a los desarrolladores ingresar continuamente audio y recibir un flujo de texto en tiempo real, haciendo que las conversaciones se sientan más naturales”, dijo Harris.

Aún así, para aquellos desarrolladores que buscan experiencias de voz de IA de baja latencia en tiempo real, OpenAi recomienda usar sus modelos de voz a voz en la API de tiempo real.

Precios y disponibilidad

Los nuevos modelos están disponibles inmediatamente a través de la API de OpenAI, con el precio de la siguiente manera:

• GPT-4O-Transcribe: $ 6.00 por 1 m tokens de entrada de audio (~ $ 0.006 por minuto)

• GPT-4O-Mini-Transcribe: $ 3.00 por 1 m tokens de entrada de audio (~ $ 0.003 por minuto)

• GPT-4O-MINI-TTS: $ 0.60 por 1 m tokens de entrada de texto, $ 12.00 por 1 m tokens de salida de audio (~ $ 0.015 por minuto)

Sin embargo, llegan a una época de competencia más feroz en la transcripción de IA y el espacio del habla, con empresas de IA dedicadas del habla como once que ofrece su nuevo modelo de escriba que admite diarización y cuenta con una tasa de error reducida de 3,3% en inglés, y un precio de $ 0.40 por hora de entrada (o $ 0.006 por minuto, aproximadamente, equivalente).

Otra startup, Hume AI ofrece un nuevo modelo de octava TTS con la personalización de la pronunciación e inflexión de la pronunciación e emocional a nivel de oración, basada completamente en las instrucciones del usuario, no en cualquier voz preestablecida. El precio de Octave TTS no es directamente comparable, pero hay un nivel libre que ofrece 10 minutos de audio y los costos aumentan desde allí entre

Mientras tanto, los modelos de audio y discurso más avanzados también están llegando a la comunidad de código abierto, incluida una llamada Orpheus 3B que está disponible con una licencia permisiva de Apache 2.0, lo que significa que los desarrolladores no tienen que pagar costos para ejecutarlo, siempre que tengan el hardware o los servidores en la nube correctos.

Adopción de la industria y resultados tempranos

Varias compañías ya han integrado los nuevos modelos de audio de Openai en sus plataformas, informando mejoras significativas en el rendimiento de la IA de voz, según testimonios compartidos por OpenAI con VentureBeat.

Eliseai, una compañía centrada en la automatización de la administración de propiedades, encontró que el modelo de texto a voz de Openi permitió interacciones más naturales y emocionalmente ricas con los inquilinos.

Las voces mejoradas hicieron que el arrendamiento, el mantenimiento y la programación de la gira funcionen con una mayor atracción, lo que llevó a una mayor satisfacción del inquilino y mejoras tasas de resolución de llamadas.

Decagon, que construye experiencias de voz con IA, vio una mejora del 30% en la precisión de la transcripción utilizando el modelo de reconocimiento de voz de OpenAI.

Este aumento en la precisión ha permitido que los agentes de IA de Decagon se desempeñen de manera más confiable en escenarios del mundo real, incluso en entornos ruidosos. El proceso de integración fue rápido, con un decagón incorporando el nuevo modelo en su sistema en un día.

No todas las reacciones al último lanzamiento de OpenAi han sido cálidas. El cofundador del software de Dawn AI App Analytics Ben Hylak (@benhylak), un ex diseñador de interfaces humanas de Apple, publicado en X que, si bien los modelos parecen prometedores, el anuncio “se siente como un retiro de la voz en tiempo real”, lo que sugiere un cambio del enfoque anterior de Openai en la IA conversacional de baja latencia a través de Chatgpt.

Además, el lanzamiento fue precedido por una filtración temprana en X (anteriormente Twitter). TestingCatalog News (@TestingCatalog) publicó detalles sobre los nuevos modelos varios minutos antes del anuncio oficial, enumerando los nombres de GPT-4O-Mini-TTS, GPT-4O-TRANSCRIE y GPT-4O-Mini-Trancribe. La fuga fue acreditada a @stiventhedev, y la publicación rápidamente ganó tracción.

Pero mirando hacia el futuro, Operai planea continuar refinando sus modelos de audio y está explorando las capacidades de voz personalizadas al tiempo que garantiza la seguridad y el uso responsable de la IA. Más allá del audio, OpenAi también está invirtiendo en IA multimodal, incluido el video, para habilitar experiencias más dinámicas e interactivas basadas en agentes.