Noticias

LlamaV-o1 es el modelo de IA que explica su proceso de pensamiento: he aquí por qué es importante

Únase a nuestros boletines diarios y semanales para obtener las últimas actualizaciones y contenido exclusivo sobre la cobertura de IA líder en la industria. Más información

Investigadores de la Universidad de Inteligencia Artificial Mohamed bin Zayed (MBZUAI) han anunciado el lanzamiento de LlamaV-o1, un modelo de inteligencia artificial de última generación capaz de abordar algunas de las tareas de razonamiento más complejas en texto e imágenes.

Al combinar el aprendizaje curricular de vanguardia con técnicas de optimización avanzadas como Beam Search, LlamaV-o1 establece un nuevo punto de referencia para el razonamiento paso a paso en sistemas de IA multimodales.

“El razonamiento es una capacidad fundamental para resolver problemas complejos de varios pasos, particularmente en contextos visuales donde la comprensión secuencial por pasos es esencial”, escribieron los investigadores en su informe técnico, publicado hoy. El modelo de IA, optimizado para tareas de razonamiento que requieren precisión y transparencia, supera a muchos de sus pares en tareas que van desde la interpretación de gráficos financieros hasta el diagnóstico de imágenes médicas.

Junto con el modelo, el equipo también presentó VRC-Bench, un punto de referencia diseñado para evaluar los modelos de IA en función de su capacidad para razonar problemas paso a paso. Con más de 1000 muestras diversas y más de 4000 pasos de razonamiento, VRC-Bench ya está siendo aclamado como un punto de inflexión en la investigación de IA multimodal.

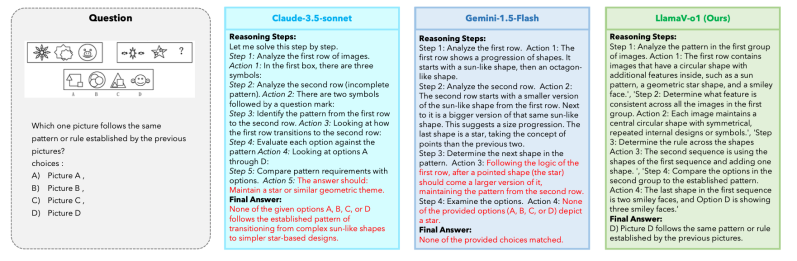

Cómo se diferencia LlamaV-o1 de la competencia

Los modelos tradicionales de IA a menudo se centran en ofrecer una respuesta final, ofreciendo poca información sobre cómo llegaron a sus conclusiones. LlamaV-o1, sin embargo, enfatiza el razonamiento paso a paso, una capacidad que imita la resolución de problemas humana. Este enfoque permite a los usuarios ver los pasos lógicos que sigue el modelo, lo que lo hace particularmente valioso para aplicaciones donde la interpretabilidad es esencial.

Los investigadores entrenaron LlamaV-o1 utilizando LLaVA-CoT-100k, un conjunto de datos optimizado para tareas de razonamiento, y evaluaron su rendimiento utilizando VRC-Bench. Los resultados son impresionantes: LlamaV-o1 logró una puntuación de pasos de razonamiento de 68,93, superando a modelos de código abierto conocidos como LlaVA-CoT (66,21) e incluso a algunos modelos de código cerrado como Claude 3.5 Sonnet.

“Al aprovechar la eficiencia de Beam Search junto con la estructura progresiva del aprendizaje curricular, el modelo propuesto adquiere habilidades de manera incremental, comenzando con tareas más simples como [a] resumen del enfoque y subtítulos derivados de preguntas y avance a escenarios de razonamiento de varios pasos más complejos, asegurando tanto una inferencia optimizada como capacidades de razonamiento sólidas”, explicaron los investigadores.

El enfoque metódico del modelo también lo hace más rápido que sus competidores. “LlamaV-o1 ofrece una ganancia absoluta del 3,8% en términos de puntuación promedio en seis puntos de referencia y, al mismo tiempo, es 5 veces más rápido durante el escalado de inferencia”, señaló el equipo en su informe. Una eficiencia como esta es un punto de venta clave para las empresas que buscan implementar soluciones de IA a escala.

IA para empresas: por qué es importante el razonamiento paso a paso

El énfasis de LlamaV-o1 en la interpretabilidad aborda una necesidad crítica en industrias como las finanzas, la medicina y la educación. Para las empresas, la capacidad de rastrear los pasos detrás de la decisión de una IA puede generar confianza y garantizar el cumplimiento de las regulaciones.

Tomemos como ejemplo las imágenes médicas. Un radiólogo que utiliza IA para analizar exploraciones no solo necesita el diagnóstico: necesita saber cómo la IA llegó a esa conclusión. Aquí es donde brilla LlamaV-o1, que proporciona un razonamiento transparente paso a paso que los profesionales pueden revisar y validar.

El modelo también destaca en campos como la comprensión de gráficos y diagramas, que son vitales para el análisis financiero y la toma de decisiones. En las pruebas realizadas en VRC-Bench, LlamaV-o1 superó consistentemente a sus competidores en tareas que requerían interpretación de datos visuales complejos.

Pero el modelo no es sólo para aplicaciones de alto riesgo. Su versatilidad lo hace adecuado para una amplia gama de tareas, desde generación de contenido hasta agentes conversacionales. Los investigadores ajustaron específicamente LlamaV-o1 para que sobresaliera en escenarios del mundo real, aprovechando Beam Search para optimizar las rutas de razonamiento y mejorar la eficiencia computacional.

Beam Search permite que el modelo genere múltiples rutas de razonamiento en paralelo y seleccione la más lógica. Este enfoque no solo aumenta la precisión sino que también reduce el costo computacional de ejecutar el modelo, lo que lo convierte en una opción atractiva para empresas de todos los tamaños.

Qué significa VRC-Bench para el futuro de la IA

El lanzamiento de VRC-Bench es tan importante como el modelo en sí. A diferencia de los puntos de referencia tradicionales que se centran únicamente en la precisión de la respuesta final, VRC-Bench evalúa la calidad de los pasos de razonamiento individuales, ofreciendo una evaluación más matizada de las capacidades de un modelo de IA.

“La mayoría de los puntos de referencia se centran principalmente en la precisión de la tarea final, descuidando la calidad de los pasos intermedios de razonamiento”, explicaron los investigadores. “[VRC-Bench] presenta un conjunto diverso de desafíos con ocho categorías diferentes que van desde la percepción visual compleja hasta el razonamiento científico con más de [4,000] pasos de razonamiento en total, lo que permite una evaluación sólida de las capacidades de los LLM para realizar un razonamiento visual preciso e interpretable en múltiples pasos”.

Este enfoque en el razonamiento paso a paso es particularmente crítico en campos como la investigación científica y la educación, donde el proceso detrás de una solución puede ser tan importante como la solución misma. Al enfatizar la coherencia lógica, VRC-Bench fomenta el desarrollo de modelos que puedan manejar la complejidad y ambigüedad de las tareas del mundo real.

El desempeño de LlamaV-o1 en VRC-Bench dice mucho sobre su potencial. En promedio, el modelo obtuvo una puntuación del 67,33% en puntos de referencia como MathVista y AI2D, superando a otros modelos de código abierto como Llava-CoT (63,50%). Estos resultados posicionan a LlamaV-o1 como líder en el espacio de la IA de código abierto, reduciendo la brecha con modelos propietarios como GPT-4o, que obtuvo una puntuación del 71,8%.

La próxima frontera de la IA: razonamiento multimodal interpretable

Si bien LlamaV-o1 representa un gran avance, no está exento de limitaciones. Como todos los modelos de IA, está limitado por la calidad de sus datos de entrenamiento y puede tener problemas con indicaciones altamente técnicas o conflictivas. Los investigadores también advierten contra el uso del modelo en escenarios de toma de decisiones de alto riesgo, como la atención médica o las predicciones financieras, donde los errores podrían tener consecuencias graves.

A pesar de estos desafíos, LlamaV-o1 destaca la creciente importancia de los sistemas de inteligencia artificial multimodal que pueden integrar perfectamente texto, imágenes y otros tipos de datos. Su éxito subraya el potencial del aprendizaje curricular y del razonamiento paso a paso para cerrar la brecha entre la inteligencia humana y la máquina.

A medida que los sistemas de IA se integren más en nuestra vida cotidiana, la demanda de modelos explicables seguirá creciendo. LlamaV-o1 es una prueba de que no tenemos que sacrificar el rendimiento por la transparencia y que el futuro de la IA no se limita a dar respuestas. Está en mostrarnos cómo llegó allí.

Y tal vez ese sea el verdadero hito: en un mundo repleto de soluciones de caja negra, LlamaV-o1 abre la tapa.