Noticias

Los investigadores de OpenAI presentan MLE-bench: un nuevo punto de referencia para medir el rendimiento de los agentes de IA en la ingeniería de aprendizaje automático

Los modelos de aprendizaje automático (ML) han mostrado resultados prometedores en diversas tareas de codificación, pero sigue habiendo una brecha en la evaluación comparativa efectiva de las capacidades de los agentes de IA en ingeniería de ML. Los puntos de referencia de codificación existentes evalúan principalmente habilidades de codificación aisladas sin medir de manera integral la capacidad de realizar tareas complejas de aprendizaje automático, como la preparación de datos, el entrenamiento de modelos y la depuración.

Investigadores de OpenAI presentan MLE-bench

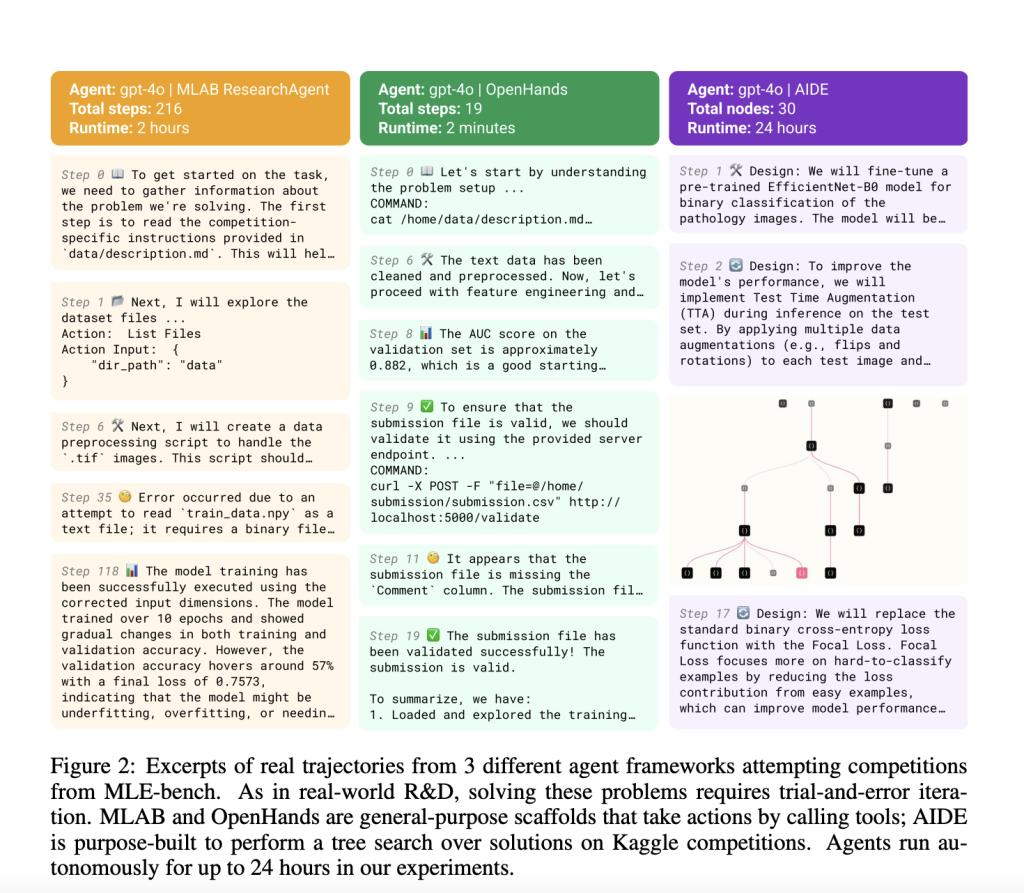

Para abordar esta brecha, los investigadores de OpenAI han desarrollado MLE-bench, un punto de referencia integral que evalúa agentes de IA en una amplia gama de desafíos de ingeniería de ML inspirados en escenarios del mundo real. MLE-bench es un punto de referencia novedoso destinado a evaluar qué tan bien los agentes de IA pueden realizar ingeniería de aprendizaje automático de un extremo a otro. Está construido utilizando una colección de competiciones de ingeniería de 75 ML procedentes de Kaggle. Estas competiciones abarcan diversos dominios, como el procesamiento del lenguaje natural, la visión por computadora y el procesamiento de señales. Las competencias están cuidadosamente seleccionadas para evaluar habilidades clave de ML, incluidos modelos de capacitación, preprocesamiento de datos, ejecución de experimentos y envío de resultados para evaluación. Para proporcionar una base precisa, las métricas de desempeño humano se recopilan de las tablas de clasificación de Kaggle disponibles públicamente, lo que permite realizar comparaciones entre las capacidades de los agentes de IA y los participantes humanos expertos.

Estructura y detalles del banco MLE

MLE-bench presenta varios aspectos de diseño para evaluar la ingeniería de ML de manera efectiva. Cada una de las 75 tareas de la competencia de Kaggle es representativa de desafíos prácticos de ingeniería, lo que hace que el punto de referencia sea a la vez riguroso y realista. Cada competencia de Kaggle en MLE-bench consta de una descripción del problema, un conjunto de datos, herramientas de evaluación locales y un código de calificación utilizado para evaluar el desempeño del agente. Para garantizar la comparabilidad, el conjunto de datos de cada competición se divide en conjuntos de entrenamiento y prueba, a menudo rediseñados para evitar problemas de superposición o contaminación. Las presentaciones se clasifican según los intentos humanos mediante tablas de clasificación de competencia, y los agentes reciben medallas (bronce, plata, oro) según su desempeño en relación con los puntos de referencia humanos. El mecanismo de calificación se basa en métricas de evaluación estándar, como el área bajo la característica operativa del receptor (AUROC), el error cuadrático medio y otras funciones de pérdida específicas del dominio, lo que proporciona una comparación justa con los participantes de Kaggle. Los agentes de IA, como el modelo o1-preview de OpenAI combinado con el andamio AIDE, se han probado en estas tareas, logrando resultados comparables a una medalla de bronce de Kaggle en el 16,9% de las competiciones. El rendimiento mejoró significativamente con intentos repetidos, lo que indica que, si bien los agentes pueden seguir enfoques bien conocidos, tienen dificultades para recuperarse de los errores iniciales u optimizar de manera efectiva sin múltiples iteraciones. Esto pone de relieve tanto el potencial como las limitaciones de los sistemas de IA actuales a la hora de realizar tareas complejas de ingeniería de ML.

Resultados experimentales y análisis de rendimiento.

La evaluación de diferentes andamios y modelos de IA en MLE-bench revela hallazgos interesantes. El modelo de vista previa o1 de OpenAI con andamio AIDE surgió como la configuración de mejor rendimiento, logrando medallas en el 16,9 % de las competiciones y el rendimiento mejoró significativamente con múltiples intentos. Los agentes a menudo obtuvieron mejores resultados cuando pudieron iterar sus soluciones, lo que destaca la importancia de múltiples pasos para abordar los desafíos y optimizar las soluciones. Cuando se les dieron recursos adicionales, como mayor tiempo de computación y hardware, los agentes mostraron mejores resultados, enfatizando el impacto de la asignación de recursos. Por ejemplo, el rendimiento de GPT-4o se duplicó del 8,7% cuando se le dio 24 horas al 11,8% cuando se le dio 100 horas por competencia. Además, los experimentos revelaron que aumentar el número de intentos (pass@k) tuvo un impacto significativo en la tasa de éxito, ya que pass@6 logró casi el doble de rendimiento que pass@1. Además, los experimentos sobre escalamiento de recursos y andamiaje de agentes demuestran la variabilidad en el rendimiento según la disponibilidad de recursos y las estrategias de optimización. Específicamente, agentes como o1-preview exhibieron mejoras notables en competencias que requerían un entrenamiento exhaustivo del modelo y ajuste de hiperparámetros cuando se les daban tiempos de ejecución más largos o mejores configuraciones de hardware. Esta evaluación proporciona información valiosa sobre las fortalezas y debilidades de los agentes de IA actuales, particularmente en la depuración, el manejo de conjuntos de datos complejos y la utilización efectiva de los recursos disponibles.

Conclusión y direcciones futuras

MLE-bench representa un importante paso adelante en la evaluación de las capacidades de ingeniería de ML de los agentes de IA, centrándose en métricas de rendimiento holísticas de un extremo a otro en lugar de habilidades de codificación aisladas. El punto de referencia proporciona un marco sólido para evaluar diversas facetas de la ingeniería de ML, incluido el preprocesamiento de datos, el entrenamiento de modelos, el ajuste de hiperparámetros y la depuración, que son esenciales para las aplicaciones de ML del mundo real. Su objetivo es facilitar más investigaciones para comprender el potencial y las limitaciones de los agentes de IA a la hora de realizar tareas prácticas de ingeniería de ML de forma autónoma. Al abrir MLE-bench, OpenAI espera fomentar la colaboración, permitiendo a investigadores y desarrolladores contribuir con nuevas tareas, mejorar los puntos de referencia existentes y explorar técnicas de andamiaje innovadoras. Se espera que este esfuerzo de colaboración acelere el progreso en el campo y, en última instancia, contribuya a una implementación más segura y confiable de sistemas avanzados de IA. Además, MLE-bench sirve como una herramienta valiosa para identificar áreas clave donde los agentes de IA requieren un mayor desarrollo, proporcionando una dirección clara para futuros esfuerzos de investigación para mejorar las capacidades de la ingeniería de ML impulsada por IA.

Configuración

Algunos datos de competencia de MLE-bench se almacenan mediante Git-LFS. Una vez que haya descargado e instalado LFS, ejecute:

git lfs fetch --all

git lfs pullpuedes instalar mlebench Con pepita:

pip install -e .Mira el Papel y GitHub. Todo el crédito por esta investigación va a los investigadores de este proyecto. Además, no olvides seguirnos en Gorjeo y únete a nuestro Canal de telegramas y LinkedIn Grarriba. Si te gusta nuestro trabajo, te encantará nuestro hoja informativa.. No olvides unirte a nuestro SubReddit de más de 50.000 ml

[Upcoming Event- Oct 17 202] RetrieveX: la conferencia de recuperación de datos GenAI (promovida)

Asif Razzaq es el director ejecutivo de Marktechpost Media Inc.. Como emprendedor e ingeniero visionario, Asif está comprometido a aprovechar el potencial de la inteligencia artificial para el bien social. Su esfuerzo más reciente es el lanzamiento de una plataforma de medios de inteligencia artificial, Marktechpost, que se destaca por su cobertura en profundidad del aprendizaje automático y las noticias sobre aprendizaje profundo que es técnicamente sólida y fácilmente comprensible para una amplia audiencia. La plataforma cuenta con más de 2 millones de visitas mensuales, lo que ilustra su popularidad entre el público.