Midjourney fue una de las plataformas originales de generación de imágenes artificiales y sigue siendo una de las mejores. Permite la creación de una amplia variedad de imágenes y estilos, con parámetros que ofrecen una increíble flexibilidad y control sobre el aspecto final de tu imagen.

Con su traslado a la web a principios de este año, poniendo fin al reinado del bot Discord, Midjourney se ha vuelto aún más poderoso. Esto incluye la adición de un editor, que le permite cambiar el tamaño de la imagen generada y hacer que la IA llene los espacios automáticamente.

Como cualquier plataforma poderosa que ha crecido y evolucionado, Midjourney tiene sus peculiaridades. Esto incluye configuraciones ocultas que pueden marcar una gran diferencia y, por supuesto, técnicas de indicación que le permiten obtener la imagen que realmente desea. Se compara muy favorablemente con otros modelos de IA y, a menudo, los supera en la mayoría de las métricas.

He intentado reunir una selección de los mejores consejos y técnicas de Midjourney que he aprendido a lo largo de los años, centrándome principalmente en indicaciones más que en funciones, por lo que esto seguirá funcionando si estás trabajando dentro del bot de Discord y no lo has hecho. Cambié a la web todavía.

Impulsando la mitad del viaje

Solicitar Midjourney es similar a cualquier otro generador de imágenes de IA: le gusta que seas específico, puedes usar lenguaje natural y, si eres vago, te dará la mejor suposición.

Ahora bien, no pretendo ser el mejor usuario de Midjourney, ni siquiera uno particularmente experto. Pero uso mucho la plataforma y he generado una cantidad considerable de imágenes.

Algunos de los creadores que he visto en las redes sociales producen contenido alucinante que realmente muestra el arte de la IA. Me refiero a trabajos que no serían posibles con otras formas de arte o que utilizan técnicas de inteligencia artificial para combinar ideas y estilos que no se ven comúnmente en otras áreas.

He reunido algunos de los mejores consejos que he recibido, junto con técnicas que he desarrollado yo mismo, para ayudarte a mejorar tus habilidades a mitad del viaje. ¡No dudes en compartir en los comentarios cualquier consejo que me haya perdido o ideas que creas que podrían ayudar a mejorar mis propias imágenes!

1. Sea lo más específico que pueda

La especificidad es importante. Midjourney, Flux e Ideogram prosperan en la descripción y el detalle. Cuanto menos tenga que llenar el modelo los huecos, mejor reflejará la imagen tu idea. Midjourney funciona bien con indicaciones simples (incluso puedes darle un emoji), pero los detalles indican la dirección.

No todos los términos descriptivos son iguales. Debes centrarte en el tema principal, el fondo, la combinación de colores y los elementos que deseas asegurarte de que estén incluidos. Por ejemplo, si quieres un coche rojo, especifica el color.

Aquí hay una imagen típica de IA de un horizonte futuro. Quería incluir un río, así que me propuse incluirlo y el puente en mi mensaje. Especifiqué no sólo colores sino también estilos y conjuntos ligeros.

En general, debes evitar términos vagos. Me mantendría alejado de bello y genial a menos que necesites específicamente esos términos en el contexto, como un logotipo de látigo genial.

Mensaje de ejemplo: “Un horizonte urbano futurista al anochecer, con imponentes rascacielos de cristal que reflejan los tonos naranja y violeta del atardecer. Un río serpentea por el centro, con un puente colgante iluminado por suaves luces LED azules. Personas con trajes de estilo cyberpunk caminan por el calles, con carteles de neón brillando al fondo.”

2. Defina la cámara y el tipo de lente.

Si desea una imagen lo más cercana posible a una fotografía real, defina la configuración de la cámara y la lente. Al igual que en la fotografía, configurar la lente, el ángulo, el tipo y el enfoque puede afectar el resultado final.

Utilice términos como gran angular, macro o telefoto, además de si la toma es cercana o amplia. Si lo que desea es la apariencia de un teléfono inteligente, es útil especificar la marca y el modelo del teléfono inteligente, ya que Midjourney puede adaptarse a eso. También puede ser útil especificar la época, como los años 90 o 60. Consulte términos de cámara como “lente de 50 mm” o “ISO 100” para obtener una imagen más precisa y enfocada.

Experimente cambiando la cámara en el mismo mensaje. En mi ejemplo para este consejo, lo configuré como una lente de 50 mm. Pruébelo usted mismo, pero conviértalo en un objetivo fijo de 35 mm para enfocar más de la escena que con un objetivo de 50 mm.

Mensaje de ejemplo: “Un retrato de un león en el Serengeti, tomado con una lente de 50 mm en la hora dorada. El enfoque es nítido en los ojos del león, con una poca profundidad de campo que desdibuja las altas hierbas del fondo. La luz resalta la melena del león, creando un efecto cálido y brillante.”

3. Ponte emocional

Si bien términos genéricos como genial y hermoso no son una gran idea, ser más específico con términos emotivos puede agregar una mejor sensación general a tu imagen. Por ejemplo, el uso de frases como melancólica, alegre o incluso siniestra puede afectar la forma en que se transmite la vibra y el tono.

Además de las palabras específicas, puedes combinarlas con detalles ambientales para crear una atmósfera para tu imagen. Si desea algo con una sensación sombría, puede incluir “cielos oscuros y tormentosos” o, para algo más alegre, puede usar “cielos brillantes y soleados con una luz suave y dorada”, que evoca un estado de ánimo cálido y alegre.

Si desea experimentar, ¿por qué no intenta cambiar “sereno y pacífico” en el siguiente mensaje por “oscuro y tormentoso” o “brillante y festivo” para ver cómo cambia la imagen?

Mensaje de ejemplo: “Un bosque sereno y pacífico al amanecer, con la suave luz del sol filtrándose a través de las hojas. La escena se siente tranquila y calmante, con un brillo brumoso alrededor de los árboles. Un ciervo está parado en el centro, con la cabeza inclinada hacia la luz, evocando una sensación de silenciosa maravilla.”

4. Refinamiento iterativo

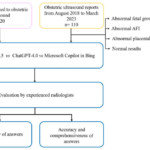

Este es el consejo más difícil de demostrar, ya que no implica un solo cambio y hay varias formas de realizar el proceso. Sin embargo, el concepto es simple: prueba, intenta y vuelve a intentar hasta que obtengas exactamente lo que esperabas. La idea es que estamos refinando la imagen creando constantemente nuevas versiones para solucionar pequeños problemas con la generación.

Debe comenzar con un concepto amplio y simple (un mensaje que puede tener unas pocas palabras) y luego desarrollarlo agregando más detalles con cada nueva generación. Una forma de hacer esto es darle la primera imagen a ChatGPT y pedirle a ese chatbot que la describa. Luego, pídale que agregue lo que desee al mensaje, como un cambio de color, una iluminación diferente o un árbol.

Midjourney también tiene su propia función de descripción que se puede usar de la misma manera, o puedes jugar con las opciones de variación y remezcla integradas en Midjourney para adaptar la imagen. Por ejemplo, podría utilizar la primera imagen como referencia al crear la siguiente versión.

Mensaje de ejemplo (inicial): “Una nave espacial volando a través de una nebulosa”.

Mensaje refinado (compartido): “Una elegante nave espacial metálica con brillantes motores azules que vuela a través de una nebulosa púrpura arremolinada, con estrellas en el fondo. La luz de los motores se refleja en el casco de la nave, proyectando un tenue resplandor en el espacio circundante”.

5. Usando parámetros

Finalmente, el verdadero poder de Midjourney son sus parámetros y el control que te dan sobre la imagen que estás creando. Se trata de configuraciones avanzadas que pueden controlar diferentes elementos como dimensiones, calidad e incluso aleatoriedad creativa. En los días de Discord, necesitabas configurarlos con un “–“, pero ahora parte de eso es un botón en la web.

Puede definir la relación de aspecto, la resolución de la imagen y el punto focal y establecer un estilo, referencia de imagen, nivel de caos y creatividad. Hay miles de millones de referencias de estilo en Midjoruney, a las que se accede mediante el comando –sref ya sea con la palabra aleatorio, una URL o un número.

Debido a que usé “caos” en el mensaje, incluí las cuatro imágenes generadas por Midjourney desde el mismo mensaje. El caos te brinda más variedad entre cada imagen.

Mensaje de ejemplo: “Un paisaje de colinas bajo un cielo azul claro, con un pequeño pueblo en la distancia. Los colores deben ser vibrantes y ligeramente estilizados, evocando una sensación de ensueño. –ar 16:9 –stylize 1000 –chaos 20.”

–Ar 16:9: establece la relación de aspecto en 16:9 (formato panorámico).

–estilizar 1000: Agrega un fuerte estilo estético a la imagen.

–caos 20: Agrega algo de variedad y aleatoriedad a la generación, mientras la mantiene controlada.