ChatGPT has taken the tech world by storm since its debut, and 2024 wasn’t any less for the chatbot and its maker, OpenAI. The Delaware-based generative AI company saw many ups and downs last year. While it continued to launch new AI products and features, OpenAI was a part of several legal battles.

Let’s recap major launches and other big updates from 2024 related to OpenAI and ChatGPT. In your free time, you can check out our recaps of major Gemini features from 2024, services Google killed in 2024, and the Instagram wishlist for 2025.

Table of Contents:

Note: This list is not exhaustive and may not contain all updates related to ChatGPT and OpenAI. The features are not arranged in any order of preference.

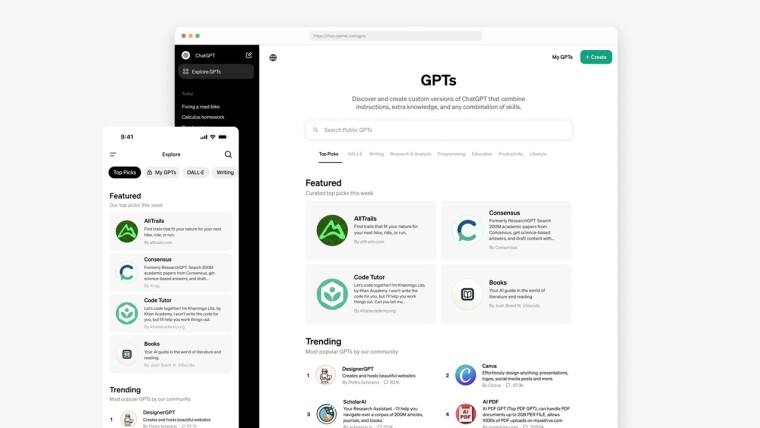

GPT Store, ChatGPT Team subscription, $200 Pro plan

OpenAI started 2024 with a brand new GPT Store to expand the potential use cases of its chatbot. The store is a central hub where users can find and share custom versions of ChatGPT (called GPTs) made for specific tasks. Over three million GPTs were already available at launch, OpenAI announced, adding that bot creators can earn money through the revenue-sharing program.

A new paid subscription tier called ChatGPT Team was also introduced, targeting teams with up to 150 users for collaborative creation. Compared to the Plus tier, it offers higher message limits on GPT-4, GPT-4o, and other tools like DALL-E and data analysis.

The ChatGPT-maker unveiled a “Pro” plan in December with a hefty price tag of $200/mo for those with deep pockets. The company said that the highly-priced subscription offers the best of OpenAI and the highest level of access. ChatGPT Pro comes with all the perks of the Plus tier and unlimited access to advanced voice mode, GPT-4o, o1, and o1-mini models.

ChatGPT via landline phones

Yes, you read that correctly! Using ChatGPT via a landline phone is something you might rarely think of. However, OpenAI launched a new phone number (1-800-CHATGPT) that you can dial to get a taste of generative AI using legacy tech.

You can throw questions at the chatbot and interrupt it anytime. The experience might feel similar to the advanced voice mode. If you live in the US or Canada, you get 15 minutes of free calling in a month (standard carrier fees may apply). You can also save the number on your phone and talk to ChatGPT via WhatsApp. Again, there is a daily limit to how many WhatsApp messages you can exchange.

Use ChatGPT without an account

Walls around ChatGPT were lowered by OpenAI, allowing users to access the chatbot without an account completely free. OpenAI announced in April that it will “gradually” roll out account-free access to everyone, adding that there will be more “guardrails” with it and that some text prompts may be blocked.

You still need an account to unlock features such as chat history, share chats, voice conversations, and custom instructions.

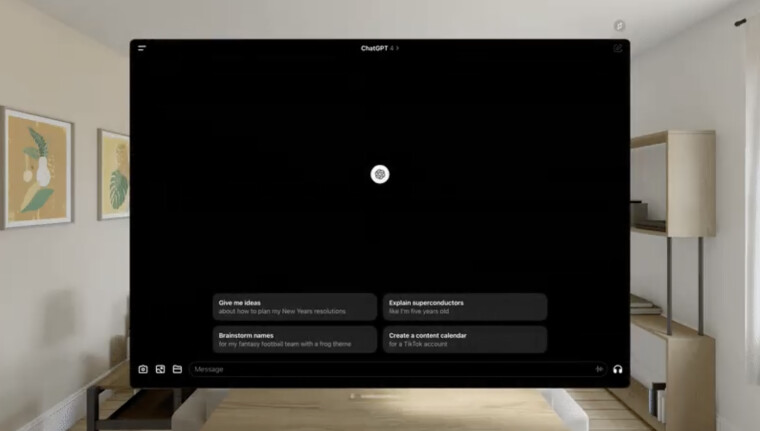

ChatGPT for Apple Vision Pro

While tech giants like Netflix, Spotify, and YouTube shied away from being early adopters of Apple’s pocket-burning spatial computing headset, OpenAI hopped on the ship quickly.

The ChatGPT app for Vision Pro was launched in February last year, powered by OpenAI’s then-latest large language model (LLM) GPT-4 Turbo. ChatGPT was among the 600 apps and games natively available for Apple Vision Pro at its launch.

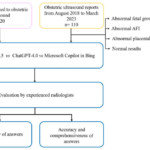

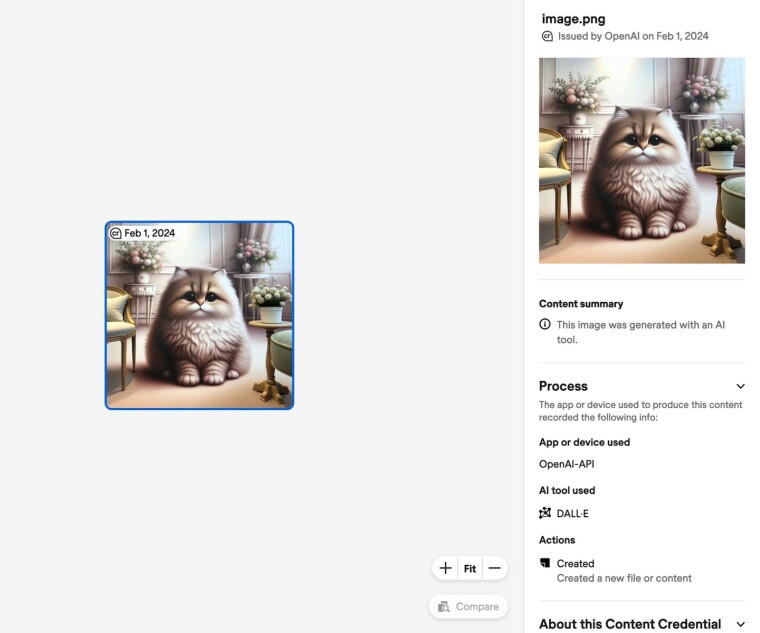

Watermarks for AI-generated images, deepfake image detector

OpenAI started adding watermarks to AI-generated images created using its text-to-image model DALL-E 3 and ChatGPT. The move was to make dealing with sophisticated AI tools easier and help users identify whether a human or an AI created the image. The change aligned with the specifications issued by the Coalition for Content Provenance and Authenticity (C2PA).

The watermark includes details such as the creation date and C2PA logo in the upper left corner. While OpenAI assured no reduction in image quality or processing speeds, the watermark increased the image’s file size. It added that removing provenance data by cropping the image or editing its pixels was technically possible.

Apart from that, OpenAI started testing a new tool to detect if an image was made using the DALL-E art generator. An early version of the unnamed tool successfully identified over 98% of images generated by DALL-E and misidentified images by less than 0.5 of the time as being made by DALL-E.

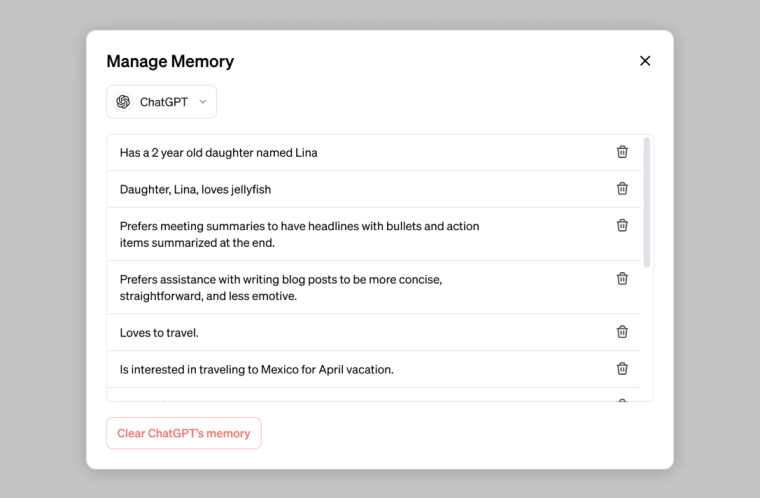

Memory for ChatGPT

A memory feature for ChatGPT went into testing in February last year, enabling the chatbot to remember past chats and use the information when needed for future chats. For instance, you can ask the chatbot to remember your name, if you have a puppy, if you have a neighborhood coffee shop, or if you prefer concise responses.

The feature allows ChatGPT to forget parts of its memory you don’t want. It was released to ChatGPT Plus users in April and made available to free users in September.

ChatGPT on iPhone

Apple was late to the generative AI party. However, that changed last year with the iOS 18 update, which introduced the Apple Intelligence suite of AI features. Adding more to that was ChatGPT integration for Siri, allowing the iPhone’s voice assistant to call up its more capable counterpart when things go out of hand.

A previous report claimed the deal was structured so that Apple didn’t have to pay any money to OpenAI. Instead, the Cupertino giant believed offering OpenAI’s brand and tech to over one billion active devices would provide more value than cash payment.

It might contribute to more ChatGPT Plus paid tier sign-ups as users can manage the chatbot directly from the iPhone’s settings app. Meanwhile, Apple can earn a commission as a referring partner.

However, the partnership invited criticism from the tech mogul Elon Musk, who threatened to ban iPhones with ChatGPT from his companies and put them in a Faraday cage.

Apple was also rumored to add Google’s Gemini chatbot to its Apple Intelligence suite and power Siri’s responses. Meanwhile, OpenAI was reportedly in talks with Samsung about integrating ChatGPT into Galaxy devices.

Media Manager

Media Manager allows content makers and owners to inform OpenAI about their content ownership and whether or not they want their content to be used to train its AI models. OpenAI said during the announcement that it plans to have the tool, which was in the early stages of development, in place by 2025.

OpenAI added that Media Manager will be the first-of-its-kind tool built “to help us identify copyrighted text, images, audio, and video across multiple sources and reflect creator preferences.”

GPT-4o model, ChatGPT Edu

The Spring Update event in May introduced the GPT-4o LLM for everyone using ChatGPT, including free users. Faster and more capable than GPT-4, the new model can process input modes such as text, image, audio, and video.

OpenAI followed GPT-4o’s launch with a new ChatGPT Edu subscription aimed at university students, faculties, and researchers. While there have been concerns over students using ChatGPT to dodge their homework, OpenAI tried to push the chatbot as a helping hand. For example, students can discuss their assignments with a GPT trained on their course material, which can help them think more deeply.

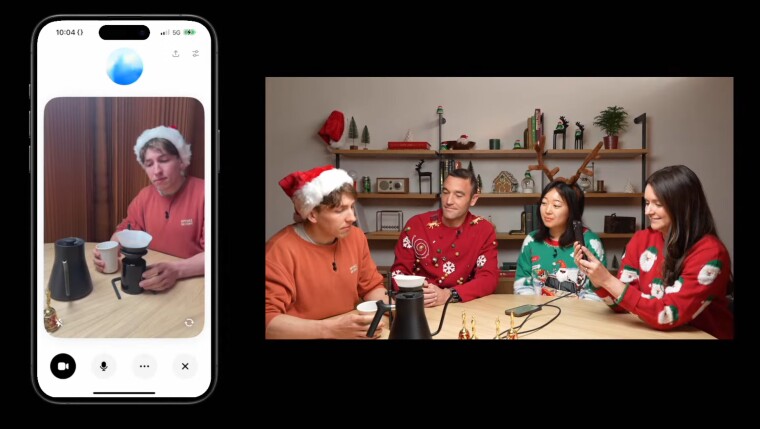

Advanced Voice Mode

GPT-4o also made ChatGPT’s advanced Voice Mode capable of delivering a human-like conversation experience. However, it landed in trouble after one of the female voices spoken by ChatGPT resembled American actor Scarlett Johansson. The actor later said that OpenAI offered to hire her to be one of ChatGPT’s AI voices, but a deal didn’t come to fruition.

Advanced Voice Mode was updated in later months with support for video input, screen sharing, and image uploads, enabling the chatbot to see, hear, and speak in real time.

Apps for Mac and Windows, cloud support

OpenAI also launched the ChatGPT app for macOS at last year’s Spring Update event. Initially available for paid subscribers, ChatGPT’s Mac desktop app was loaded with Voice Mode and the ability to upload files and take screenshots, among various features.

ChatGPT desktop app for Windows was previewed sometime in October and made available to all users in November. Features such as text scaling adjustment, advanced voice mode, and clicking photos using the built-in webcam were also added.

Building on ChatGPT’s data analysis capabilities, OpenAI allowed users to upload files directly from Google Drive and Microsoft OneDrive, enabling the chatbot to access services such as Sheets, Docs, Slides, Excel, Word, and PowerPoint.

ChatGPT also got an expandable view for tables and charts. The chatbot can generate interactive tables from a dataset. Users can switch to a full-screen view and click on specific areas in the table to ask follow-up questions.

The situation became embarrassing for OpenAI after reports that the ChatGPT macOS app stored all the conversations in plain text inside an unprotected file location. The company later fixed it.

ChatGPT in Audi and Mercedes-Benz cars

Not just tech companies, automakers also tried their hands on the generative AI tech. German carmaker Audi announced ChatGPT integration for millions of its models released since 2021. Updated voice control features allow users to operate infotainment, navigation, and AC systems without using their hands. They can also ask general knowledge questions from the ChatGPT-powered Audi assistant.

Last month, Mercedes-Benz also rolled out its ChatGPT integration as a free update to over three million vehicles equipped with its MBUX infotainment system. The automaker developed a new voice experience on top of the Microsoft Azure OpenAI Service, bringing context-aware and up-to-date responses to the drivers. They can press the speech button on the steering or say “Hey Mercedes” to use the feature.

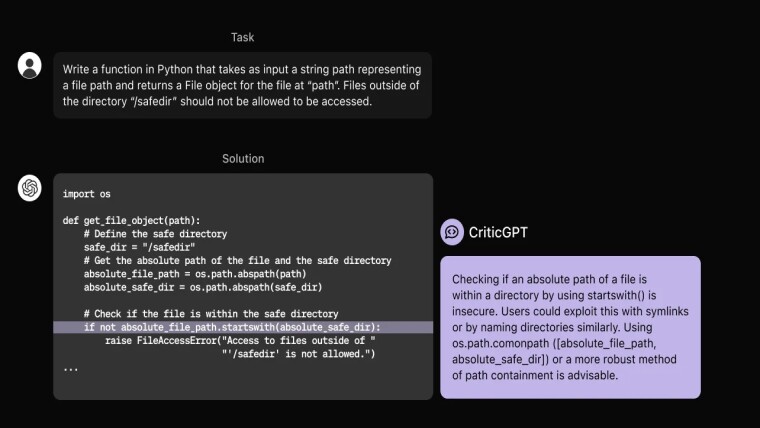

CriticGPT to find mistakes

OpenAI knows that no AI model is perfect, and there might be occasions when things get embarrassing. The company trained a new model called CriticGPT to find mistakes in the code snippets generated by ChatGPT and highlight inaccuracies.

CriticGPT is meant to assist human AI trainers who train and improve ChatGPT’s responses. A model of such kind becomes more critical when a study suggests that programming answers given by ChatGPT could be wrong 52% of the time.

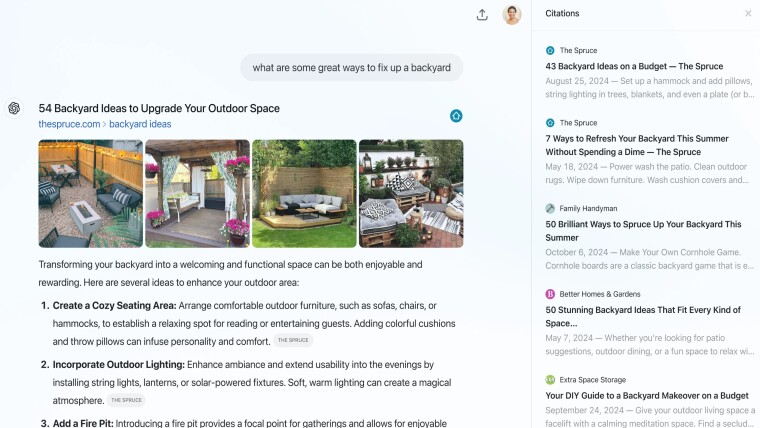

SearchGPT and ChatGPT Search

OpenAI now has an offering to rival Google in the search engine game. While CEO Sam Altman initially denied rumors of a ChatGPT search engine in the making, the company unveiled a prototype called SearchGPT in July.

Instead of simply presenting a list of links, SearchGPT tries to answer user queries with up-to-date information and provides links to the sources used. You can throw follow-up questions at the search engine while continuing the context.

OpenAI released ChatGPT Search in October after testing the prototype version for months. The company partnered with several news organizations to include their content in the ChatGPT search experience.

The search experience was initially limited to paying ChatGPT subscribers but was released to everyone in December. A Chrome extension allows users to use the search engine directly from the browser’s URL bar.

GPT-4o model updates

OpenAI’s updated frontier model, ChatGPT-4o-latest, quickly reclaimed the number one spot in the LMSYS Chatbot Arena. However, the model was intended for research and evaluation only; it supported a context length of 128,000 tokens and 16,384 output tokens.

This happened almost a week after gpt-4o-2024-08-06 was released with support for Structured Outputs in the API and the same number of input/output tokens as chatgpt-4o-latest.

Another GPT-4o API update named gpt-4o-2024-11-20 was pushed in November with improved creative writing ability. OpenAI claimed the model works better with uploaded files, providing deeper insights and more thorough responses.

OpenAI o1, o1-mini

A new large language model called OpenAI o1 was introduced last year that takes more time to think before responding. It is designed to handle complex reasoning tasks, particularly in coding, math, and scientific problem-solving.

However, the o1 model can’t do some of GPT’s tasks, such as finding information on the web or checking out uploaded images and other files. Its smaller, faster, and cheaper version, OpenAI o1-mini, was also launched last year.

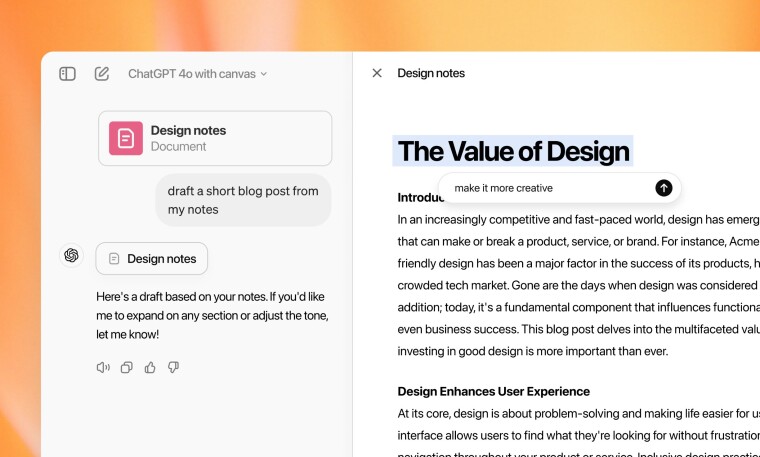

ChatGPT Canvas

Canvas is the first major update to ChatGPT’s visual interface since its debut in 2022. The new interface is designed to work with ChatGPT on specific tasks like writing and coding. It lets you refine prompts using a side panel and offers several usability improvements.

For instance, you can highlight parts of the output and ask ChatGPT to focus on those. You can use shortcuts to perform various tasks, such as adding emojis, reviewing code, suggesting edits, adding comments, and more. The new user interface was made generally available for all users in December during the 12 Days of OpenAI live stream series.

ChatGPT Projects

12 Days of OpenAI event also dropped the ChatGPT Projects feature, which lets users organize their chats about similar topics. In other words, users can create projects to keep related chats, files, and custom instructions in one place.

The feature works with the GPT-4o model and is available to Plus, Pro, and Team subscribers. Support for Enterprise and Edu users will be added in 2025, and Projects will also be available to free users (there is no word on the release date).

Return of Sam Altman to the board

OpenAI’s co-founder and CEO Sam Altman’s abrupt firing from his position and removal from the board in November 2023 sounds like a corporate movie plot. More so because Altman dramatically returned as OpenAI’s CEO just five days later. Meanwhile, the board members who voted to fire him agreed to depart.

WilmerHale, a third-party group appointed to look into the matter, ended up reviewing over 30,000 documents and conducted dozens of interviews with prior board members, OpenAI executives, and others. Altman’s official return to OpenAI’s board was announced in March 2024 after the group found “that his conduct did not mandate removal.”

Lawsuits by Elon Musk

Elon Musk was among the founding members of OpenAI. However, the tech billionaire has started bombarding OpenAI with lawsuits in recent years, mostly revolving around OpenAI’s stance towards becoming a for-profit organization.

In one of the lawsuits filed in early 2024, Musk claimed OpenAI breached its own contract by trying to become a for-profit company rather than the non-profit organization initially set up to benefit humanity.

While there are more layers to the drama, a new motion filed late last year asked for a preliminary injunction to prevent OpenAI’s for-profit transition and accused the company of anti-competitive behavior.

Lawsuits by authors and news agencies

It was not just new features; much legal and corporate drama happened around OpenAI and ChatGPT. Two non-fiction authors sued the AI company and Microsoft at the start of 2024, alleging their work was used without permission to train AI models for ChatGPT and other services.

One of the complainants previously worked for The New York Times (NYT), which had also filed a copyright lawsuit against the two companies. In return, OpenAI accused NYT of tricking ChatGPT into copying its articles, and Microsoft also wanted the court to dismiss parts of the lawsuit filed by NYT.

It was reported in February that lawsuits from more news organizations targeted OpenAI, echoing claims of copying stories from their sites as part of AI training.

Shut down of US presidential candidate chatbots

OpenAI’s updated policies banned using its tools and services to create simulated versions of real election candidates. This was part of its efforts around combating false election information during the 2024 US Presidential elections.

In January, the generative AI company banned a developer who used ChatGPT to simulate Dean Philips, a declared candidate for US President in the Democratic Party. Another chatbot shutdown concerning the declared presidential candidate Robert F. Kennedy Jr was reported in March.