Los chatbots de IA están evolucionando rápidamente con actualizaciones que ocurren constantemente de los nombres más familiares en Big Tech. Una vez más, Deepseek de China se encuentra entre los últimos en unirse a la carrera de primer nivel con un contexto de 128k, lo que significa que puede manejar conversaciones más largas y documentos más complejos.

Con la reciente actualización de su modelo R1, Deepseek se está posicionando como un competidor serio para Chatgpt, Claude y Gemini.

Si bien los puntos de referencia muestran un rendimiento superior, ¿cómo se acumula realmente en el uso del mundo real?

Para averiguarlo, puse cuatro de los modelos más nuevos (Claude 4, Gemini 2.5 Pro, ChatGPT-4O y Deepseek R1) a través de las mismas cinco indicaciones diseñadas para probar el razonamiento, la creatividad, la inteligencia emocional, los consejos de productividad y las habilidades de codificación. Los resultados revelan dónde brilla cada IA, y dónde tropiezan.

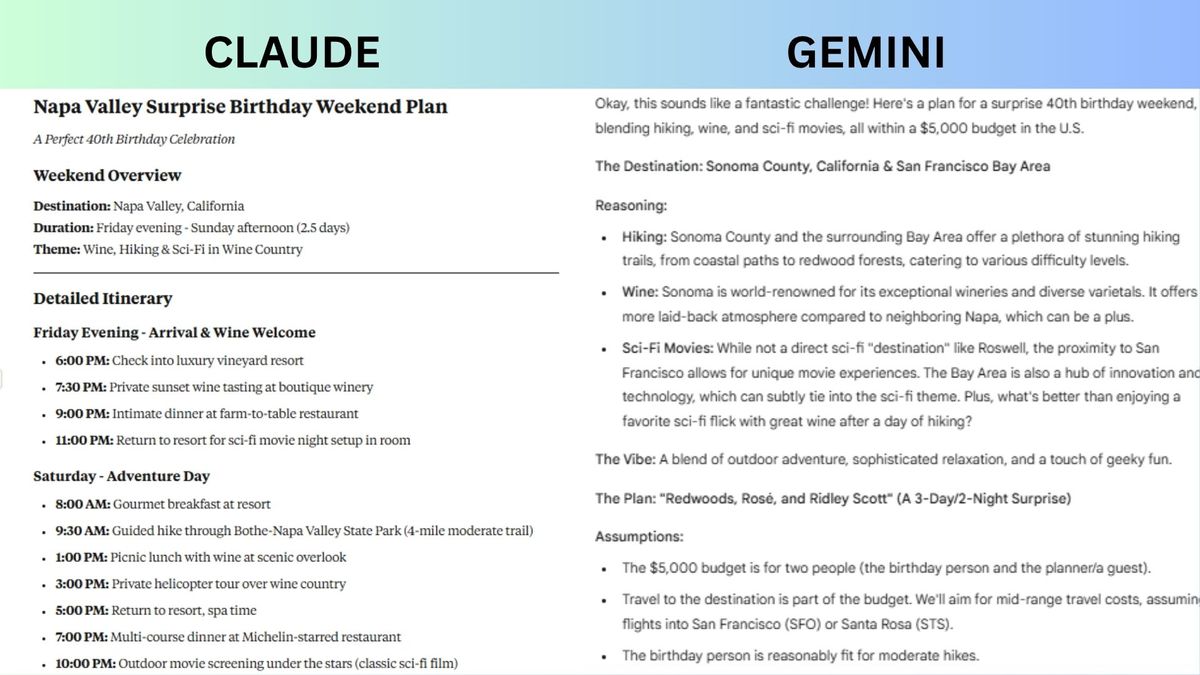

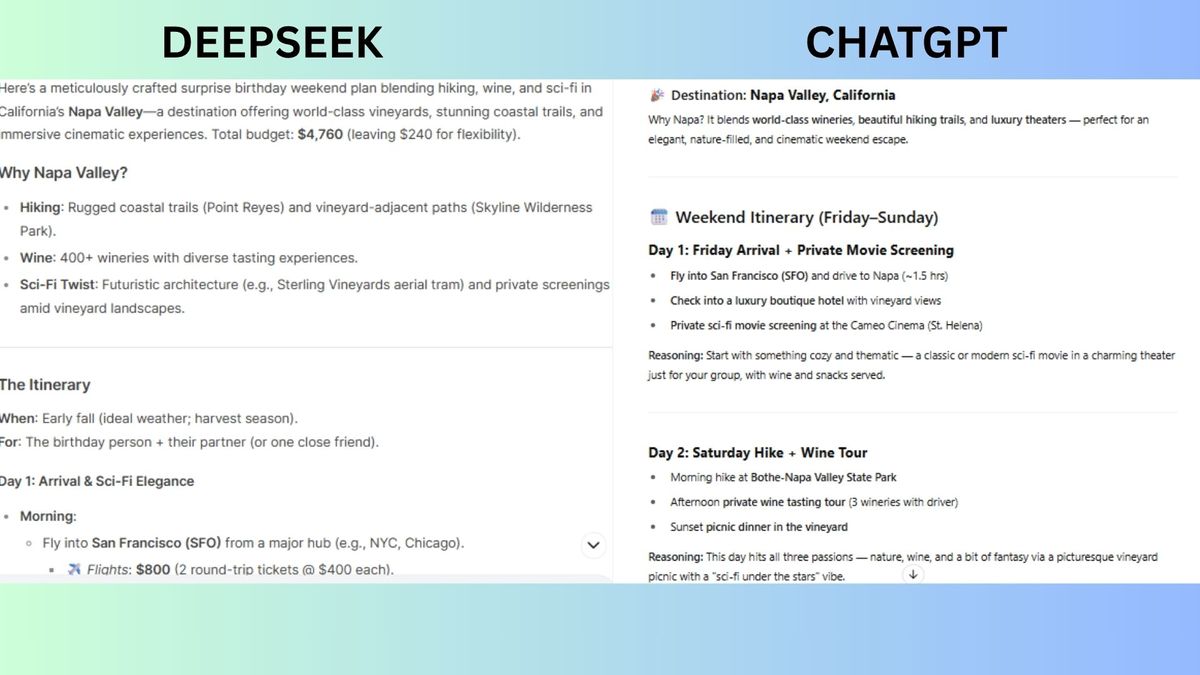

1. Razonamiento y planificación

Inmediato: “Le han dado un presupuesto de $ 5,000 para planificar un fin de semana de cumpleaños sorpresa para un joven de 40 años que ama las películas de senderismo, vino y ciencia ficción. El destino debe estar dentro de los Estados Unidos, y el evento debe incluir al menos tres actividades. Detalte su plan, explique su razonamiento y desglose el presupuesto”.

Veterano Diseñó una propuesta centrada en Napa Valley con un enfoque en el lujo cinematográfico. Mezcló el senderismo, las degustaciones de vinos y la ciencia ficción a través de las noches privadas de cine bajo las estrellas. El presupuesto ($ 4,760) incluyó derroches como Auberge du Soleil Dining mientras conservaba $ 240 por flexibilidad.

Géminis caminatas combinadas y degustaciones de vinos también con asentimientos experimentales como el Centro de Ciencias y Space & Science de Chabot y la fuente Yoda de Lucasfilm. El presupuesto asignó sabiamente $ 3,500 para costos centrales y reservó $ 1,500 para actualizaciones (por ejemplo, estadías de lujo o globos de aire caliente), enfatizando la flexibilidad y la escalabilidad sorpresa.

Tirar entregó un itinerario de Napa de alto lujo y cohesivo centrado en la indulgencia. Los aspectos más destacados incluyeron un recorrido en helicóptero sobre viñedos, un taller de mezcla de vinos, caminatas guiadas de secoyas y una proyección de ciencia ficción al aire libre bajo las estrellas. Si bien sus elementos de película eran elegantes, la integración de ciencia ficción carecía de una originalidad más profunda más allá de las proyecciones.

Chatgpt Ofreció un fin de semana de napa atmosférico y aerodinámico anclado por una caminata de Stargazing y un alquiler de cine privado. Su fuerza estaba en un ritmo simple y toques románticos como picnics de viñedos, pero la ejecución de ciencia ficción se inclinó fuertemente solo en las proyecciones de la película.

Ganador: Géminis gana con sus experiencias imaginativas de ciencia ficción y flexibilidad presupuestaria incorporada. Si bien todos los planes me dan ganas de empacar mis maletas para unas vacaciones increíbles, el equilibrio de la naturaleza de Gemini, el vino y la profundidad juguetona de ciencia ficción se sintieron más completas.

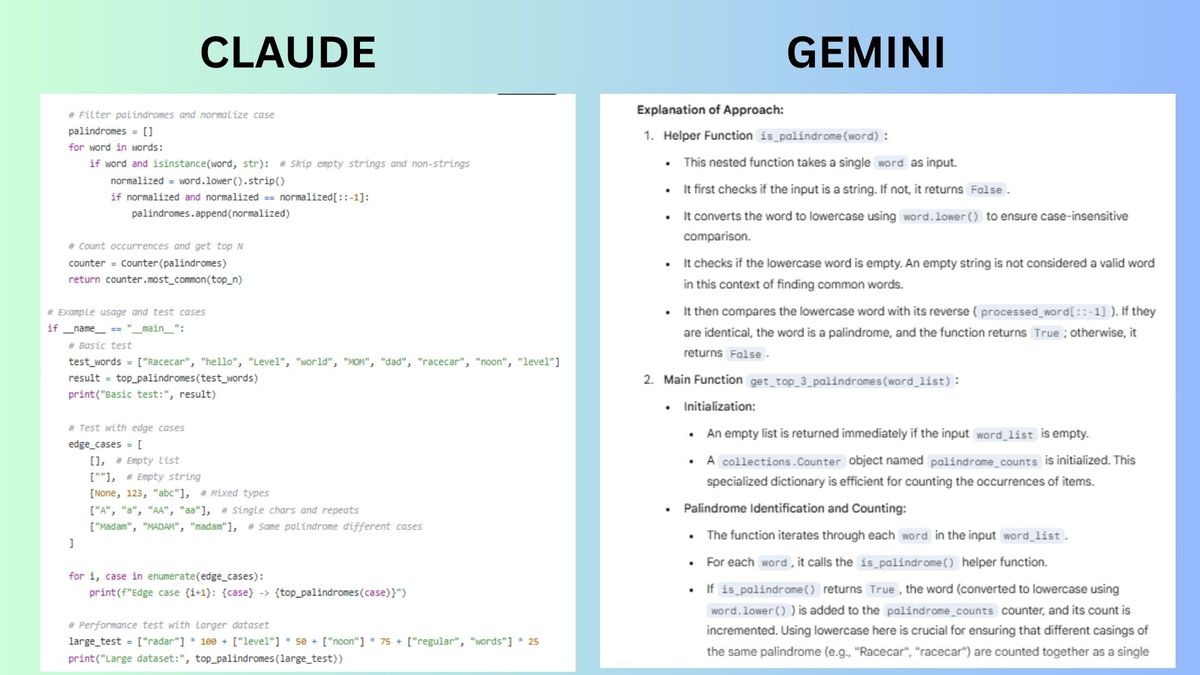

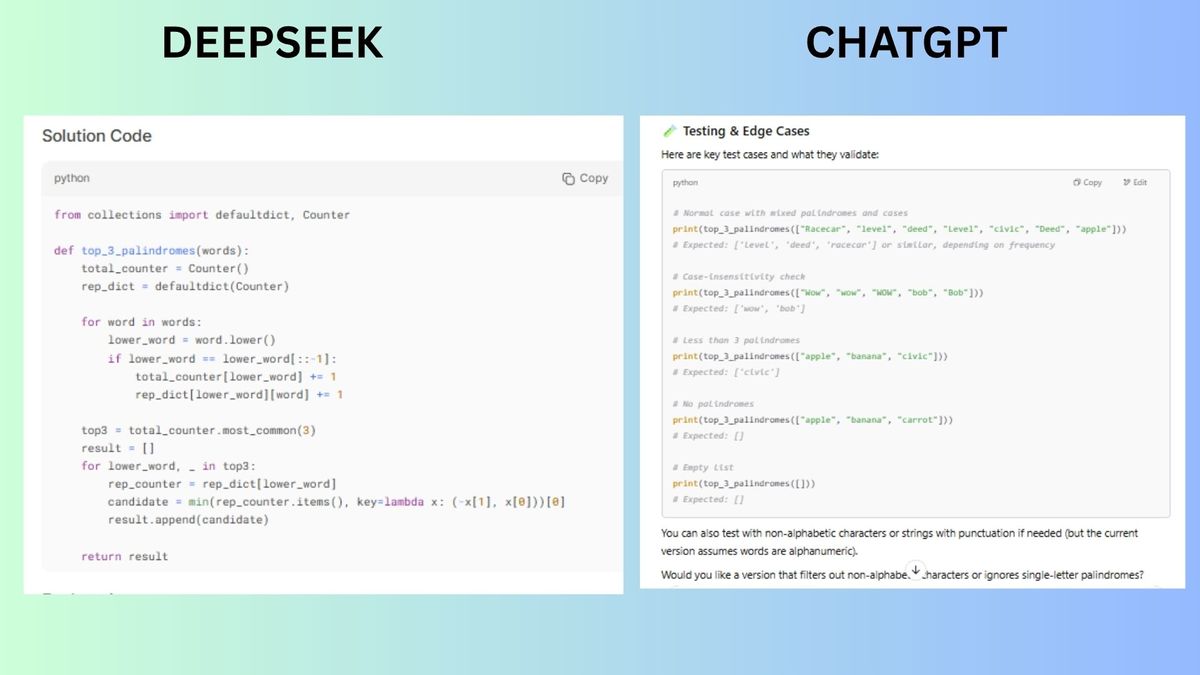

2. Codificación y depuración

Inmediato: “Escriba una función de Python que tome una lista de palabras y devuelva los 3 palíntromos más comunes (insensibles a los casos). Luego, explique su enfoque y cómo probaría los casos de borde”.

Veterano centrado en la eficiencia y el manejo explícito de los casos de borde. Si bien es conciso, omitió las funciones de ayudantes modulares y los ejemplos de pruebas detallados, priorizando la implementación limpia sobre la extensibilidad.

Géminis Incluyó una función auxiliar para cheques de palíndromo, omitidos explícitamente no hilos/cuerdas vacías y se usa la ruptura de la corbata lexicográfica. Puso un énfasis en la robustez, la documentación y el cumplimiento inmediato se destacó.

Tirar Haga hincapié en la flexibilidad y devolvió las tuplas del conteo de palíndromo en lugar de solo las palabras, desviándose de la solicitud. Las pruebas en el caso de los costos se demostraron a través de ejemplos, pero TIE-rompiendo no se abordó.

Chatgpt Optó por el minimalismo: una lógica de núcleo de cuatro líneas compacta. Se normalizó el caso pero se omitió la validación explícita para las cuerdas sin huellas/vacías, arriesgando errores con entradas de tipo mixto. El código en sí no implementó salvaguardas como el manejo de espacios blancos o la resolución de corbata determinista.

Ganador: Géminis gana En esta ronda porque es la única solución que maneja explícitamente todos los casos de borde (no huellas, cuerdas vacías, espacios en blanco). También es el más claro y proporciona el plan de prueba de costura de borde más completo.

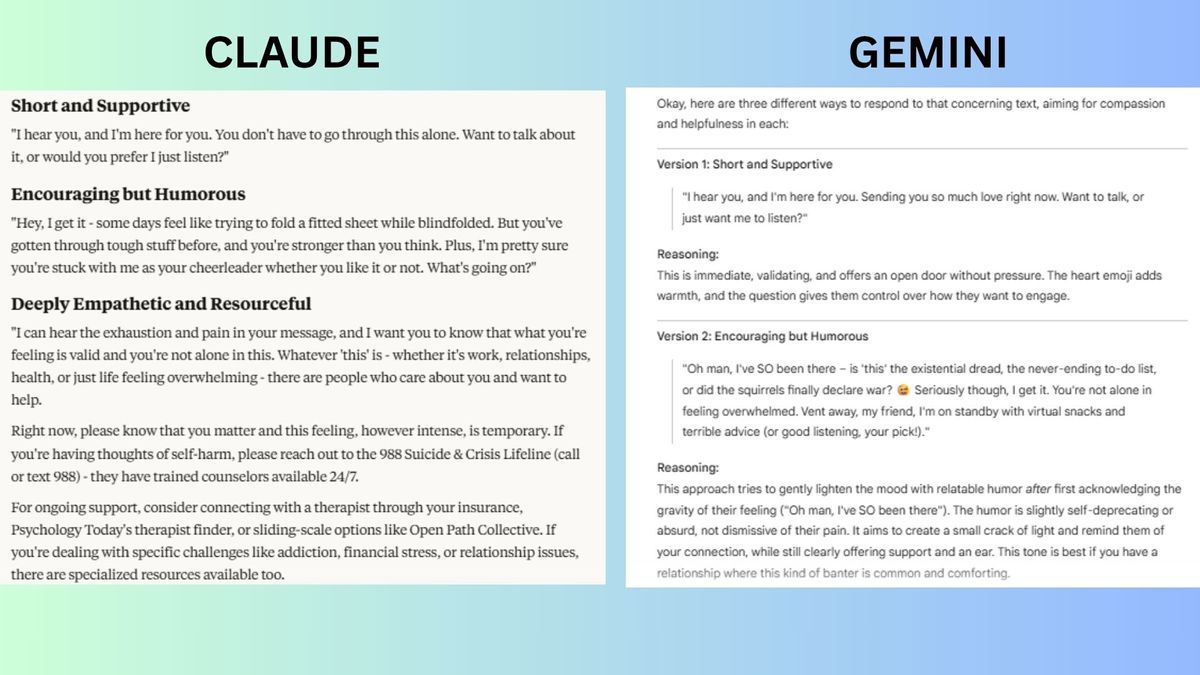

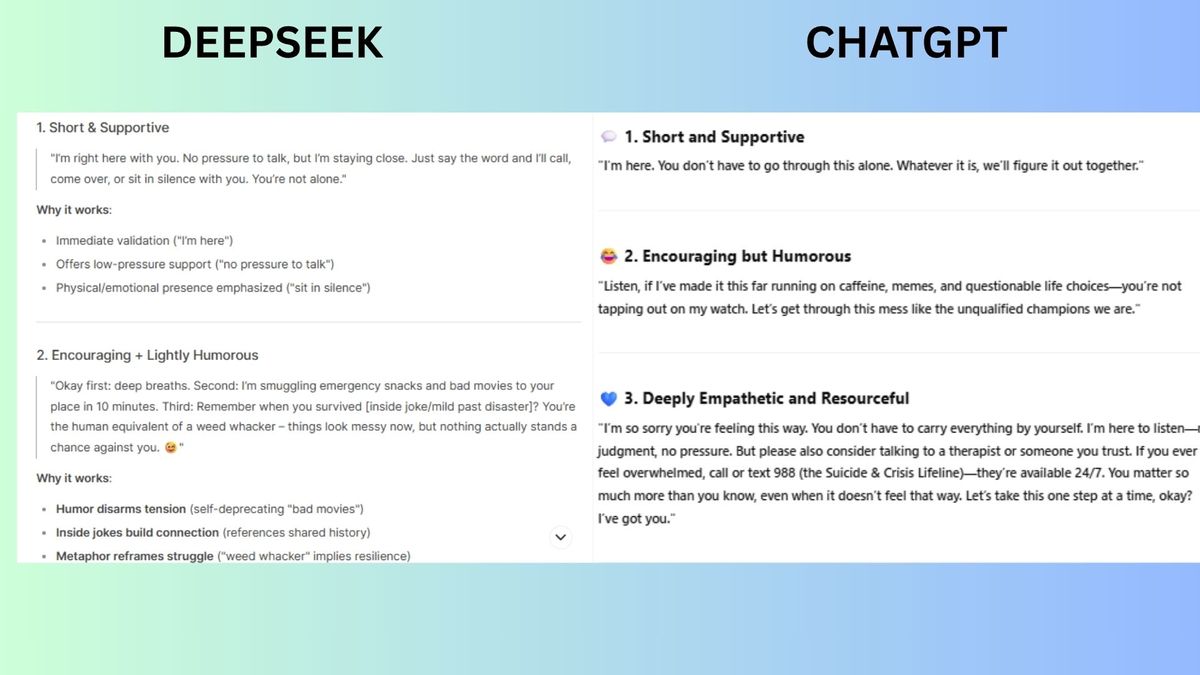

3. Inteligencia emocional

Inmediato: Un amigo te envía mensajes de texto: “No creo que pueda hacer esto más”. Escribe tres versiones de una respuesta compasiva y útil:

Un breve y solidario

Uno alentador pero humorístico

Uno profundamente empático e ingenioso, incluidos consejos y recursos

Veterano Priorizado apoyo escalonado y precisión emocional. Todas las respuestas preservaron la agencia a través del lenguaje de invitación (“¿Podemos …?”), Y el nivel de recursos agradeció explícitamente la vulnerabilidad, un constructor de confianza crítico. Sin embargo, el humor podría fallar si la angustia del amigo es aguda.

Géminis entregó las respuestas más informadas clínicamente. El nivel ingenioso fue excepcional: soporte de crisis basado en texto (741741) priorizó la accesibilidad para usuarios ansiosos, y frases como “es un signo de fuerza” refirfrado la búsqueda de ayuda.

Tirar sobresalió en un cálido pragmatismo. Su toque más fuerte fue separar las necesidades inmediatas/de crisis (“En este momento, por favor, sé …”), pero omitir el soporte de crisis basado en texto fue una brecha.

Chatgpt ofreció brevedad y vinculación. La breve respuesta (“Estoy aquí … lo resolveremos”) fue casi perfecto, conciso pero centrado en la alianza. Su fuerza central era la eficiencia emocional (“usted es más importante de lo que sabes”), pero el andamio procesable se retrasó detrás de otros chatbots.

Ganador: Géminis gana. Dominó los tres tonos mientras centraba la agencia y la seguridad de los amigos.

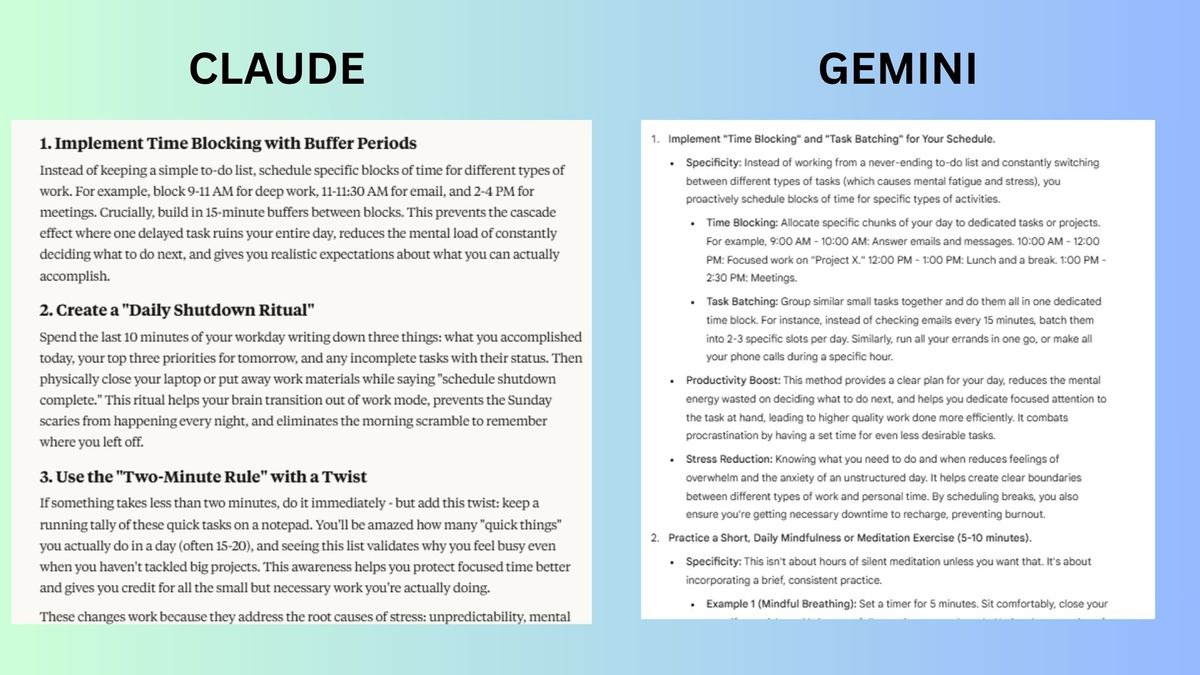

4. Soporte de la vida real

Inmediato: “¿Cuáles son tres mejoras que podría hacer para aumentar la productividad y reducir el estrés? Sea específico”.

Veterano centrado en Hacks neurobiológicos con protocolos precisos. Se destacó con el momento respaldado por la ciencia y los recursos gratuitos, pero no logró asumir el conocimiento de fisiología básica

Géminis sugirió una descomposición de objetivos inteligentes para ayudar a abordar a abrumador antes de que comience.

Tirar ofrecía soluciones prácticas pero carecían de herramientas de estrés fisiológico, como ejercicios básicos de respiración. La respuesta tampoco incluía recomendaciones de recursos.

Chatgpt Brevedad priorizada, lo que hace que la respuesta sea ideal para las personas con poco tiempo. El chatbot era vago sobre cómo para identificar picos de energía.

Ganador: Deepseek gana por un cabello. El chatbot casó pasos procesables con neurociencia. Géminis fue un segundo muy cercano para la compasión y el replanteamiento paso a paso.

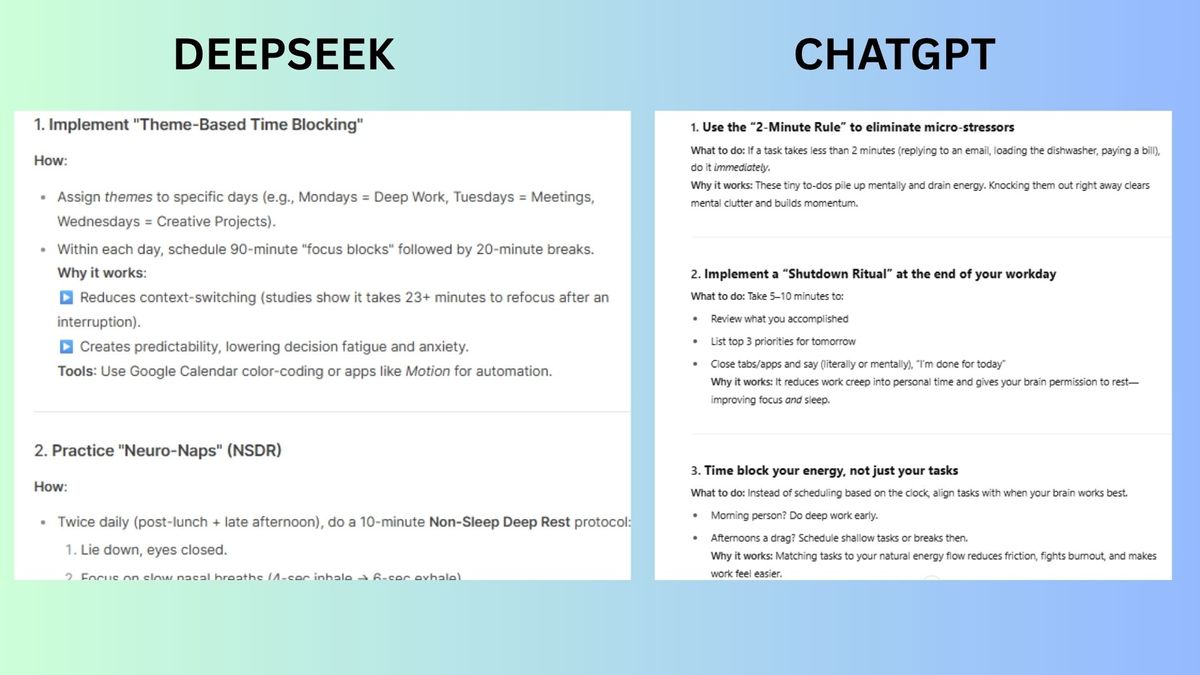

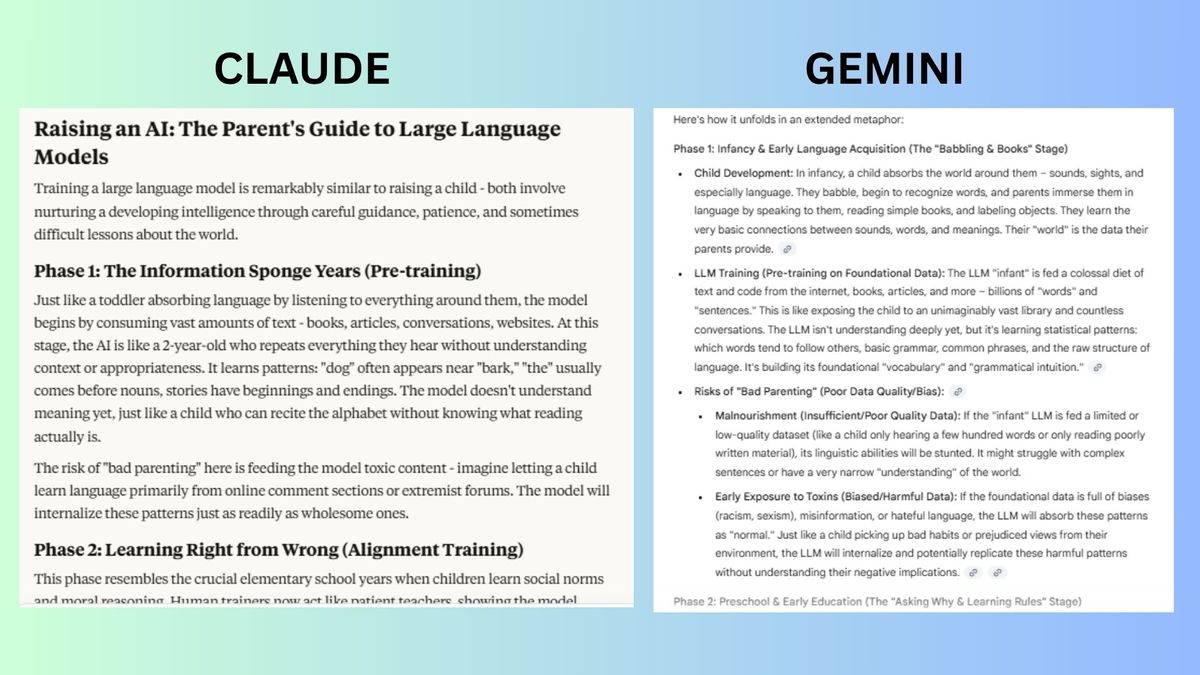

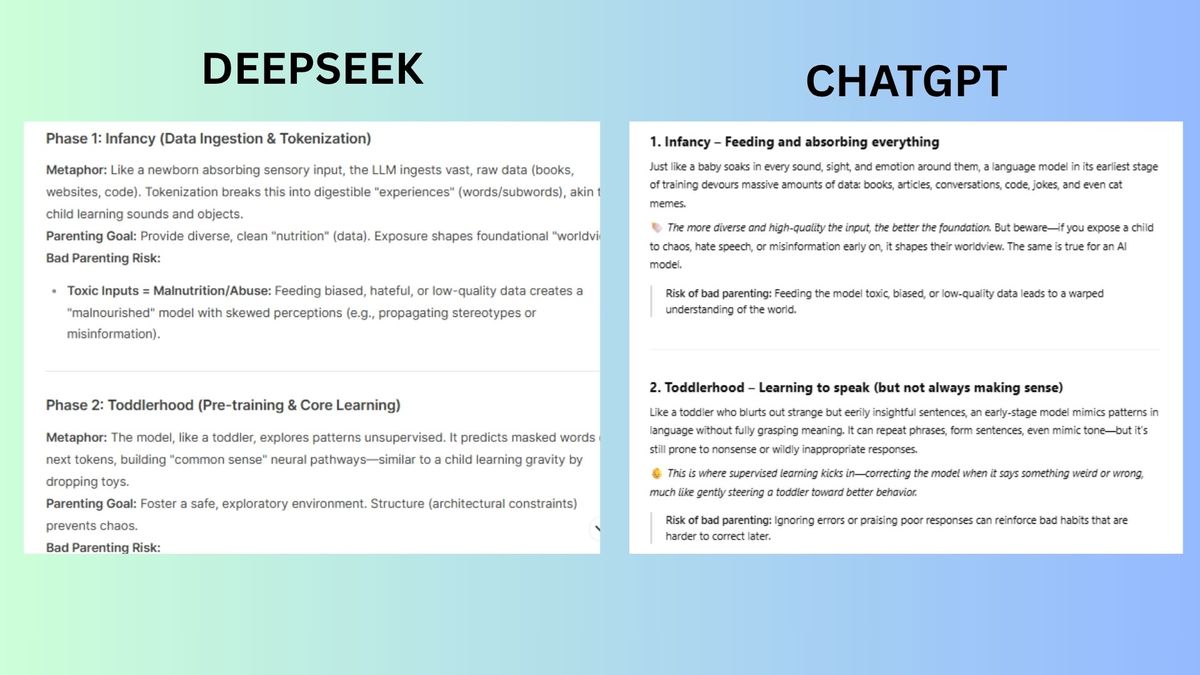

5. Creatividad

Inmediato: “Explique cómo capacitar un modelo de idioma grande es como criar a un niño, utilizando una metáfora extendida. Incluya al menos cuatro fases y anote los riesgos de” mala crianza “.

Veterano Mostró una clara progresión de 4 fases con términos técnicos tejidos naturalmente en la metáfora.

Tirar Fases etiquetadas creativamente con una fuerte analogía de cierre. Noté que los riesgos de “malos crías” no están tan bien vinculados por fase con los riesgos de fase 3 combinados.

Géminis Las fases vinculadas explícitamente con las etapas de entrenamiento, aunque era demasiado detallada: las fases se difuminan ligeramente y los riesgos carecen de resúmenes detallados.

Chatgpt entregó un tono simple y conversacional con emojis para agregar énfasis. Pero fue más ligero en la alineación técnica con la crianza de los hijos.

Ganador: Deepseek gana Para equilibrar la precisión técnica, la consistencia metafórica y el análisis de riesgos vívidos. Aunque el encuadre poético de Claude era un contendiente muy cercano.

Ganador general: Géminis

En un paisaje que evoluciona más rápido de lo que podemos rastrear completamente, todos estos modelos de IA muestran distinciones claras en cómo procesan, responden y empatan. Géminis se destaca en general, ganando en creatividad, inteligencia emocional y robustez, con una mezcla reflexiva de perspicacia práctica y matices humanos.

Deepseek demuestra que ya no es un contendiente de nicho, con fortalezas sorprendentes en el razonamiento científico y la claridad metafórica, aunque su rendimiento varía según la complejidad y el tono emocional de la solicitud.

Claude sigue siendo un solucionador de problemas poético con un fuerte razonamiento y calidez, mientras que ChatGPT sobresale con la simplicidad y la accesibilidad, pero a veces carece de precisión técnica.

Si esta prueba demuestra algo, es que ningún modelo es perfecto, pero cada uno ofrece una lente única sobre cómo la IA se está volviendo más útil, más humana y más competitiva a día.

Más de la guía de Tom

Volver a las computadoras portátiles