Gemini vs ChatGPT – which generative AI chatbot should you use to answer questions, create content, design code, and more? Ultimately, there’s no easy answer. Comparing Gen AI bots isn’t easy, particularly as leading vendors frequently update their models.

For instance, in December 2024, Google announced the release of Gemini 2.0—the most capable model it’s created so far (although companies always seem to say that). Similarly, ChatGPT introduced the world to a new set of advanced reasoning models (the o1 models), available within ChatGPT, specially designed for “deep thinking” tasks.

We can spend all day discussing how each company’s different models work. But for this particular comparison, we’re going to focus on the central “chatbot” experience offered by Google (Gemini) and OpenAI (ChatGPT).

Let’s dive in.

Gemini vs ChatGPT: A Quick Overview

When generative AI started heating up, comparing different models was much easier. Everyone was rushing to get a “bot” out there that was good enough to compete with ChatGPT, but most struggled to keep up. For instance, Google’s previous model, Bard, outperformed an earlier version of ChatGPT in a few key enterprise-focused areas, but ChatGPT was more user-friendly.

Now, the gap between Gemini and ChatGPT is closing. Google has constantly upgraded its Gemini family (as evidenced by the release of Gemini 2.0). It’s also been tackling various issues that made Gemini less appealing in the past (like the high number of hallucinations it had).

On the other hand, OpenAI has been introducing more functionality to ChatGPT too. The free plan has been significantly upgraded in recent years. Plus, we have more features for enterprise users too – with the introduction of the o1 models, and the ChatGPT Team and Enterprise plans.

Here’s a quick side-by-side look at both options.

| ChatGPT | Gemini | |

| Creator: | OpenAI | |

| Models: | GPT-4o mini (available for free), GPT 4o, GPT-4, GPT o1, GPT o1 Mini, and GPT o1 Pro | Gemini 1.5 Flash, Gemini 1.5 Pro, and Gemini 2.0 Flash |

| Context Windows: | 128k tokens | 2 million tokens + |

| Languages: | Over 50 | Over 40 |

| Platforms | Web, mobile, and desktop | Web, mobile, and within Google apps |

| Pricing: | Free plan with paid plans starting at $20 per month | Free plan, with paid plans starting at $20 per month |

| Integrations | Add-ons and plugins | Google apps |

| Developer access | Yes | Yes |

Gemini vs ChatGPT: The Core Similarities

Before we look at how Google Gemini and ChatGPT stack up for specific business use cases, let’s look at the similarities the two solutions have.

- Multimodal capabilities: Both Gemini and ChatGPT are powered by multimodal AI models. They can process text, images, and audio. However, Gemini has “image output” as an option on the free plan, while you need a paid plan for this with ChatGPT.

- Web access: Both apps can search the web for real-time data to inform responses. However, Google Gemini is powered by Google Search, while ChatGPT uses Bing.

- Data management: With each chatbot, users can turn memories on or off, delete conversations, and have “temporary” chats. However, ChatGPT does allow you to archive conversations, whereas Gemini doesn’t.

- Device support: Both ChatGPT and Gemini are available on mobile and web apps. Notably, though, ChatGPT does offer a desktop app, too.

- Sharing: Gemini and ChatGPT both allow users to share their conversations with others. However, you can’t share conversations through ChatGPT that include images.

- Data analysis: Each model can analyze data and provide insights, summaries, and feedback about it. They can also turn your data into various visualizations and graphs.

- Free plans: Both companies offer a free version of their generative AI chat tool with certain limitations. In our opinion, the free plan for ChatGPT is more generous (more on that later).

The Models Powering the Bots

One other thing both Gemini and ChatGPT have in common is they’re both powered by multimodal AI models. ChatGPT is currently using two families of models: The GPT-4o collection, and the newer o1 family of reasoning models. Google Gemini is powered by the “Gemini” models, such as Gemini Flash 1.5, Gemini 1.5 Pro, and now Gemini 2.0 Flash (in testing).

Each model collection has its own distinct strengths and weaknesses. ChatGPT, for instance, has a much smaller “context window” (128k tokens) than Gemini (over 2 million). This means it can recall information for longer. However, OpenAI’s o1 model excels at logical thinking, thanks to chain-of-thought reasoning that allows it to analyze complex problems.

Gemini 2.0 is better at offering companies and developers the tools they need to create “autonomous agents”, although you can create custom bots with ChatGPT. Both tools also support both text and image generation. However, ChatGPT uses DALL-E 3 (a slightly more mature model), while Google relies on Imagen 3 – it’s new text-to-image generator.

Both apps also have a memory bank, although these banks work a little differently. ChatGPT has its memory turned on by default for paid users, and collects information about you to tailor responses. With Gemini, you “add memories” to your settings manually.

Let’s dive a little deeper into the differences between the bots.

Gemini vs ChatGPT: Integration Options

Part of what makes Gemini so appealing for enterprise users, is that it’s already deeply integrated into the Google ecosystem. Aside from having access to Gemini via the chatbot app and Google Search, you can also access Gemini in Google Workspace and other apps.

Plus, you can ask Gemini to draw information from your Google data. For instance, you can ask it to pull details from Gmail message, share access to a link in Google Drive, and so on. You can even export Gemini responses to Gmail and Google Docs.

ChatGPT can integrated with Google Drive to read your content there, but you’ll need to connect your Google account and tell it exactly what to read. While ChatGPT has limited “integration” options, it does offer access to an API, and a range of plugins, to customize your experiences.

You can also link ChatGPT to Zapier to align it with the other apps you’re using. Plus, you can build your own custom-made chatbots designed to do certain things.

That takes us to our next comparison point.

Custom Chatbot / Agent Creation

In the past, Google fell behind ChatGPT in terms of “chatbot creation” options. OpenAI allows Plus, Enterprise, and Pro users to create custom chatbots in minutes. There are no limits to how many GPTs you can build, and all you need to do is tell the builder (in English) what you want to create.

These custom GPTs can generate images with DALL-E 3, run code, and browse the web. You can also customize them with knowledge files. For custom GPTs, Google previously only offered “Gemini Gems”, to Advanced, Business, and Enterprise users. The solution is similar to the OpenAI GPT builder, and allows you to create bots with natural language. However, you can’t use Gems to generate AI images.

What gives Google a slight edge over OpenAI now, is that it’s giving companies more ways to create autonomous agents. While OpenAI is experimenting with agentic AI, Google is actively giving developers access to a range of tools for building autonomous agents within Vertex AI.

Users can now experiment with Gemini 2.0 Flash (Experimental) to create agents capable of completing various tasks in sequence. These agents can understand multimodal inputs, and generate content in different formats too. Google has already introduced some of the potential of autonomous AI within its platform with Project Mariner (you can learn more about that here).

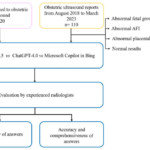

Responses to Queries: Accuracy and Hallucinations

Accuracy is a major comparison point for any business investing in generative AI. Both Google Gemini and ChatGPT have their pros and cons, and both seem to struggle with hallucinations. Notably, Google has taken steps to reduce hallucinations lately, but its responses aren’t always entirely accurate. Gemini 2.0 Flash, for instance, earned a score of 83.6% in factual grounding tests.

One thing that makes Gemini a little problematic, is that it doesn’t always include citations in its answers – so you can’t always find the original source where it extracted its data from. ChatGPT can produce citations, however it’s worth noting that they don’t always lead to an actual data source.

ChatGPT definitely sounds like it knows what it’s talking about more than Gemini. It delivers more “confident” responses to questions, and can explain concepts in depth pretty easily. The o1 models also outperform Gemini in terms of reasoning and logical understanding.

As an example, the o1 model answered 83% of the questions in an International Mathematics Olympiad test correctly. Google hasn’t exposed its bots to the exact same tests. However, the Gemini 2.0 Flash model did earn a 62.1% score on the GPQA diamond reasoning test. That’s not exceptional – but it is better than what the previous models accomplished.

Content Generation Performance

If you’re planning on using generative AI for content creation, Gemini and ChatGPT both have strengths and weaknesses again. When I asked both Gemini and ChatGPT to write a poem about a bird in a cage, I liked the tone of Gemini’s answer slightly more, but ChatGPT created a much longer poem, with more detail and unique elements.

Gemini’s response seemed to be a little basic – but that could be because I was using the free version of both apps, and Gemini’s free plan doesn’t give you access to the most advanced models. On the plus side, Gemini does outperform ChatGPT in terms of image generation – to a degree.

Although DALL-E 3 is excellent at creating high-quality images, you can’t create visuals on the free plan – while you can with Gemini.

Notably, the images you can create on the paid versions of ChatGPT are a lot better if you’re looking for artistic, imaginative output. Gemini seems to excel at hyper-realistic images, and does a lot better at generating text in visuals without errors.

Gemini vs ChatGPT: Coding Proficiency

Since I’m not a coder myself, I have a hard time comparing bots based on their programming abilities. Based on what I’ve found through research though, ChatGPT is very good at producing code. The GPT 4o model is fantastic for producing code snippets and debugging issues quickly. The o1 models are even more effective for advanced coding challenges.

According to OpenAI, the o1 (full) model reached the 89th percentile in Codeforces contests, and excels at dealing with difficult languages and debugging problems. Again, Google hasn’t exposed Gemini to the exact same coding tests, so it’s hard to get a full comparison.

In the Natural2Code tests, Gemini 1.5 Pro got a score of 85.4% and Gemini 2.0 Flash Experimental got a score of 92.9%. However, both Google models seemed to perform poorly in tests related to converting natural language into SQL, and generating code in Python.

Ethical Reasoning and Safety

The good news for businesses addressing AI governance, safety, and security, is both Google and OpenAI are invested in responsible AI. Both Gemini and ChatGPT will refuse to produce “damaging content”, if they consider a request to be unethical.

According to Google, Gemini 2.0’s reasoning capabilities now make the model more effective at understanding risks, and safeguarding users against dangerous content. However, Google hasn’t revealed too much information about how these reasoning capabilities work.

We do know that Google Gemini implements guardrails to minimize the production of dangerous content. Plus, users do have control over how much data they “save” within Gemini chat logs. There are even enterprise-grade protections in place for paid plan users.

OpenAI also uses ethical and safety guardrails in its ChatGPT models. Plus, it offers companies access to administrative and security controls in plans like ChatGPT Team and Enterprise. Notably though, we do have a little more information about OpenAI’s approach to AI responsibility – at least with the recent o1 models.

With these models, the company used a new training approach to help ensure that the models could understand dangerous and unethical requests more effectively. Plus, these training strategies have made the model more effective at mitigating “jailbreak” attempts. In a complex jailbreak test, the o1 model scored 84 out of 100, compared to GPT-4o’s score of 22.

Gemini vs ChatGPT: Which is the Better Free App?

Ultimately, ChatGPT’s free plan is a lot more impressive than the one you’d get from Gemini, for a few reasons. OpenAI has upgraded its free plan in recent years to ensure that users can now browse the internet with ChatGPT, and access up-to-date models, like GPT-4o (limited) and GPT-4o mini. However, you can’t use the o1 models on the free plan yet.

ChatGPT’s free plan also allows users to use custom GPTs (although you can’t create them), and upload files for analysis (on a limited basis). There’s also an included voice mode for interacting with ChatGPT naturally – but no image generation options.

Google Gemini’s free plan gives you access to all of the basic features you need to create content (including images), and ask Gemini questions. The bot can surf the web, and you can use the app to analyze certain file uploads. However, you’ll need to upgrade to a paid plan to gain access to experimental models like Gemini 2.0, and leverage advanced functions.

On the plus side, Gemini’s free plan does allow you to connect the app with multiple Google solutions, like Google Maps, Flights, and so on.

Paid Plans: Gemini vs ChatGPT

Google only has one “paid plan” for the specific Gemini bot – although there are a bunch of plans available for API access, and Gemini within Google Workspace. The core paid plan for the Gemini bot, is “Gemini Advanced” which costs $20 per month, per user.

This gives you full access to the Gemini 1.5 Pro model, access to experimental Gemini models, Deep research functionality, and Gems for building custom bots. You also get 2TB of storage from Google One, and access to Gemini in Gmail, Docs, and other tools.

OpenAI has a much wider range of plans to choose from for ChatGPT (even before you dive into API options). There’s ChatGPT Plus, for $20 per month, with extended limits on messaging, file uploads, and so on, and access to GPT creation tools. You also get limited access to o1 and o1-mini on this plan. Then there’s the “business-level” plans.

ChatGPT Team for $30 per month, per user, billed monthly, comes with higher message limits than Plus, standard and advanced voice mode, an admin console, and team data protections. ChatGPT Enterprise (for a custom price), includes all the features of Team, and high-speed access to GPT-4 models. You also get DALL-E, expanded context windows, and admin controls and analytics.

The latest OpenAI plan, ChatGPT Pro, for $200 per month, comes with all the features of the Plus plan, unlimited access to advanced voice, and unlimited GPT-4o and o1 access. Plus, you get access to o1 Pro mode – the latest o1 model.

Gemini vs ChatGPT: Which is Better

So, based on all of these findings, which chatbot is better for businesses? Ultimately, it all depends on what you need. If you’re looking for an intuitive chatbot that gives you more control over security, and access to advanced reasoning models, and coding capabilities, ChatGPT might be the better choice. I think ChatGPT is better for coding, content creation (in general), and security.

Gemini, on the other hand, is definitely the better option for people who already use Google products, like Workspace and Gmail, since it integrates deeply with these apps. It’s also the better solution for custom chatbot or agent creation – thanks to the rise of Gemini 2.0.

My advice? Test the free versions of both bots and make your decision from there.