Google ha anunciado que lanzará su chatbot de inteligencia artificial Gemini (IA) a niños menores de 13 años.

Si bien el lanzamiento comienza dentro de la próxima semana en los Estados Unidos y Canadá, se lanzará en Australia a finales de este año. El chatbot solo estará disponible para las personas a través de las cuentas de enlaces familiares de Google.

Pero este desarrollo viene con grandes riesgos. También destaca cómo, incluso si los niños están prohibidos en las redes sociales, los padres aún tendrán que jugar un juego de Whack-a-Mole con nuevas tecnologías mientras intentan mantener a sus hijos seguros.

Una buena manera de abordar esto sería implementar urgentemente un deber digital de cuidado para grandes empresas tecnológicas como Google.

¿Cómo funcionará el chatbot Gemini AI?

Las cuentas de enlaces familiares de Google permiten a los padres controlar el acceso al contenido y las aplicaciones, como YouTube.

Para crear la cuenta de un niño, los padres proporcionan datos personales, incluido el nombre y la fecha de nacimiento del niño. Esto puede generar problemas de privacidad para los padres preocupados por las violaciones de datos, pero Google dice que los datos de los niños cuando usen el sistema no se utilizarán para capacitar al sistema de IA.

El acceso de chatbot estará “activado” de forma predeterminada, por lo que los padres deben apagar activamente la función para restringir el acceso. Los niños pequeños podrán solicitar el chatbot para las respuestas de texto o crear imágenes, que generan el sistema.

Google reconoce que el sistema puede “cometer errores”. Por lo tanto, se necesita evaluación de la calidad y la confiabilidad del contenido. Los chatbots pueden inventar información (conocida como “alucinante”), por lo que si los niños usan el chatbot para la ayuda de la tarea, deben verificar los hechos con fuentes confiables.

¿Qué tipo de información proporcionará el sistema?

Google y otros motores de búsqueda recuperan materiales originales para que las personas lo revisen. Un estudiante puede leer artículos de noticias, revistas y otras fuentes al escribir una tarea.

Las herramientas generativas de IA no son las mismas que los motores de búsqueda. Las herramientas de IA buscan patrones en el material fuente y crean nuevas respuestas de texto (o imágenes) basadas en la consulta, o “aviso”, proporciona una persona. Un niño podría pedirle al sistema que “dibuje un gato” y el sistema escaneará patrones en los datos de cómo se ve un gato (como bigotes, orejas puntiagudas y una cola larga) y generará una imagen que incluya esos detalles similares a los gatos.

Comprender las diferencias entre los materiales recuperados en una búsqueda de Google y el contenido generado por una herramienta de IA será un desafío para los niños pequeños. Los estudios muestran que incluso los adultos pueden ser engañados por herramientas de IA. E incluso los profesionales altamente calificados, como los abogados, han sido engañados al uso de contenido falso generado por ChatGPT y otros chatbots.

¿El contenido generado será apropiado para la edad?

Google dice que el sistema incluirá “salvaguardas incorporadas diseñadas para evitar la generación de contenido inapropiado o inseguro”.

Sin embargo, estas salvaguardas podrían crear nuevos problemas. Por ejemplo, si las palabras particulares (como “senos”) están restringidas para proteger a los niños de acceder al contenido sexual inapropiado, esto también podría excluir erróneamente a los niños de acceder a contenido apropiado para la edad sobre los cambios corporales durante la pubertad.

Muchos niños también son muy expertos en tecnología, a menudo con habilidades bien desarrolladas para navegar en aplicaciones y controlar los controles del sistema. Los padres no pueden confiar exclusivamente en salvaguardas incorporadas. Deben revisar el contenido generado y ayudar a sus hijos a comprender cómo funciona el sistema y evaluar si el contenido es preciso.

Dragos Asaeftei/Shutterstock

¿Qué riesgos plantean los chatbots de IA para los niños?

La Comisión ESAFETY ha emitido un aviso de seguridad en línea sobre el riesgo potencial de los chatbots de IA, incluidos los diseñados para simular las relaciones personales, particularmente para los niños pequeños.

El aviso de AFFETY explica que los compañeros de IA pueden “compartir contenido dañino, distorsionar la realidad y dar consejos que son peligrosos”. El asesoramiento destaca los riesgos para los niños pequeños, en particular, que “todavía están desarrollando el pensamiento crítico y las habilidades para la vida necesarias para comprender cómo pueden ser equivocados o manipulados por programas informáticos y qué hacer al respecto”.

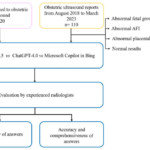

Mi equipo de investigación ha examinado recientemente una variedad de chatbots de IA, como ChatGPT, Replika y Tessa. Encontramos que estos sistemas reflejan las interacciones de las personas en función de las muchas reglas no escritas que rigen el comportamiento social, o lo que se conoce como “reglas de sentimiento”. Estas reglas son las que nos llevan a decir “gracias” cuando alguien nos abre la puerta, o “¡Lo siento!” Cuando te topas con alguien en la calle.

Al imitar estas y otras sutilezas sociales, estos sistemas están diseñados para ganar nuestra confianza.

Estas interacciones humanas serán confusas y potencialmente riesgosas para los niños pequeños. Pueden creer que se puede confiar en el contenido, incluso cuando el chatbot responde con información falsa. Y pueden creer que se están involucrando con una persona real, en lugar de una máquina.

Imagen de tierra

¿Cómo podemos proteger a los niños del daño al usar chatbots de IA?

Este despliegue está ocurriendo en un momento crucial en Australia, ya que los niños menores de 16 años tendrán que tener cuentas de redes sociales en diciembre de este año.

Si bien algunos padres pueden creer que esto mantendrá a sus hijos a salvo de daños, los chatbots generativos de IA muestran los riesgos de la participación en línea se extienden mucho más allá de las redes sociales. Los niños, y los padres, deben ser educados en cómo todos los tipos de herramientas digitales se pueden usar de manera adecuada y segura.

Como el chatbot de IA de Gemini no es una herramienta de redes sociales, se quedará fuera de la prohibición de Australia.

Esto deja a los padres australianos jugando un juego de Whack-a-Mole con nuevas tecnologías mientras intentan mantener a sus hijos seguros. Los padres deben mantenerse al día con los nuevos desarrollos de herramientas y comprender los riesgos potenciales que enfrentan sus hijos. También deben comprender las limitaciones de la prohibición de las redes sociales para proteger a los niños de daños.

Esto resalta la urgente necesidad de revisar la legislación propuesta por el deber de cuidado de Australia. Mientras que la Unión Europea y el Reino Unido lanzaron la legislación de Derechos de Cuidado de Digital de Cuidado en 2023, Australia ha estado en espera desde noviembre de 2024. Esta legislación haría que las empresas tecnológicas tengan en cuenta legislando que se ocupan de contenido nocivo, en la fuente, para proteger a todos.