Noticias

Meet the Power Players at OpenAI

Published

11 meses agoon

- OpenAI has been elevating research and technical talent to leadership roles after recent departures.

- The company has also brought on some new faces to fill the vacancies in its executive suite.

- Here are some of the key people to watch going forward.

Last year, OpenAI found itself navigating a storm of departures. Recently, the company has been busy elevating its research and technical talent to leadership positions while strategically bringing in new hires to patch up the holes in its executive suite.

This shuffle in leadership couldn’t come at a more critical time, as the company faces intensified competition from heavyweights like Microsoft, Google, Anthropic, and Elon Musk’s xAI. Staying ahead means securing top-flight talent is essential. After all, “OpenAI is nothing without its people,” or so employees declared on social media after the failed Sam Altman ouster.

Meanwhile, the company is juggling a cascade of legal challenges, from copyright lawsuits to antitrust scrutiny, all while navigating the shifting sands of regulatory guidance under President Donald Trump. On top of that, OpenAI is trying to restructure as a for-profit business, raise tens of billions of dollars, and build new computer data centers in the US to develop its tech.

It’s a high-wire act that hinges on the expertise and execution of its new and newly promoted leaders. Below are some of the key power players who are helping to shape OpenAI’s future.

Leadership

Photo By Stephen McCarthy/Sportsfile via Getty Images

Sarah Friar, chief financial officer

Friar joined last year as the company’s first financial chief and a seasoned addition to the new guard. Formerly Square’s CFO, Friar knows how to turn a founder’s vision into a story that investors want to be a part of. She took two companies public: Square and Nextdoor, the hyperlocal social network she led through explosive growth during pandemic lockdowns.

At OpenAI, Friar leads a finance team responsible for securing the funds required to build better models and the data centers to power them. In her first few months on the job, she helped the company get $6.5 billion in one of the biggest private pools of capital in startup history.

She inherited a business with a colossal consumer-facing business and high-profile partnerships with Microsoft and Apple. At the same time, OpenAI is burning through billions of dollars as it seeks to outpace increasingly stiff competition from Google, Meta, and others. Friar is expected to bring much-needed financial acumen to OpenAI as the company moves to turn its research into mass-market products and a profitable business.

Jason Kwon, chief strategy officer

In his role as chief strategy officer, Kwon helps set the agenda for a slew of non-research initiatives, including the company’s increasingly active outreach to policymakers and the various legal challenges swirling around it. His background as the company’s former general counsel gives him a strong foundation in navigating complex legal and regulatory landscapes.

Kwon works closely with Anna Makanju, the VP of global impact, and Chris Lehane, the VP of global affairs, as they seek to build and strengthen OpenAI’s relationships in the public sector.

Kwon was previously general counsel at the famed startup accelerator Y Combinator and assistant general counsel at Khosla Ventures, an early investor in OpenAI.

Che Chang, general counsel

Being at the forefront of artificial intelligence development puts OpenAI in a position to navigate and shape a largely uncharted legal territory. In his role as general counsel, Chang leads a team of attorneys who address the legal challenges associated with the creation and deployment of large language models. The company faces dozens of lawsuits concerning the datasets used to train its models and other privacy complaints, as well as multiple government investigations.

OpenAI’s top lawyer joined the company after serving as senior corporate counsel at Amazon, where he advised executives on developing and selling machine learning products and established Amazon’s positions on artificial intelligence policy and legislation. In 2021, Chang took over for his former boss, Jason Kwon, who has since become chief strategy officer.

Kevin Weil, chief product officer

Photo by Horacio Villalobos/Corbis via Getty Images

If Sam Altman is OpenAI’s starry-eyed visionary, Weil is its executor. He leads a product team that turns blue-sky research into products and services the company can sell.

Weil joined last year as a steady-handed product guru known for playing key roles at large social networks. He was a longtime Twitter insider who created products that made the social media company money during a revolving door of chief executives. At Instagram, he helped kneecap Snapchat’s growth with competitive product releases such as Stories and live video.

Weil is expected to bring much-needed systems thinking to OpenAI as the company moves to turn its research into polished products for both consumer and enterprise use cases.

Nick Turley, ChatGPT’s head of product

In the three years since ChatGPT burst onto the scene, it has reached hundreds of millions of active users and generated billions in revenue for its maker. Turley, a product savant who leads the teams driving the chatbot’s development, is behind much of ChatGPT’s success.

Turley joined in 2022 after his tenure at Instacart, where he guided a team of product managers through the pandemic-driven surge in demand for grocery delivery services.

OpenAI’s chatbot czar is likely to play a crucial role as the company expands into the enterprise market and adds more powerful, compute-intensive features to its famed chatbot.

Srinivas Narayanan, vice president of engineering

Narayanan was a longtime Facebook insider who worked on important product releases such as Facebook Photos and tools to help developers build for its virtual reality headset, Oculus. Now, he leads the OpenAI teams responsible for building new products and scaling its systems. This includes ChatGPT, which is used by over 400 million people weekly; the developer platform, which has doubled usage over the past six months; and the infrastructure needed to support both.

Research

Jakub Pachocki, chief scientist

Ilya Sutkever’s departure as chief scientist last year prompted questions about the company’s ability to stay on top of the artificial intelligence arms race. That has thrust Pachocki into the spotlight. He took on the mantle of chief scientist after seven years as an OpenAI researcher.

Pachocki had already been working closely with Sutskever on some of OpenAI’s most ambitious projects, including an advanced reasoning model now known as o1. In a post announcing his promotion, Sam Altman called Pachocki “easily one of the greatest minds of our generation.”

Mark Chen, senior vice president of research

A flurry of executive departures also cast Chen into the highest levels of leadership. He was promoted last September following the exit of Bob McGrew, the company’s chief research officer. In a post announcing the change, Altman called out Chen’s “deep technical expertise” and commended the longtime employee as having developed as a manager in recent years.

Chen’s path to OpenAI is a bit atypical compared to some of his colleagues. After studying computer science and mathematics at MIT, he began his career as a quantitative trader on Wall Street before joining OpenAI in 2018. Chen previously led the company’s frontier research.

He has been integral to OpenAI’s efforts to expand into multimodal models, heading up the team that developed DALL-E and the team that incorporated visual perception into GPT-4. Chen was also an important liaison between employees and management during Sam 0Altman’s short-lived ouster, further cementing his importance within the company.

Liam Fedus, vice president of research, post-training

Fedus helps the company get new products out the door. He leads a post-training team responsible for taking the company’s state-of-the-art models and improving their performance and efficiency before it releases them to the masses. Fedus was the third person to lead the team in a six-month period following the departures of Barret Zoph and Bob McGrew last year.

Fedus was also one of seven OpenAI researchers who developed a group of advanced reasoning models known as Strawberry. These models, which can think through problems and complete tasks they haven’t encountered before, represented a significant leap at launch.

Josh Tobin, member of technical staff

Tobin, an early research scientist at OpenAI, left to found Gantry, a company that assists teams in determining when and how to retrain their artificial intelligence systems. He returned to OpenAI last September and now leads a team of researchers focused on developing agentic products. Its flashy new agent, Deep Research, creates in-depth reports on nearly any topic.

Tobin brings invaluable experience in building agents as the company aims to scale them across a wide range of use cases. In a February interview with Sequoia, Tobin explained that when the company takes a reasoning model, gives it access to the same tools humans use to do their jobs, and optimizes for the kinds of outcomes it wants the agent to be able to do, “there’s really nothing stopping that recipe from scaling to more and more complex tasks.”

Related stories

Legal

Andrea Appella, associate general counsel for Europe, Middle East, Asia

Appella joined last year, bolstering the company’s legal firepower as it navigated a thicket of open investigations into data privacy concerns, including from watchdogs in Italy and Poland. Appella is a leading expert on competition and regulatory law, having previously served as head of global competition at Netflix and deputy general counsel at 21st Century Fox.

Regulatory scrutiny could still prove to be an existential threat to OpenAI as policymakers worldwide put guardrails on the nascent artificial intelligence industry. Nowhere have lawmakers been more aggressive than in Europe, which makes Appella’s role as the company’s top legal representative in Europe one of the more crucial positions in determining the company’s future.

Haidee Schwartz, associate general counsel for competition

OpenAI has spent the last year beefing up its legal team as it faces multiple antitrust probes. Schwartz, who joined in 2023, knows more about antitrust enforcement than almost anyone in Silicon Valley, having seen both sides of the issue during her storied legal career.

Between 2017 and 2019, she served as the acting deputy director of the Bureau of Competition at the Federal Trade Commission, one of the agencies currently investigating Microsoft’s agreements with OpenAI. Schwartz also advised clients on merger review and antitrust enforcement as a partner at law firm Akin Gump. She’ll likely play an important role in helping OpenAI navigate the shifting antitrust landscape in President Donald Trump’s second term.

Heather Whitney, copyright counsel

Whitney serves as lead data counsel at OpenAI, placing her at the forefront of various legal battles with publishers that have emerged in recent years. She joined the company last January, shortly after The New York Times filed a copyright lawsuit against OpenAI and its corporate backer, Microsoft. OpenAI motioned to dismiss the high-profile case last month.

Whitney’s handling of these legal cases, which raise new questions about intellectual property in relation to machine learning, will be crucial in deciding OpenAI’s future.

Previously, Whitney worked at the law firm Morrison Foerster, where she specialized in novel copyright issues related to artificial intelligence and was a member of the firm’s AI Steering Committee. Prior to her official hiring, she had already been collaborating with OpenAI as part of Morrison Foerster, which is among several law firms offering external counsel to the company.

Policy

Chan Park, head of US and Canada policy and partnerships

Related stories

Before OpenAI had a stable of federal lobbyists, it had Park. In 2023, the company registered the former Microsoft lobbyist as its first in-house lobbyist, marking a strategic move to engage more actively with lawmakers wrestling with artificial intelligence regulation.

Since then, OpenAI has beefed up its lobbying efforts as it seeks to build relationships in government and influence the development of artificial intelligence policy. It’s enlisted white-shoe law firms and at least one former US senator to plead OpenAI’s case in Washington. The company also spent $1.76 million on government lobbying in 2024, a sevenfold increase from the year before, according to a recent disclosure reviewed by the MIT Technology Review.

Park has been helping to guide those efforts from within OpenAI as the company continues to sharpen its message around responsible development of artificial intelligence.

Anna Makanju, vice president of global impact

Referred to as OpenAI’s de facto foreign minister, Makanju is the mastermind behind Sam Altman’s global charm offensive. On multiple trips, he met with world leaders, including the Indian prime minister and South Korean president, to discuss the future of artificial intelligence.

The tour was part of a broader effort to make Altman the friendly face of a nascent industry and ensure that OpenAI will have a seat at the table when designing artificial intelligence regulations and policies. Makanju, a veteran of Starlink and Facebook who also served as a special policy advisor to former President Joe Biden, has been integral in that effort.

In addition to helping Altman introduce himself on the world stage, she has played an important role in expanding OpenAI’s commercial partnerships in the public sector.

Chris Lehane, vice president of global affairs

Thomson Reuters

Lehane joined OpenAI last year to help the company liaise with policymakers and navigate an uncharted political landscape around artificial intelligence. The veteran political operative and “spin master” played a similar role at Airbnb, where he served as head of global policy and public affairs from 2015 to 2022 and helped it address growing opposition from local authorities.

He previously served in the Clinton White House, where Newsweek referred to him as a “master of disaster” for his handling of the scandals and political crises that plagued the administration.

Lehane is poised to play a crucial role in ensuring that the United States stays at the forefront of the global race in artificial intelligence. When President Trump introduced Stargate, a joint venture between OpenAI, Oracle, and SoftBank aimed at building large domestic data centers, Lehane was on the scene. From Washington, he traveled to Texas to meet with local officials, engaging in discussions about how the state could meet the rapidly growing demand for energy.

Lane Dilg, head of infrastructure policy and partnerships

In her newly appointed role, Dilg works to grease the wheels for the construction of giant data centers needed to build artificial intelligence. She took on the position in January after two years as head of strategic initiatives for global affairs, working with government agencies, private industry, and nonprofit organizations to ensure that artificial intelligence benefits all of humanity.

In hiring Dilg, OpenAI gained an inside player in the public sector. Dilg is a former senior advisor to the undersecretary of infrastructure at the US Department of Energy and was interim city manager for Santa Monica, California, managing the city through the COVID-19 pandemic.

Dilg will undoubtedly play an important role in expanding and nurturing OpenAI’s relationships in Washington as it seeks to secure President Trump’s support for building its own data centers.

Have a tip? Contact this reporter via email at [email protected] or Signal at meliarussell.01. Use a personal email address and a nonwork device; here’s our guide to sharing information securely.

Darius Rafieyan contributed to an earlier version of this story.

Noticias

5 indicaciones de chatgpt que pueden ayudar a los adolescentes a lanzar una startup

Published

8 meses agoon

5 junio, 2025

Teen emprendedor que usa chatgpt para ayudarlo con su negocio

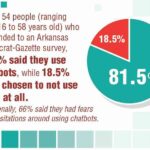

El emprendimiento adolescente sigue en aumento. Según Junior Achievement Research, el 66% de los adolescentes estadounidenses de entre 13 y 17 años dicen que es probable que considere comenzar un negocio como adultos, con el monitor de emprendimiento global 2023-2024 que encuentra que el 24% de los jóvenes de 18 a 24 años son actualmente empresarios. Estos jóvenes fundadores no son solo soñando, están construyendo empresas reales que generan ingresos y crean un impacto social, y están utilizando las indicaciones de ChatGPT para ayudarlos.

En Wit (lo que sea necesario), la organización que fundó en 2009, hemos trabajado con más de 10,000 jóvenes empresarios. Durante el año pasado, he observado un cambio en cómo los adolescentes abordan la planificación comercial. Con nuestra orientación, están utilizando herramientas de IA como ChatGPT, no como atajos, sino como socios de pensamiento estratégico para aclarar ideas, probar conceptos y acelerar la ejecución.

Los emprendedores adolescentes más exitosos han descubierto indicaciones específicas que los ayudan a pasar de una idea a otra. Estas no son sesiones genéricas de lluvia de ideas: están utilizando preguntas específicas que abordan los desafíos únicos que enfrentan los jóvenes fundadores: recursos limitados, compromisos escolares y la necesidad de demostrar sus conceptos rápidamente.

Aquí hay cinco indicaciones de ChatGPT que ayudan constantemente a los emprendedores adolescentes a construir negocios que importan.

1. El problema del primer descubrimiento chatgpt aviso

“Me doy cuenta de que [specific group of people]

luchar contra [specific problem I’ve observed]. Ayúdame a entender mejor este problema explicando: 1) por qué existe este problema, 2) qué soluciones existen actualmente y por qué son insuficientes, 3) cuánto las personas podrían pagar para resolver esto, y 4) tres formas específicas en que podría probar si este es un problema real que vale la pena resolver “.

Un adolescente podría usar este aviso después de notar que los estudiantes en la escuela luchan por pagar el almuerzo. En lugar de asumir que entienden el alcance completo, podrían pedirle a ChatGPT que investigue la deuda del almuerzo escolar como un problema sistémico. Esta investigación puede llevarlos a crear un negocio basado en productos donde los ingresos ayuden a pagar la deuda del almuerzo, lo que combina ganancias con el propósito.

Los adolescentes notan problemas de manera diferente a los adultos porque experimentan frustraciones únicas, desde los desafíos de las organizaciones escolares hasta las redes sociales hasta las preocupaciones ambientales. Según la investigación de Square sobre empresarios de la Generación de la Generación Z, el 84% planea ser dueños de negocios dentro de cinco años, lo que los convierte en candidatos ideales para las empresas de resolución de problemas.

2. El aviso de chatgpt de chatgpt de chatgpt de realidad de la realidad del recurso

“Soy [age] años con aproximadamente [dollar amount] invertir y [number] Horas por semana disponibles entre la escuela y otros compromisos. Según estas limitaciones, ¿cuáles son tres modelos de negocio que podría lanzar de manera realista este verano? Para cada opción, incluya costos de inicio, requisitos de tiempo y los primeros tres pasos para comenzar “.

Este aviso se dirige al elefante en la sala: la mayoría de los empresarios adolescentes tienen dinero y tiempo limitados. Cuando un empresario de 16 años emplea este enfoque para evaluar un concepto de negocio de tarjetas de felicitación, puede descubrir que pueden comenzar con $ 200 y escalar gradualmente. Al ser realistas sobre las limitaciones por adelantado, evitan el exceso de compromiso y pueden construir hacia objetivos de ingresos sostenibles.

Según el informe de Gen Z de Square, el 45% de los jóvenes empresarios usan sus ahorros para iniciar negocios, con el 80% de lanzamiento en línea o con un componente móvil. Estos datos respaldan la efectividad de la planificación basada en restricciones: cuando funcionan los adolescentes dentro de las limitaciones realistas, crean modelos comerciales más sostenibles.

3. El aviso de chatgpt del simulador de voz del cliente

“Actúa como un [specific demographic] Y dame comentarios honestos sobre esta idea de negocio: [describe your concept]. ¿Qué te excitaría de esto? ¿Qué preocupaciones tendrías? ¿Cuánto pagarías de manera realista? ¿Qué necesitaría cambiar para que se convierta en un cliente? “

Los empresarios adolescentes a menudo luchan con la investigación de los clientes porque no pueden encuestar fácilmente a grandes grupos o contratar firmas de investigación de mercado. Este aviso ayuda a simular los comentarios de los clientes haciendo que ChatGPT adopte personas específicas.

Un adolescente que desarrolla un podcast para atletas adolescentes podría usar este enfoque pidiéndole a ChatGPT que responda a diferentes tipos de atletas adolescentes. Esto ayuda a identificar temas de contenido que resuenan y mensajes que se sienten auténticos para el público objetivo.

El aviso funciona mejor cuando se vuelve específico sobre la demografía, los puntos débiles y los contextos. “Actúa como un estudiante de último año de secundaria que solicita a la universidad” produce mejores ideas que “actuar como un adolescente”.

4. El mensaje mínimo de diseñador de prueba viable chatgpt

“Quiero probar esta idea de negocio: [describe concept] sin gastar más de [budget amount] o más de [time commitment]. Diseñe tres experimentos simples que podría ejecutar esta semana para validar la demanda de los clientes. Para cada prueba, explique lo que aprendería, cómo medir el éxito y qué resultados indicarían que debería avanzar “.

Este aviso ayuda a los adolescentes a adoptar la metodología Lean Startup sin perderse en la jerga comercial. El enfoque en “This Week” crea urgencia y evita la planificación interminable sin acción.

Un adolescente que desea probar un concepto de línea de ropa podría usar este indicador para diseñar experimentos de validación simples, como publicar maquetas de diseño en las redes sociales para evaluar el interés, crear un formulario de Google para recolectar pedidos anticipados y pedirles a los amigos que compartan el concepto con sus redes. Estas pruebas no cuestan nada más que proporcionar datos cruciales sobre la demanda y los precios.

5. El aviso de chatgpt del generador de claridad de tono

“Convierta esta idea de negocio en una clara explicación de 60 segundos: [describe your business]. La explicación debe incluir: el problema que resuelve, su solución, a quién ayuda, por qué lo elegirían sobre las alternativas y cómo se ve el éxito. Escríbelo en lenguaje de conversación que un adolescente realmente usaría “.

La comunicación clara separa a los empresarios exitosos de aquellos con buenas ideas pero una ejecución deficiente. Este aviso ayuda a los adolescentes a destilar conceptos complejos a explicaciones convincentes que pueden usar en todas partes, desde las publicaciones en las redes sociales hasta las conversaciones con posibles mentores.

El énfasis en el “lenguaje de conversación que un adolescente realmente usaría” es importante. Muchas plantillas de lanzamiento comercial suenan artificiales cuando se entregan jóvenes fundadores. La autenticidad es más importante que la jerga corporativa.

Más allá de las indicaciones de chatgpt: estrategia de implementación

La diferencia entre los adolescentes que usan estas indicaciones de manera efectiva y aquellos que no se reducen a seguir. ChatGPT proporciona dirección, pero la acción crea resultados.

Los jóvenes empresarios más exitosos con los que trabajo usan estas indicaciones como puntos de partida, no de punto final. Toman las sugerencias generadas por IA e inmediatamente las prueban en el mundo real. Llaman a clientes potenciales, crean prototipos simples e iteran en función de los comentarios reales.

Investigaciones recientes de Junior Achievement muestran que el 69% de los adolescentes tienen ideas de negocios, pero se sienten inciertos sobre el proceso de partida, con el miedo a que el fracaso sea la principal preocupación para el 67% de los posibles empresarios adolescentes. Estas indicaciones abordan esa incertidumbre al desactivar los conceptos abstractos en los próximos pasos concretos.

La imagen más grande

Los emprendedores adolescentes que utilizan herramientas de IA como ChatGPT representan un cambio en cómo está ocurriendo la educación empresarial. Según la investigación mundial de monitores empresariales, los jóvenes empresarios tienen 1,6 veces más probabilidades que los adultos de querer comenzar un negocio, y son particularmente activos en la tecnología, la alimentación y las bebidas, la moda y los sectores de entretenimiento. En lugar de esperar clases de emprendimiento formales o programas de MBA, estos jóvenes fundadores están accediendo a herramientas de pensamiento estratégico de inmediato.

Esta tendencia se alinea con cambios más amplios en la educación y la fuerza laboral. El Foro Económico Mundial identifica la creatividad, el pensamiento crítico y la resiliencia como las principales habilidades para 2025, la capacidad de las capacidades que el espíritu empresarial desarrolla naturalmente.

Programas como WIT brindan soporte estructurado para este viaje, pero las herramientas en sí mismas se están volviendo cada vez más accesibles. Un adolescente con acceso a Internet ahora puede acceder a recursos de planificación empresarial que anteriormente estaban disponibles solo para empresarios establecidos con presupuestos significativos.

La clave es usar estas herramientas cuidadosamente. ChatGPT puede acelerar el pensamiento y proporcionar marcos, pero no puede reemplazar el arduo trabajo de construir relaciones, crear productos y servir a los clientes. La mejor idea de negocio no es la más original, es la que resuelve un problema real para personas reales. Las herramientas de IA pueden ayudar a identificar esas oportunidades, pero solo la acción puede convertirlos en empresas que importan.

Noticias

Chatgpt vs. gemini: he probado ambos, y uno definitivamente es mejor

Published

8 meses agoon

5 junio, 2025

Precio

ChatGPT y Gemini tienen versiones gratuitas que limitan su acceso a características y modelos. Los planes premium para ambos también comienzan en alrededor de $ 20 por mes. Las características de chatbot, como investigaciones profundas, generación de imágenes y videos, búsqueda web y más, son similares en ChatGPT y Gemini. Sin embargo, los planes de Gemini pagados también incluyen el almacenamiento en la nube de Google Drive (a partir de 2TB) y un conjunto robusto de integraciones en las aplicaciones de Google Workspace.

Los niveles de más alta gama de ChatGPT y Gemini desbloquean el aumento de los límites de uso y algunas características únicas, pero el costo mensual prohibitivo de estos planes (como $ 200 para Chatgpt Pro o $ 250 para Gemini Ai Ultra) los pone fuera del alcance de la mayoría de las personas. Las características específicas del plan Pro de ChatGPT, como el modo O1 Pro que aprovecha el poder de cálculo adicional para preguntas particularmente complicadas, no son especialmente relevantes para el consumidor promedio, por lo que no sentirá que se está perdiendo. Sin embargo, es probable que desee las características que son exclusivas del plan Ai Ultra de Gemini, como la generación de videos VEO 3.

Ganador: Géminis

Plataformas

Puede acceder a ChatGPT y Gemini en la web o a través de aplicaciones móviles (Android e iOS). ChatGPT también tiene aplicaciones de escritorio (macOS y Windows) y una extensión oficial para Google Chrome. Gemini no tiene aplicaciones de escritorio dedicadas o una extensión de Chrome, aunque se integra directamente con el navegador.

(Crédito: OpenAI/PCMAG)

Chatgpt está disponible en otros lugares, Como a través de Siri. Como se mencionó, puede acceder a Gemini en las aplicaciones de Google, como el calendario, Documento, ConducirGmail, Mapas, Mantener, FotosSábanas, y Música de YouTube. Tanto los modelos de Chatgpt como Gemini también aparecen en sitios como la perplejidad. Sin embargo, obtiene la mayor cantidad de funciones de estos chatbots en sus aplicaciones y portales web dedicados.

Las interfaces de ambos chatbots son en gran medida consistentes en todas las plataformas. Son fáciles de usar y no lo abruman con opciones y alternar. ChatGPT tiene algunas configuraciones más para jugar, como la capacidad de ajustar su personalidad, mientras que la profunda interfaz de investigación de Gemini hace un mejor uso de los bienes inmuebles de pantalla.

Ganador: empate

Modelos de IA

ChatGPT tiene dos series primarias de modelos, la serie 4 (su línea de conversación, insignia) y la Serie O (su compleja línea de razonamiento). Gemini ofrece de manera similar una serie Flash de uso general y una serie Pro para tareas más complicadas.

Los últimos modelos de Chatgpt son O3 y O4-Mini, y los últimos de Gemini son 2.5 Flash y 2.5 Pro. Fuera de la codificación o la resolución de una ecuación, pasará la mayor parte de su tiempo usando los modelos de la serie 4-Series y Flash. A continuación, puede ver cómo funcionan estos modelos en una variedad de tareas. Qué modelo es mejor depende realmente de lo que quieras hacer.

Ganador: empate

Búsqueda web

ChatGPT y Gemini pueden buscar información actualizada en la web con facilidad. Sin embargo, ChatGPT presenta mosaicos de artículos en la parte inferior de sus respuestas para una lectura adicional, tiene un excelente abastecimiento que facilita la vinculación de reclamos con evidencia, incluye imágenes en las respuestas cuando es relevante y, a menudo, proporciona más detalles en respuesta. Gemini no muestra nombres de fuente y títulos de artículos completos, e incluye mosaicos e imágenes de artículos solo cuando usa el modo AI de Google. El abastecimiento en este modo es aún menos robusto; Google relega las fuentes a los caretes que se pueden hacer clic que no resaltan las partes relevantes de su respuesta.

Como parte de sus experiencias de búsqueda en la web, ChatGPT y Gemini pueden ayudarlo a comprar. Si solicita consejos de compra, ambos presentan mosaicos haciendo clic en enlaces a los minoristas. Sin embargo, Gemini generalmente sugiere mejores productos y tiene una característica única en la que puede cargar una imagen tuya para probar digitalmente la ropa antes de comprar.

Ganador: chatgpt

Investigación profunda

ChatGPT y Gemini pueden generar informes que tienen docenas de páginas e incluyen más de 50 fuentes sobre cualquier tema. La mayor diferencia entre los dos se reduce al abastecimiento. Gemini a menudo cita más fuentes que CHATGPT, pero maneja el abastecimiento en informes de investigación profunda de la misma manera que lo hace en la búsqueda en modo AI, lo que significa caretas que se puede hacer clic sin destacados en el texto. Debido a que es más difícil conectar las afirmaciones en los informes de Géminis a fuentes reales, es más difícil creerles. El abastecimiento claro de ChatGPT con destacados en el texto es más fácil de confiar. Sin embargo, Gemini tiene algunas características de calidad de vida en ChatGPT, como la capacidad de exportar informes formateados correctamente a Google Docs con un solo clic. Su tono también es diferente. Los informes de ChatGPT se leen como publicaciones de foro elaboradas, mientras que los informes de Gemini se leen como documentos académicos.

Ganador: chatgpt

Generación de imágenes

La generación de imágenes de ChatGPT impresiona independientemente de lo que solicite, incluso las indicaciones complejas para paneles o diagramas cómicos. No es perfecto, pero los errores y la distorsión son mínimos. Gemini genera imágenes visualmente atractivas más rápido que ChatGPT, pero rutinariamente incluyen errores y distorsión notables. Con indicaciones complicadas, especialmente diagramas, Gemini produjo resultados sin sentido en las pruebas.

Arriba, puede ver cómo ChatGPT (primera diapositiva) y Géminis (segunda diapositiva) les fue con el siguiente mensaje: “Genere una imagen de un estudio de moda con una decoración simple y rústica que contrasta con el espacio más agradable. Incluya un sofá marrón y paredes de ladrillo”. La imagen de ChatGPT limita los problemas al detalle fino en las hojas de sus plantas y texto en su libro, mientras que la imagen de Gemini muestra problemas más notables en su tubo de cordón y lámpara.

Ganador: chatgpt

¡Obtenga nuestras mejores historias!

Toda la última tecnología, probada por nuestros expertos

Regístrese en el boletín de informes de laboratorio para recibir las últimas revisiones de productos de PCMAG, comprar asesoramiento e ideas.

Al hacer clic en Registrarme, confirma que tiene más de 16 años y acepta nuestros Términos de uso y Política de privacidad.

¡Gracias por registrarse!

Su suscripción ha sido confirmada. ¡Esté atento a su bandeja de entrada!

Generación de videos

La generación de videos de Gemini es la mejor de su clase, especialmente porque ChatGPT no puede igualar su capacidad para producir audio acompañante. Actualmente, Google bloquea el último modelo de generación de videos de Gemini, VEO 3, detrás del costoso plan AI Ultra, pero obtienes más videos realistas que con ChatGPT. Gemini también tiene otras características que ChatGPT no, como la herramienta Flow Filmmaker, que le permite extender los clips generados y el animador AI Whisk, que le permite animar imágenes fijas. Sin embargo, tenga en cuenta que incluso con VEO 3, aún necesita generar videos varias veces para obtener un gran resultado.

En el ejemplo anterior, solicité a ChatGPT y Gemini a mostrarme un solucionador de cubos de Rubik Rubik que resuelva un cubo. La persona en el video de Géminis se ve muy bien, y el audio acompañante es competente. Al final, hay una buena atención al detalle con el marco que se desplaza, simulando la detención de una grabación de selfies. Mientras tanto, Chatgpt luchó con su cubo, distorsionándolo en gran medida.

Ganador: Géminis

Procesamiento de archivos

Comprender los archivos es una fortaleza de ChatGPT y Gemini. Ya sea que desee que respondan preguntas sobre un manual, editen un currículum o le informen algo sobre una imagen, ninguno decepciona. Sin embargo, ChatGPT tiene la ventaja sobre Gemini, ya que ofrece un reconocimiento de imagen ligeramente mejor y respuestas más detalladas cuando pregunta sobre los archivos cargados. Ambos chatbots todavía a veces inventan citas de documentos proporcionados o malinterpretan las imágenes, así que asegúrese de verificar sus resultados.

Ganador: chatgpt

Escritura creativa

Chatgpt y Gemini pueden generar poemas, obras, historias y más competentes. CHATGPT, sin embargo, se destaca entre los dos debido a cuán únicas son sus respuestas y qué tan bien responde a las indicaciones. Las respuestas de Gemini pueden sentirse repetitivas si no calibra cuidadosamente sus solicitudes, y no siempre sigue todas las instrucciones a la carta.

En el ejemplo anterior, solicité ChatGPT (primera diapositiva) y Gemini (segunda diapositiva) con lo siguiente: “Sin hacer referencia a nada en su memoria o respuestas anteriores, quiero que me escriba un poema de verso gratuito. Preste atención especial a la capitalización, enjambment, ruptura de línea y puntuación. Dado que es un verso libre, no quiero un medidor familiar o un esquema de retiro de la rima, pero quiero que tenga un estilo de coohes. ChatGPT logró entregar lo que pedí en el aviso, y eso era distinto de las generaciones anteriores. Gemini tuvo problemas para generar un poema que incorporó cualquier cosa más allá de las comas y los períodos, y su poema anterior se lee de manera muy similar a un poema que generó antes.

Recomendado por nuestros editores

Ganador: chatgpt

Razonamiento complejo

Los modelos de razonamiento complejos de Chatgpt y Gemini pueden manejar preguntas de informática, matemáticas y física con facilidad, así como mostrar de manera competente su trabajo. En las pruebas, ChatGPT dio respuestas correctas un poco más a menudo que Gemini, pero su rendimiento es bastante similar. Ambos chatbots pueden y le darán respuestas incorrectas, por lo que verificar su trabajo aún es vital si está haciendo algo importante o tratando de aprender un concepto.

Ganador: chatgpt

Integración

ChatGPT no tiene integraciones significativas, mientras que las integraciones de Gemini son una característica definitoria. Ya sea que desee obtener ayuda para editar un ensayo en Google Docs, comparta una pestaña Chrome para hacer una pregunta, pruebe una nueva lista de reproducción de música de YouTube personalizada para su gusto o desbloquee ideas personales en Gmail, Gemini puede hacer todo y mucho más. Es difícil subestimar cuán integrales y poderosas son realmente las integraciones de Géminis.

Ganador: Géminis

Asistentes de IA

ChatGPT tiene GPT personalizados, y Gemini tiene gemas. Ambos son asistentes de IA personalizables. Tampoco es una gran actualización sobre hablar directamente con los chatbots, pero los GPT personalizados de terceros agregan una nueva funcionalidad, como el fácil acceso a Canva para editar imágenes generadas. Mientras tanto, terceros no pueden crear gemas, y no puedes compartirlas. Puede permitir que los GPT personalizados accedan a la información externa o tomen acciones externas, pero las GEM no tienen una funcionalidad similar.

Ganador: chatgpt

Contexto Windows y límites de uso

La ventana de contexto de ChatGPT sube a 128,000 tokens en sus planes de nivel superior, y todos los planes tienen límites de uso dinámicos basados en la carga del servidor. Géminis, por otro lado, tiene una ventana de contexto de 1,000,000 token. Google no está demasiado claro en los límites de uso exactos para Gemini, pero también son dinámicos dependiendo de la carga del servidor. Anecdóticamente, no pude alcanzar los límites de uso usando los planes pagados de Chatgpt o Gemini, pero es mucho más fácil hacerlo con los planes gratuitos.

Ganador: Géminis

Privacidad

La privacidad en Chatgpt y Gemini es una bolsa mixta. Ambos recopilan cantidades significativas de datos, incluidos todos sus chats, y usan esos datos para capacitar a sus modelos de IA de forma predeterminada. Sin embargo, ambos le dan la opción de apagar el entrenamiento. Google al menos no recopila y usa datos de Gemini para fines de capacitación en aplicaciones de espacio de trabajo, como Gmail, de forma predeterminada. ChatGPT y Gemini también prometen no vender sus datos o usarlos para la orientación de anuncios, pero Google y OpenAI tienen historias sórdidas cuando se trata de hacks, filtraciones y diversos fechorías digitales, por lo que recomiendo no compartir nada demasiado sensible.

Ganador: empate

Related posts

Trending

-

Startups2 años ago

Startups2 años agoRemove.bg: La Revolución en la Edición de Imágenes que Debes Conocer

-

Tutoriales2 años ago

Tutoriales2 años agoCómo Comenzar a Utilizar ChatGPT: Una Guía Completa para Principiantes

-

Startups2 años ago

Startups2 años agoStartups de IA en EE.UU. que han recaudado más de $100M en 2024

-

Startups2 años ago

Startups2 años agoDeepgram: Revolucionando el Reconocimiento de Voz con IA

-

Recursos2 años ago

Recursos2 años agoCómo Empezar con Popai.pro: Tu Espacio Personal de IA – Guía Completa, Instalación, Versiones y Precios

-

Recursos2 años ago

Recursos2 años agoPerplexity aplicado al Marketing Digital y Estrategias SEO

-

Estudiar IA2 años ago

Estudiar IA2 años agoCurso de Inteligencia Artificial Aplicada de 4Geeks Academy 2024

-

Estudiar IA2 años ago

Estudiar IA2 años agoCurso de Inteligencia Artificial de UC Berkeley estratégico para negocios