Microsoft Copilot vs ChatGPT: Which is the better generative AI tool for your team? Since the incredibly successful launch of ChatGPT back in 2022, plenty of new competitors have entered the space. It seems like every major tech vendor is introducing its own generative bot.

From direct ChatGPT competitors like Google’s Gemini, to more specific solutions like Zoom’s AI Companion, there’s something out there for virtually every team. However, ChatGPT, by OpenAI, and Copilot, by Microsoft are still leading the pack for most organizations.

The question is: how are they different? Since Microsoft partnered with OpenAI to develop its Copilot suite, you might think Copilot and ChatGPT are very similar.

However, there are some big differences between them that are well worth considering if you’re looking for the best tool for your team. Here’s everything you need to know.

Microsoft Copilot vs ChatGPT: An Overview

Let’s start with the basics, Microsoft Copilot and ChatGPT are both generative AI tools that use large language models to enhance productivity, efficiency and creativity in various ways. Both are connected to world-leading AI company, OpenAI.

ChatGPT is OpenAI’s proprietary web-based chatbot, which leverages the ever-evolving GPTs (Generative Pre-Trained Transformers) created by the OpenAI team. Microsoft Copilot, on the other hand, is Microsoft’s AI chatbot, designed by Microsoft with support from OpenAI’s technology.

The underlying technology of both solutions is very similar. Both are powered by LLMs and feature natural language processing capabilities. Both applications also rely on prompting, which basically means you need to enter a question into a chat system to “prompt” a response from the bot.

However, Copilot isn’t just ChatGPT with Microsoft’s branding. There are some key differences between the solutions connected to how they work, their use cases, the data they use, and even their security and privacy settings.

Microsoft Copilot vs ChatGPT: What is ChatGPT?

ChatGPT is a web-based generative AI chatbot that leverages large language model technology, machine learning, and natural language processing to generate “natural” or human-like responses to prompts. It was originally launched in November 2022, by OpenAI.

ChatGPT is powered by deep learning techniques (such as transformer neural networks), allowing it to process text and generate responses that seem almost human. The technology is trained on large volumes of text, including books, articles, and web pages.

Over the years, ChatGPT has evolved significantly. The GPT models used within the system have evolved thanks to ongoing research from OpenAI. For instance, recently the company introduced GPT-4o, which introduces multi-modal capabilities and new functionality to tools like ChatGPT.

ChatGPT is also available in various forms, such as:

- ChatGPT Free: The free version of ChatGPT, primarily intended to support OpenAI’s testing and research processes. This version of ChatGPT has limited access to OpenAI’s latest GPT models and fewer features than the premium alternatives.

- ChatGPT Plus: The first premium subscription plan introduced by OpenAI. This provides access to more advanced GPT models, like GPT-4 and GPT-4o. It also allows users to access faster response times, and image generation capabilities with DALL-E.

- ChatGPT Team: Designed to support organizations using generative AI, ChatGPT Team comes with all the features of the Plus plan, as well as unlimited access to advanced GPT models and tools to create your own GPTs. There’s also additional admin console controls for teams, and your user data is excluded from GPT training initiatives by default.

- ChatGPT Enterprise: The most advanced plan offered by ChatGPT, the Enterprise subscription comes with all the features of the Team plan, plus additional admin controls, domain verification, analytics, and account management support.

ChatGPT vs Microsoft Copilot: What is Microsoft Copilot?

Microsoft Copilot is an AI-powered productivity tool that leverages LLMs and machine learning just like ChatGPT. Just like ChatGPT, Copilot can respond to natural input (prompts) from users with human-like responses.

However, unlike ChatGPT, Copilot is closely intertwined with Microsoft’s existing product suite. It’s baked into tools like Microsoft Edge and Microsoft 365, as well as Microsoft Dynamics, Teams, Purview, Power Platform and more.

Microsoft Copilot also takes advantage of data in the Microsoft Graph, and your existing Microsoft ecosystem, which means it’s more effective at contextualizing and personalizing responses than ChatGPT, in general. Similar to ChatGPT, Microsoft Copilot comes in various different forms, with specific pricing packages for different use cases, such as:

- Copilot (Free): The free version of Copilot provides access to generative AI capabilities for things like computer management (in Windows), online search (in Edge) and general chatbot conversations on the web.

- Copilot Pro: Similar to ChatGPT Plus, Copilot Pro is intended for individual users who want to get more out of the generative AI product. For $20 per month, per user, you get access to Copilot in various tools, like Outlook, Word, Excel, PowerPoint, and OneNote.

- Copilot for Microsoft 365: Like ChatGPT Team, Copilot for Microsoft 365 is intended for individuals and teams working with Microsoft apps. It provides access to Copilot Studio, enterprise-grade security, privacy, and compliance, and more advanced capabilities.

On top of that, there are various versions of Copilot designed for specific Microsoft tools. For instance, there are Copilot solutions for sales and customer service teams built into Microsoft Dynamics, and Copilot security solutions built into Microsoft Purview.

Microsoft Copilot vs ChatGPT: The Core Differences

Although Microsoft Copilot and ChatGPT have a lot of similarities, for instance, they both use prompting, rely on natural language processing, and leverage LLM architecture, there are some key differences between them.

Features and Use Cases

On a broad level, both Microsoft Copilot and ChatGPT have similar features. They can both be used for similar things, like composing emails, content, or code. Both tools are even becoming more multimodal, allowing users to create images with things like DALL-E 3 (which is also available in Microsoft Designer). However, the purpose of these tools is a little different.

ChatGPT Use Cases

The functionality of ChatGPT varies based on your plan. If you’re a free user, you can use the simplest version of the bot to create various kinds of content. Users can compose essays, emails, cover letters, lists, and code.

The multimodal abilities of ChatGPT also allow users to create content based on image inputs, and even design new visual assets. On more advanced versions of ChatGPT, you’ll also have access to extra tools, like the solution previously known as “Code Interpreter”, which supports data analysis.

ChatGPT excels at certain tasks; for instance, it’s great for:

- Creating conversational agents: With ChatGPT’s APIs, companies can create conversational bots for customer support and sales strategies.

- Content creation: ChatGPT is fantastic at generating creative content, such as articles, essays, and poetry. It can even translate languages and create content in different formats.

- Informational queries: ChatGPT (particularly the premium version) can answer a wide range of questions with exceptional accuracy and context.

- Education: Many educational groups use ChatGPT to convert complex topics into simple guides to help support students and facilitate learning.

- Writing basic code: ChatGPT is great at helping developers solve coding problems, although its output isn’t always 100% accurate.

Microsoft Copilot Use Cases

Perhaps the biggest benefit of Microsoft Copilot over ChatGPT is that it integrates seamlessly into the Microsoft ecosystem. It’s available in all the tools companies already use each day, such as Word, Outlook, Microsoft Teams, PowerPoint, and more.

Microsoft Copilot can essentially do everything ChatGPT can do, but it draws on data from your existing Microsoft ecosystem, and enhances the features of various Microsoft tools. For instance, Microsoft Copilot can:

- Draft content: In tools like Microsoft Word, Copilot can create content for you, surface information from the web and more. It can also produce emails in Outlook, design PowerPoint presentations, and create Excel spreadsheets.

- Enhance meetings: In Microsoft Teams, Copilot can summarize meetings and suggest action items, translate and transcribe conversations in real-time, and draw data from other Microsoft tools to support users during a meeting.

- Automate repetitive tasks: Microsoft Copilot can automate a range of tasks, from delivering personalized support to users through bots connected to Microsoft Dynamics to monitoring security risks in Purview.

- Improving productivity: Microsoft Copilot makes it easy to search for data across a broad ecosystem of files and documents. It can summarize email chains, and suggest ways for teams to boost performance. It can even provide advice to staff members on when they should attend an office, and which spaces to book in Microsoft Places.

Model Architecture, Data Training and Tuning

Both Microsoft Copilot and ChatGPT rely on similar technology at their core. Both use GPT (Generative Pre-trained Transformer) architecture, large language model technology, natural language processing, and machine learning capabilities.

However, unlike ChatGPT, Copilot is specifically fine-tuned to support users in different ways across various Microsoft applications and tools. Microsoft Copilot in Microsoft Teams, for instance, features specific capabilities intended to boost meeting performance and collaboration. The Microsoft Security Copilot, on the other hand, is fine-tuned to improve business security and compliance.

The data used by both solutions is a little different, too. Both are trained on a diverse dataset encompassing various content and data from the Internet and other resources. However, each version of Copilot has its own unique data set based on the specific application.

Copilot also relies on data from each user’s Microsoft ecosystem, and the Microsoft Graph. This means it can adapt to your specific enterprise data. Although ChatGPT can be integrated into various platforms, Copilot’s seamless integration into the Microsoft 365 suite means users generally get more context-aware and personalized responses to queries.

Microsoft Copilot vs ChatGPT: Customization

Again, both Microsoft Copilot and ChatGPT are highly versatile. However, ChatGPT’s customization options mostly rely on using APIs to connect ChatGPT to systems for individual use cases. Notably, there are tools companies can use to build and fine-tune unique versions of ChatGPT.

For instance, in 2023, OpenAI announced a no-code ChatGPT builder platform for businesses. Although, developing and using custom versions of ChatGPT generally requires a little more technical knowledge, even with a no-code builder.

Microsoft Copilot, on the other hand, makes it much easier to create customized generative AI tools. Copilot Studio, for instance, gives businesses access to a platform where they can design Copilot solutions connected to various other platforms and data sources.

As mentioned above, it’s also worth noting that Copilot offers a more personalized experience in general due to its ability to draw on the data inside a company’s existing Microsoft applications.

Security, Privacy, and Compliance

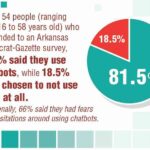

All generative AI tools, including ChatGPT and Microsoft Copilot, are vulnerable to data security, privacy issues, and various ethical concerns. Both of these tools can suffer from issues connected to AI bias and may occasionally surface incorrect responses to questions.

In both cases, the “free” versions of Copilot and ChatGPT potentially pose the biggest risks. However, OpenAI trains its LLMs on data from customer conversations with ChatGPT unless you directly opt out of this process or use the Team or Enterprise version of the tool.

Microsoft, on the other hand, says that it doesn’t use customer data to train Copilot tools at all. Prompts, responses, and data accessed through Microsoft Services aren’t used to build on the functionality of Copilot in any tool.

This could mean that, at least for business users, Copilot is a more secure tool, if you’re concerned about your data falling into the wrong hands. Notably, though, it’s worth remembering that both tools give you access to more features for controlling your data and access permissions if you upgrade to certain premium plans. For instance, the Team and Enterprise versions of ChatGPT offer a lot more control over data privacy and security.

Microsoft Copilot vs ChatGPT: The Pricing

Finally, it’s worth noting that the pricing structures for Microsoft Copilot and ChatGPT are different, too. Although both tools have free options, they’re somewhat limited. The premium plans for both solutions are similar in price. For instance, ChatGPT Plus and Copilot Pro cost $20 per month per user.

The Microsoft 365 Copilot subscription and ChatGPT also cost around $30 per user per month. However, Copilot can become more expensive overall because you’ll also need to pay for the Microsoft tools you will use. For instance, if you want to use Copilot for Teams, you’ll need a Microsoft 365 Copilot subscription and a Microsoft 365 plan.

Microsoft Copilot vs ChatGPT: Which is Best?

It’s easy to assume ChatGPT and Microsoft Copilot are two sides of the same coin. Both tools are generative AI applications built with large language models and OpenAI technology. They also offer users an intuitive chat-based interface for easy assistant interactions.

However, ChatGPT is a more generalized tool. It’s an app designed to inspire and support users when creating content, creating customer service apps, or conducting research. You can use ChatGPT to write essays and create compelling job descriptions.

Microsoft Copilot has a slightly narrower focus. It’s primarily intended to support users in the Microsoft ecosystem when they use solutions like Microsoft Teams and Copilot. Copilot focuses on improving productivity, efficiency, and overall workplace performance.

If you’re looking to upgrade your Microsoft ecosystem with AI, Copilot is the tool you need. If you just want to experiment with the latest innovations in generative AI, pick ChatGPT.