Hasta hace unas semanas, pocas personas en el mundo occidental habían oído hablar de una pequeña compañía de inteligencia artificial china (AI) conocida como Deepseek. Pero el 20 de enero, capturó la atención global cuando lanzó un nuevo modelo de IA llamado R1.

R1 es un modelo de “razonamiento”, lo que significa que funciona a través de las tareas paso a paso y detalla su proceso de trabajo a un usuario. Es una versión más avanzada del modelo V3 de Deepseek, que se lanzó en diciembre. La nueva oferta de Deepseek es casi tan poderosa como el modelo de IA más avanzado de AI de la compañía rival Openai, pero a una fracción del costo.

En cuestión de días, la aplicación de Deepseek superó a ChatGPT en nuevas descargas y estableció precios de acciones de las empresas tecnológicas en los Estados Unidos. También llevó a Openai a afirmar que su rival chino había robado efectivamente algunas de las joyas de la corona de los modelos de Openii para construir los suyos.

En una declaración al New York Times, la compañía dijo:

Somos conscientes y revisando las indicaciones de que Deepseek puede haber destilado inapropiadamente nuestros modelos, y compartirá información como sabemos más. Tomamos contramedidas agresivas y proactivas para proteger nuestra tecnología y continuaremos trabajando estrechamente con el gobierno de los Estados Unidos para proteger los modelos más capaces que se están construyendo aquí.

La conversación se acercó a Deepseek para hacer comentarios, pero no respondió.

Pero incluso si Deepseek copió, o, en el lenguaje científico, “destilado”, al menos parte de Chatgpt para construir R1, vale la pena recordar que OpenAi también está acusado de faltarle el respeto a la propiedad intelectual mientras desarrolla sus modelos.

¿Qué es la destilación?

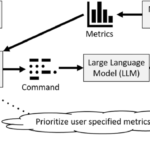

La destilación del modelo es una técnica de aprendizaje automático común en la que un “modelo de estudiante” más pequeño está capacitado en predicciones de un “modelo de maestro” más grande y complejo.

Cuando se complete, el estudiante puede ser casi tan bueno como el maestro, pero representará el conocimiento del maestro de manera más efectiva y compacta.

Para hacerlo, no es necesario acceder al funcionamiento interno del maestro. Todo lo que uno necesita lograr este truco es hacerle preguntas suficientes al modelo de maestro para entrenar al alumno.

Esto es lo que Openai afirma que Deepseek ha hecho: consultar O1 O1 a una escala masiva y usó los resultados observados para entrenar los modelos propios y más eficientes de Deepseek.

Salvatore di Nolfi/EPA

Una fracción de los recursos

Deepseek afirma que tanto la capacitación como el uso de R1 solo requirieron una fracción de los recursos necesarios para desarrollar los mejores modelos de sus competidores.

Hay razones para ser escépticos de algunos de los bombos de marketing de la compañía; por ejemplo, un nuevo informe independiente sugiere que el gasto de hardware en R1 fue tan alto como US $ 500 millones. Pero aun así, Deepseek todavía se construyó muy rápido y eficientemente en comparación con los modelos rivales.

Esto podría deberse a que Deepseek destiló la salida de Openai. Sin embargo, actualmente no hay ningún método para probar esto de manera concluyente. Un método que se encuentra en las primeras etapas del desarrollo es la marca de agua de las salidas de IA. Esto agrega patrones invisibles a las salidas, similares a las aplicadas a las imágenes con derechos de autor. Hay varias formas de hacer esto en teoría, pero ninguna es lo suficientemente efectiva o eficiente como para haberlo en práctica.

Hay otras razones que ayudan a explicar el éxito de Deepseek, como el trabajo técnico profundo y desafiante de la compañía.

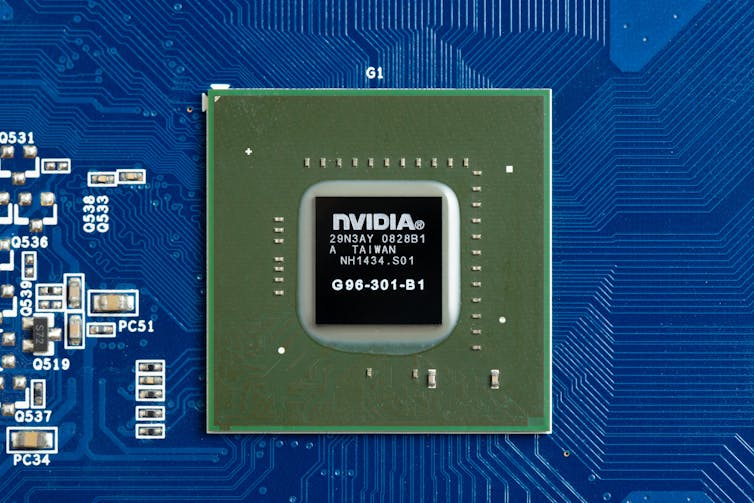

Los avances técnicos realizados por Deepseek incluyeron aprovechar las chips de IA menos potentes pero más baratas (también llamadas unidades de procesamiento gráfico o GPU).

Deepseek no tuvo más remedio que adaptarse después de que Estados Unidos haya prohibido a las empresas exportar los chips de IA más poderosos a China.

Si bien las compañías de IA occidentales pueden comprar estas poderosas unidades, la prohibición de exportación obligó a las empresas chinas a innovar para aprovechar al mejor uso de alternativas más baratas.

Ni gal/Shutterstock

Una serie de demandas

Los términos de uso de OpenAI indican explícitamente que nadie puede usar sus modelos AI para desarrollar productos competidores. Sin embargo, sus propios modelos están capacitados en conjuntos de datos masivos raspados de la web. Estos conjuntos de datos contenían una cantidad sustancial de material con derechos de autor, que OpenAI dice que tiene derecho a usar sobre la base del “uso justo”:

La capacitación de modelos AI que utilizan materiales de Internet disponibles públicamente es de uso justo, como lo respalda los precedentes de larga data y ampliamente aceptados. Vemos este principio como justo para los creadores, necesarios para los innovadores y la competitividad crítica para nosotros.

Este argumento será probado en la corte. Los periódicos, músicos, autores y otros creativos han presentado una serie de demandas contra OpenAI por infracción de derechos de autor.

Por supuesto, esto es bastante distinto a lo que Openai acusa a un gransejo de hacer. Sin embargo, Openai no está atrayendo mucha simpatía por su afirmación de que Deepseek cosechó ilegítimamente su producción modelo.

La guerra de palabras y demandas es un artefacto de cómo el rápido avance de la IA ha superado el desarrollo de reglas legales claras para la industria. Y aunque estos eventos recientes podrían reducir el poder de los titulares de IA, muchas dependen del resultado de las diversas disputas legales en curso.

Sacudiendo la conversación global

Deepseek ha demostrado que es posible desarrollar modelos de última generación de manera económica y eficiente. Queda por ver si pueden competir con OpenAi en un campo de juego nivelado.

Durante el fin de semana, Operai intentó demostrar su supremacía al liberar públicamente su modelo de consumo más avanzado, O3-Mini.

Operai afirma que este modelo supera sustancialmente su propia versión previa líder en el mercado, O1, y es el “modelo más rentable en nuestra serie de razonamiento”.

Estos desarrollos anuncian una era de mayor elección para los consumidores, con una diversidad de modelos de IA en el mercado. Esta es una buena noticia para los usuarios: las presiones competitivas harán que los modelos sean más baratos de usar.

Y los beneficios se extienden más.

El entrenamiento y el uso de estos modelos coloca una tensión masiva en el consumo de energía global. A medida que estos modelos se vuelven más ubicuos, todos nos beneficiamos de las mejoras en su eficiencia.

El ascenso de Deepseek ciertamente marca un nuevo territorio para construir modelos de manera más barata y eficiente. Quizás también sacudirá la conversación global sobre cómo las empresas de IA deberían recopilar y usar sus datos de capacitación.