Noticias

A deep dive analysis of 62 queries

Published

1 año agoon

The emergence of ChatGPT search has led to many questions about the quality of the overall results compared to Google.

This is a difficult question to answer, and in today’s article, I will provide some insights into how to do just that.

Note that our understanding is that the technology that makes it possible for OpenAI to offer a search capability is called SearchGPT, but the actual product name is ChatGPT search.

In this article, we will use the name ChatGPT search.

What’s in this report

This report presents an analysis of 62 queries to assess the strengths and weaknesses of each platform.

Each response was meticulously fact-checked and evaluated for alignment with potential user intents.

The process, requiring about an hour per query, highlighted that “seemingly good” and “actually good” answers often differ.

Additionally, when Google provided an AI Overview, it was scored against ChatGPT search.

A combined score for the AI Overviews and the rest of Google’s SERP was also included.

Of the queries tested – two-thirds of which were informational – Google returned an AI Overview in 25 instances (40% of the time).

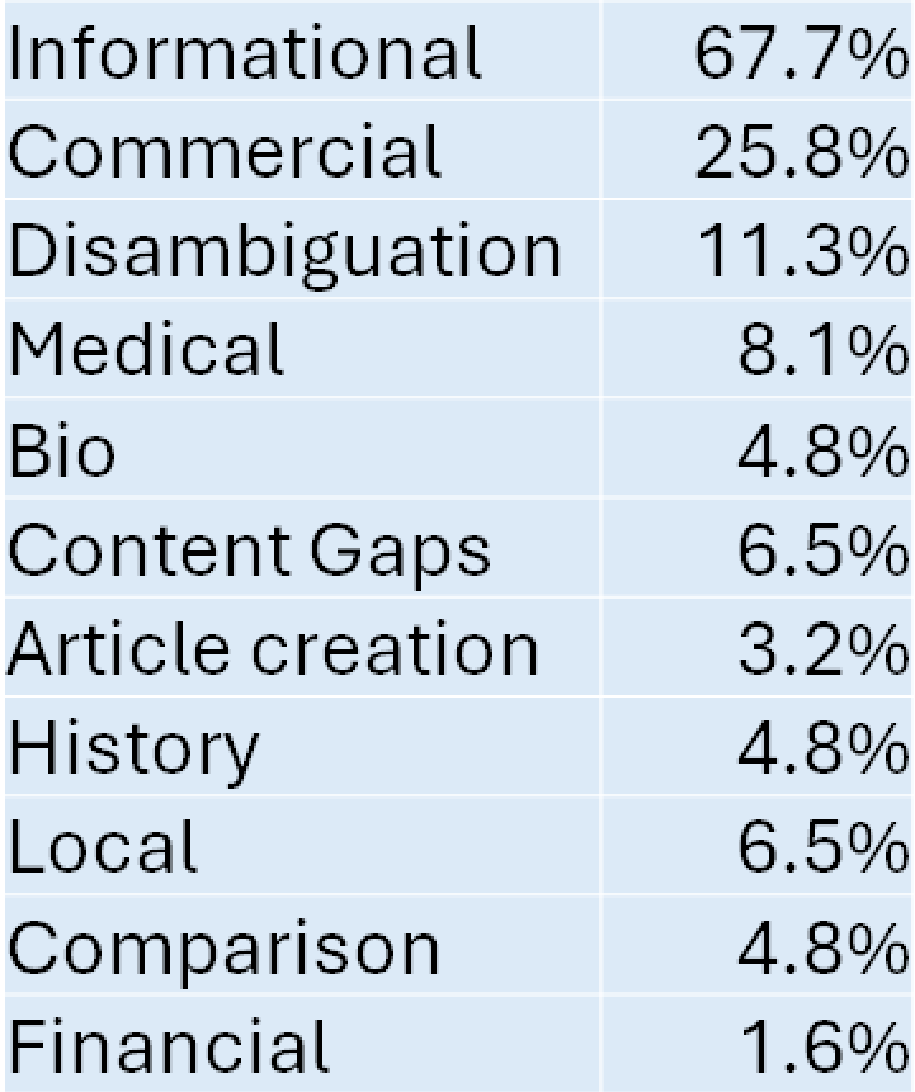

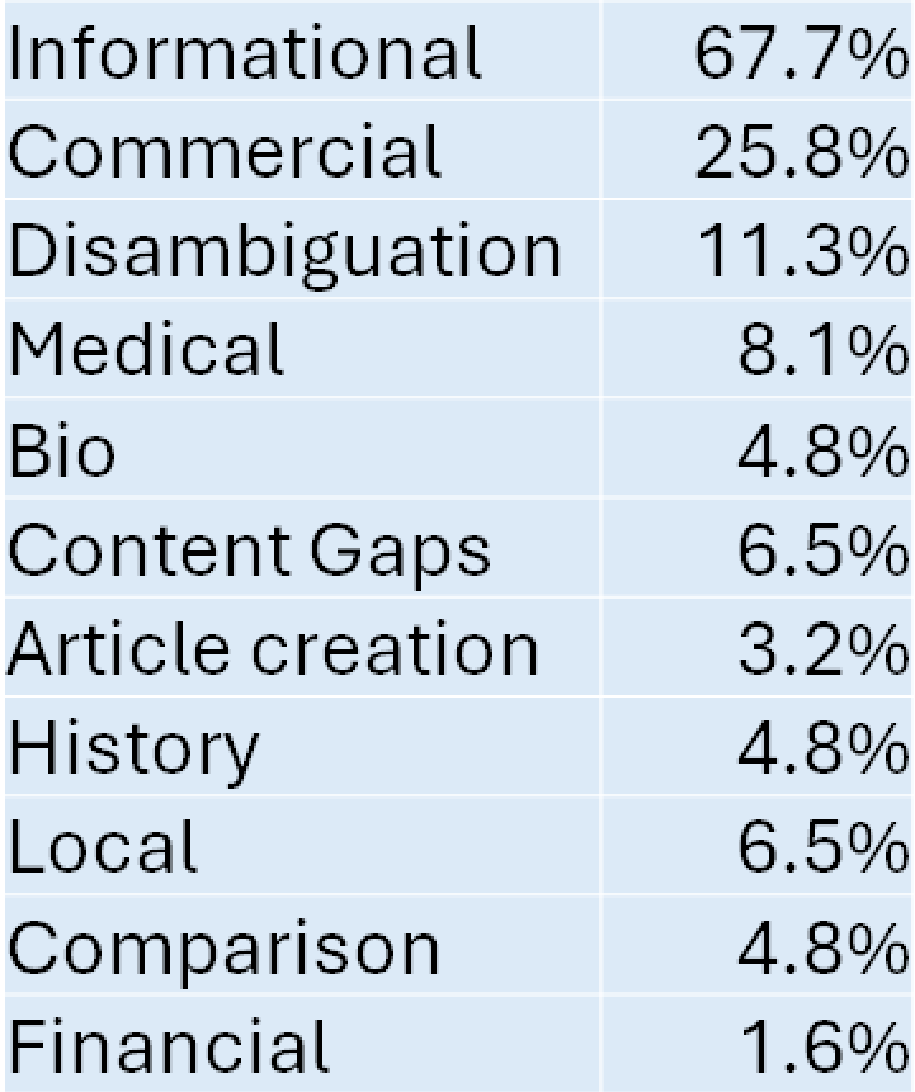

The queries analyzed fell into multiple categories:

The total number of the above is greater than 100%, and that’s because some queries could fall into more than one classification.

For example, about 13% of the queries were considered informational and commercial.

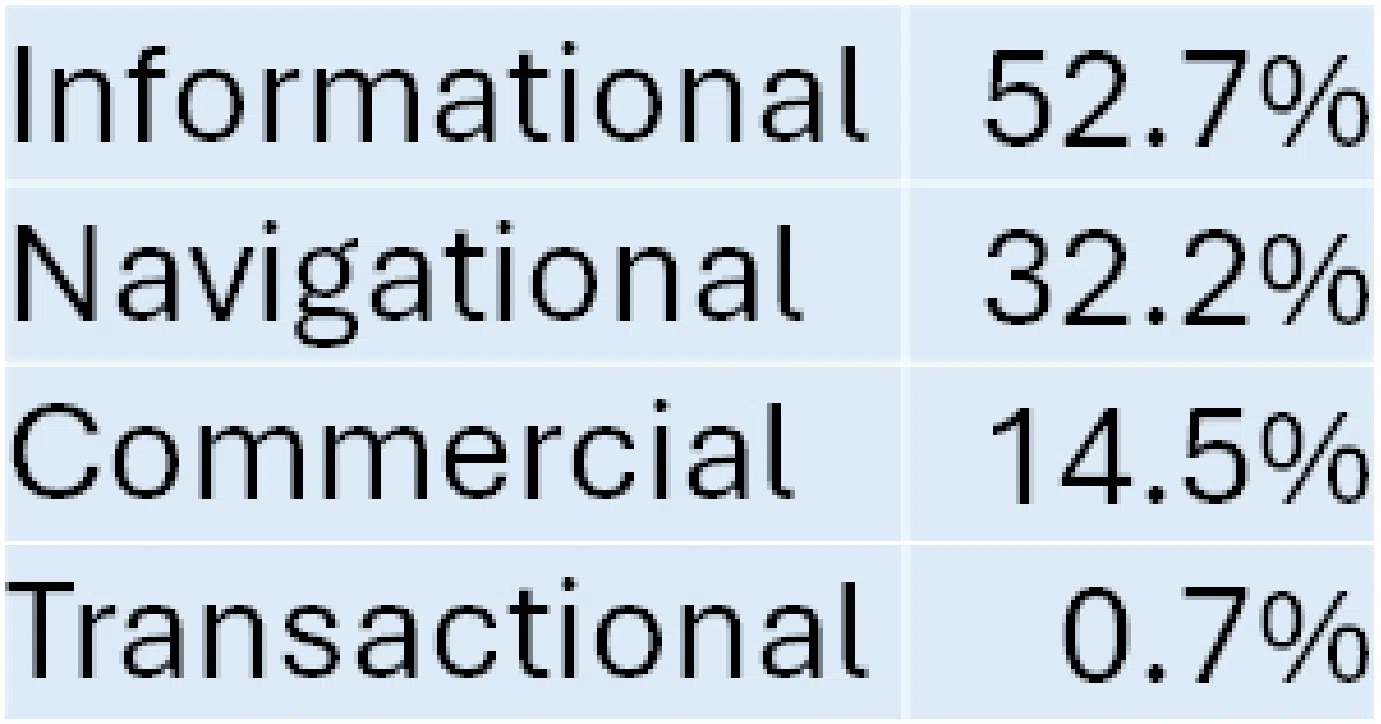

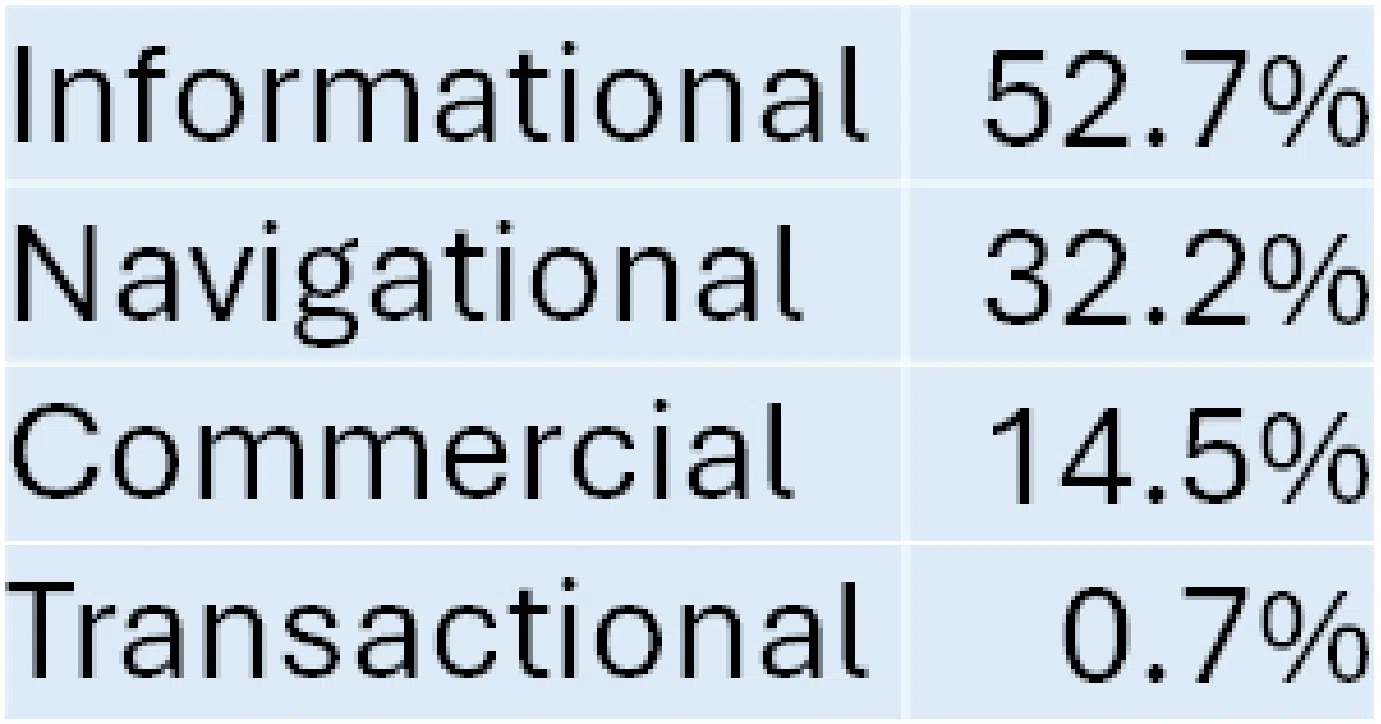

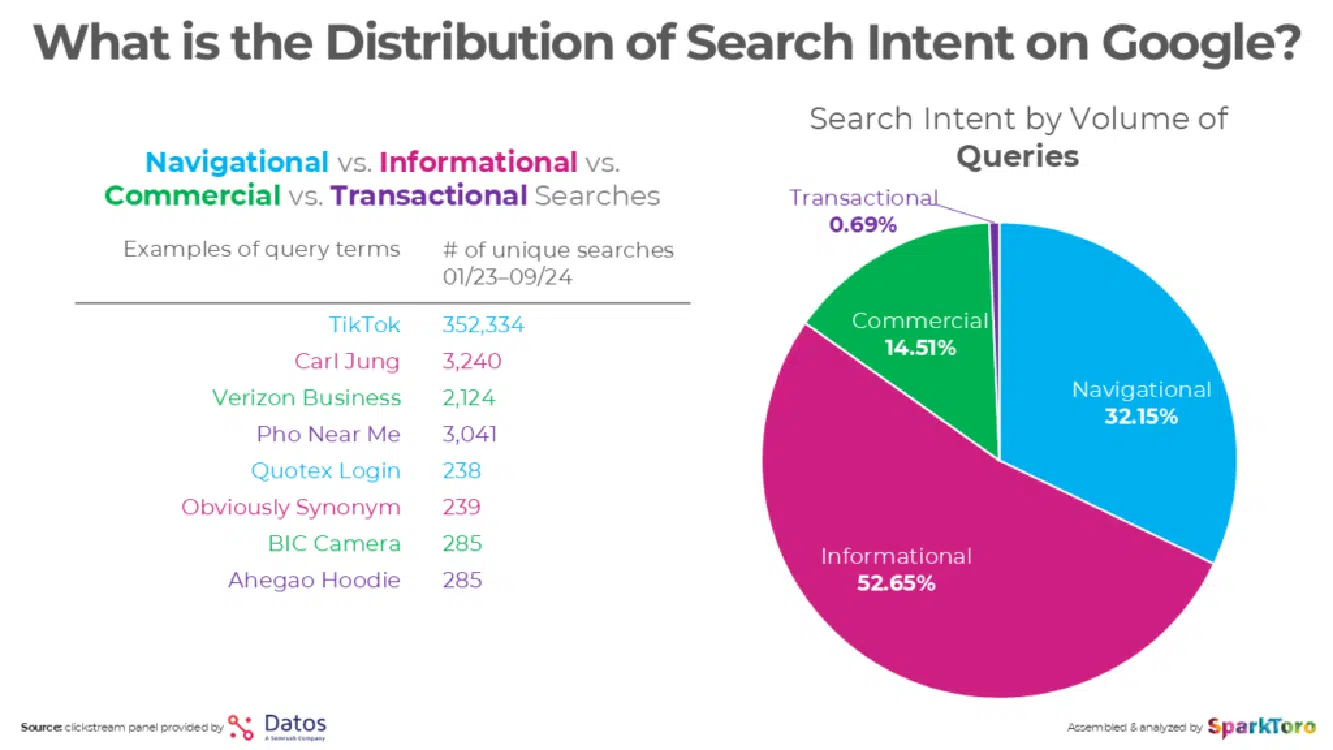

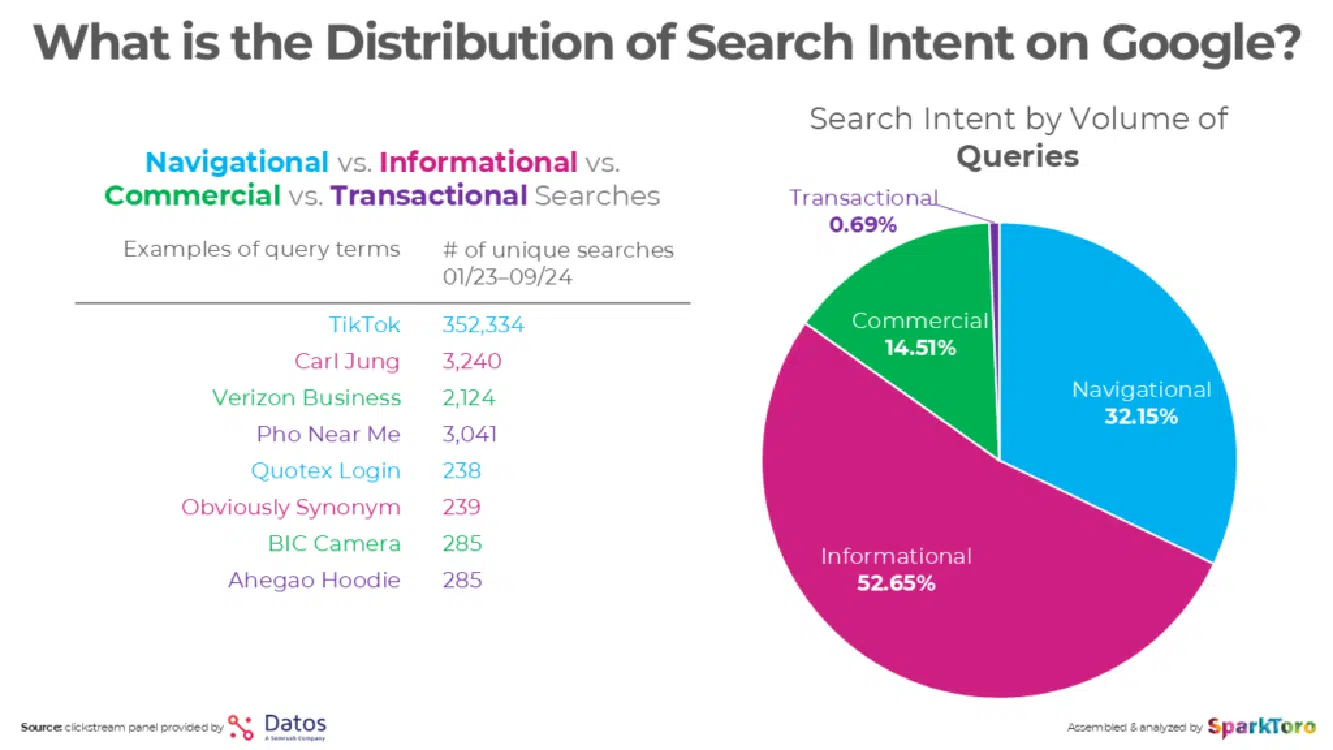

Detailed information from SparkToro on the makeup of queries suggests a natural distribution of search queries as follows:

Navigational queries, which comprise nearly a third of all queries, were excluded from this test.

These queries typically demand a straightforward response like, “just give me the website,” and are a category where Google excels.

However, I included queries likely to favor one platform, such as:

- Content gap analysis queries (4): Representing a broader class of content-related queries, which Google doesn’t handle but ChatGPT search attempts (though not always successfully).

- Locally oriented queries (4): These leverage Google’s extensive local business database, Google Maps, and Waze, areas where ChatGPT search struggles to compete.

Metrics used in this study

I designed 62 queries to reflect diverse query intents, aiming to highlight each platform’s strengths and weaknesses.

Each response was scored across specific metrics to evaluate performance effectively.

- Errors: Did the response include incorrect information?

- Omissions: Was important information not in the response?

- Weaknesses: Were other aspects of the response considered weak but not scored as an error or omission?

- Fully addresses: Was the user’s query intent substantially addressed?

- Follow-up resources: Did the response provide suitable resources for follow-up research?

- Quality: An assessment by me of the overall quality of the response. This was done by weighing the other factors contained in this list.

At the end of this article are the total scores for each platform across the 62 queries.

Competitive observations

When considering how different search platforms provide value, it’s important to understand the many aspects of the search experience. Here are some of those areas:

Advertising

Multiple reviewers note that ChatGPT search is ad-free and tout how much better this makes it than Google. That is certainly the case now, but it won’t stay that way.

Microsoft has $13 billion committed to OpenAI so far, and they want to make that money back (and then some).

In short, don’t expect ChatGPT search to remain ad-free. That will change significantly at some point.

An important note is that advertising works best on commercial queries.

As you will see later in this article, I scored Google’s performance on commercial queries significantly higher than ChatGPT search.

Understanding user intent

Google has been working on understanding user intent across nearly infinite scenarios since 2004 or earlier.

They’ve been collecting data based on all the user interactions within search and leveraging what they have seen with the Chrome browser since its launch in 2008.

This data has most likely been used to help train Google algorithms to understand user intent and brand authority on a per query basis.

For reference, as of November 2024, Statcounter pegs Chrome’s market share at 67.5%, Safari at 18.2%, and Edge at 4.8%

This is a critical advantage for Google because understanding the user intent of a query is what it’s all about.

You can’t possibly answer the user’s need without understanding their need. As I’ll illustrate in the next section, this is complex!

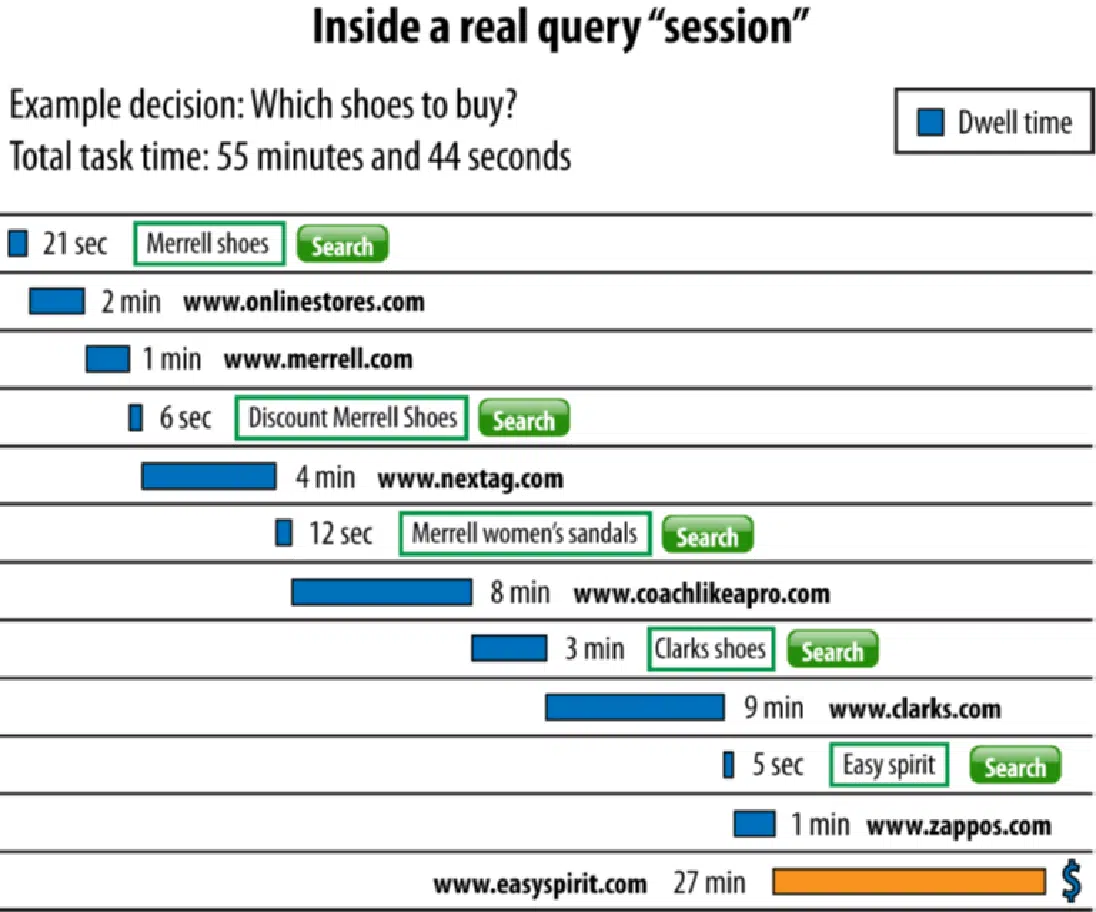

How query sessions work

Part of the problem with understanding user intent is that the user may not have fully worked out what they’re looking for until they start the process.

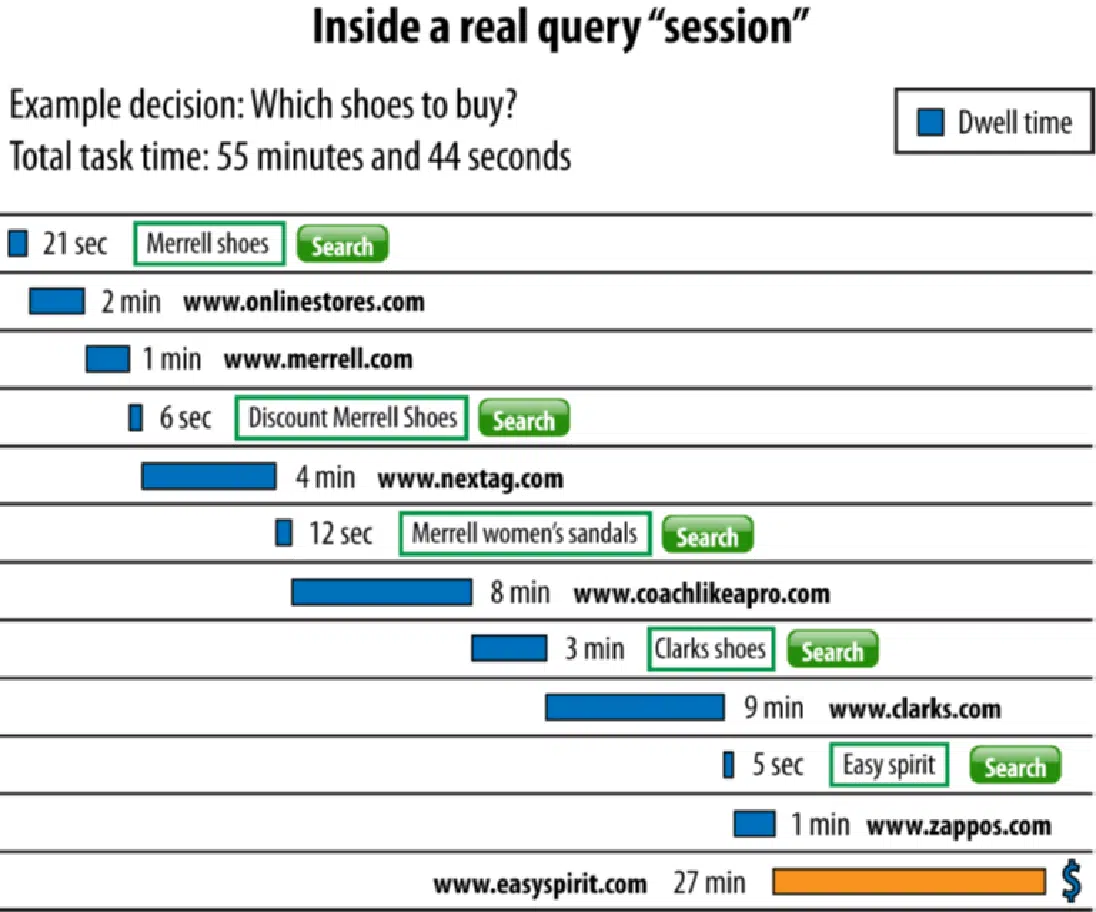

Consider the following example of a query sequence that was given to me via Microsoft many years ago:

The initial query seems quite simple: “Merrell Shoes.”

You can imagine that the user entering that query often has a specific Merrell shoe in mind, or at least a shoe type, that they want to buy.

However, we see this user’s path has many twists and turns.

For example, the second site they visit is www.merrell.com, a website you might suspect has authoritative information about Merrell shoes.

However, this site doesn’t appear to satisfy the user’s needs.

The user ends up trying four more different queries and visiting six different websites before they finally execute a transaction on www.zappos.com.

This degree of uncertainty in search query journeys is quite common.

Some of the reasons why users have this lack of clarity include is that they:

- Don’t fully understand the need that they’re feeling.

- Don’t know how to ask the right questions to address their need.

- Need more information on a topic before deciding what they need.

- Are in general exploration mode.

Addressing this is an essential aspect of providing a great search experience. This is why the Follow-Up Resources score is part of my analysis.

Understanding categories of queries

Queries can be broadly categorized into several distinct groups, as outlined below:

- Informational: Queries where the user wants information (e.g., “what is diabetes?”).

- Navigational: Queries where the user wants to go to a specific website or page (e.g., “United Mileage Club”).

- Commercial: Queries where the user wants to learn about a product or service (e.g., “Teak dining table”).

- Transactional: Queries where the user is ready to conduct a transaction (e.g., “pizza near me”).

Recent data from SparkToro’s Rand Fishkin provides some insight into the percentage of search queries that fall into each of these categories:

Be advised that the above is a broad view of the categories of queries.

The real work in search relates to handling searches on a query-by-query basis. Each query has many unique aspects that affect how it can be interpreted.

Next, we’ll examine several examples to illustrate this. Then, we’ll compare how ChatGPT search and Google performed on these queries.

Query type: Directions

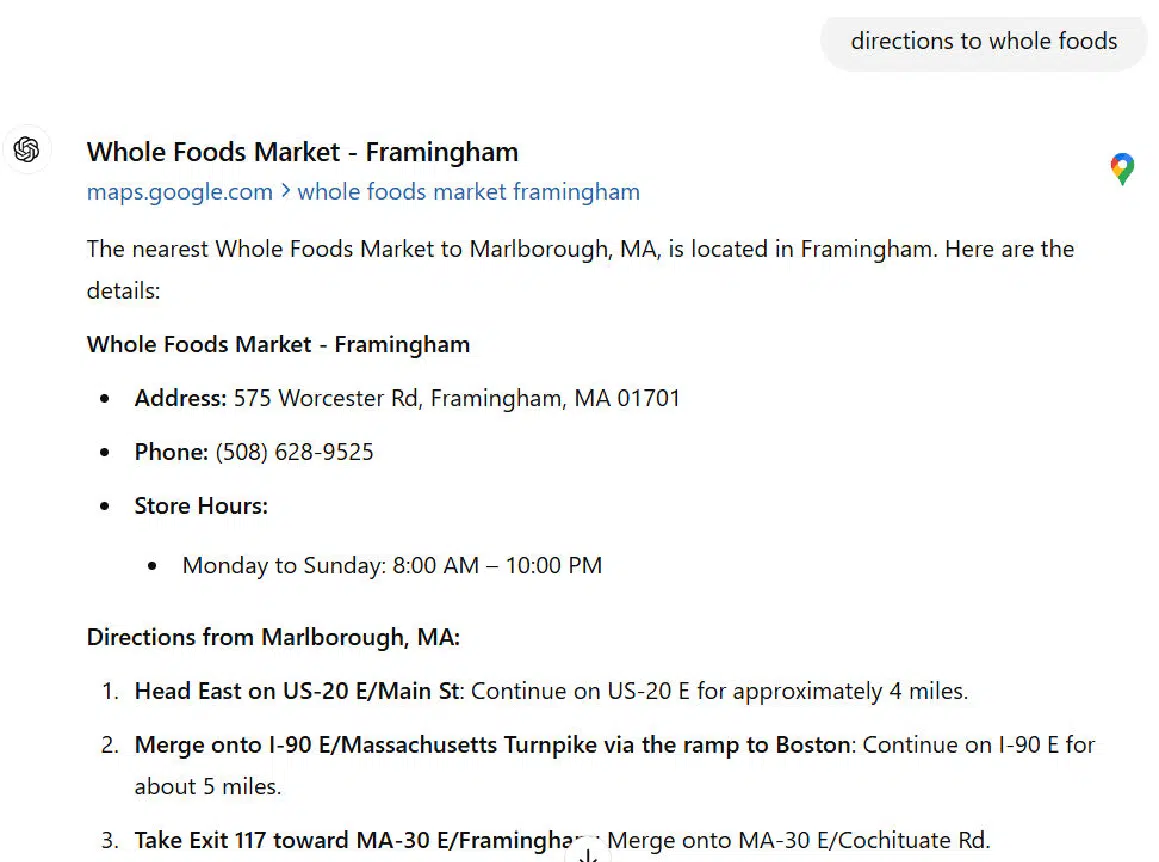

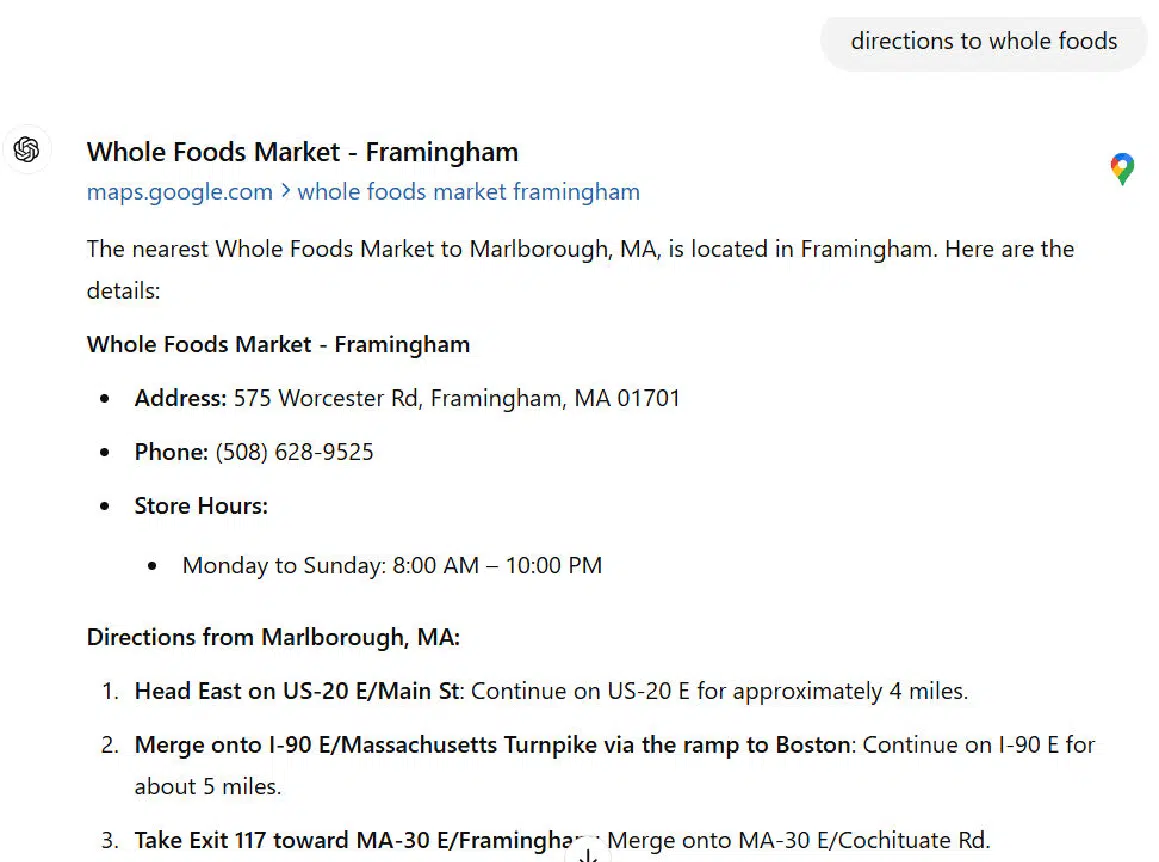

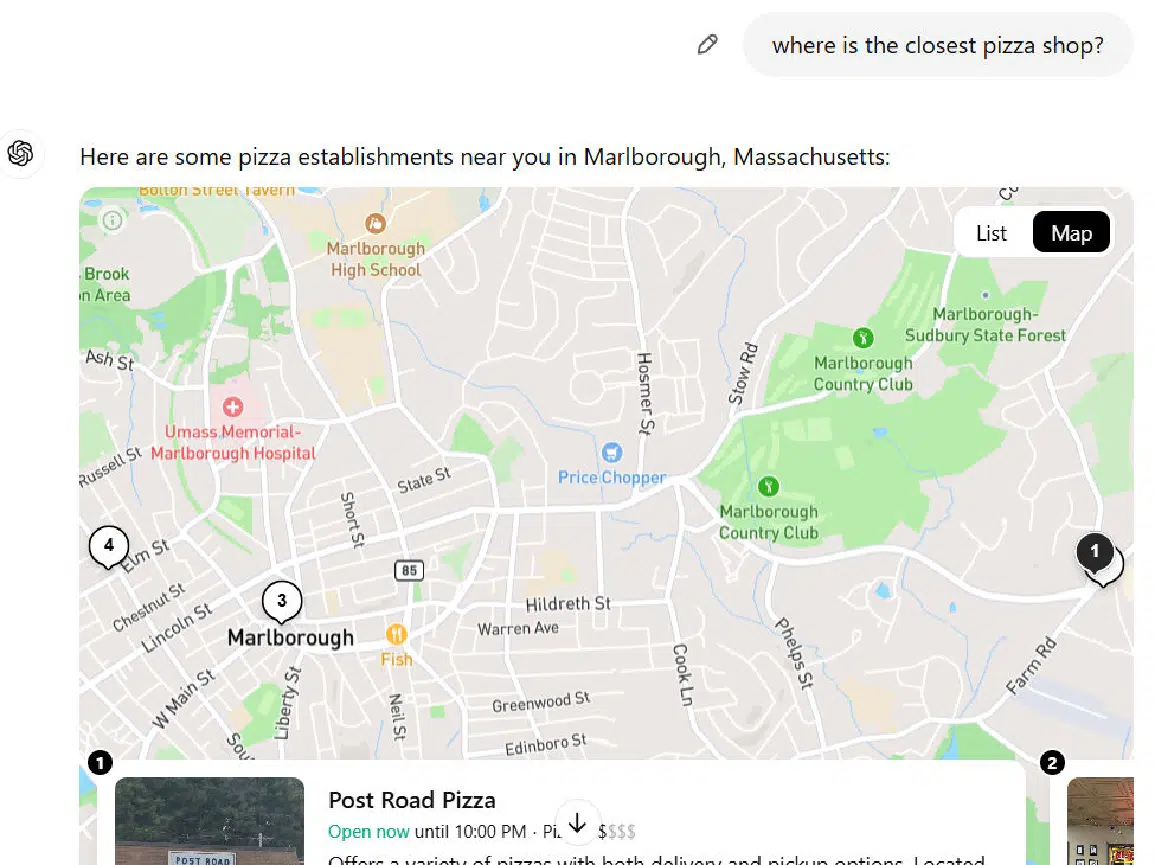

This query type is a natural strength for Google (as is any locally oriented query). We can see ChatGPT search’s weaknesses in this area in its response:

The problems with this response are numerous.

For example, I wasn’t in Marlborough, Massachusetts, when I did the query (I was in the neighboring town of Southborough).

In addition, steps 1 and 2 in the directions are unclear. Anyone following them and heading east on Route 20 would end up at Kenmore Square in Boston without ever crossing I-90 East.

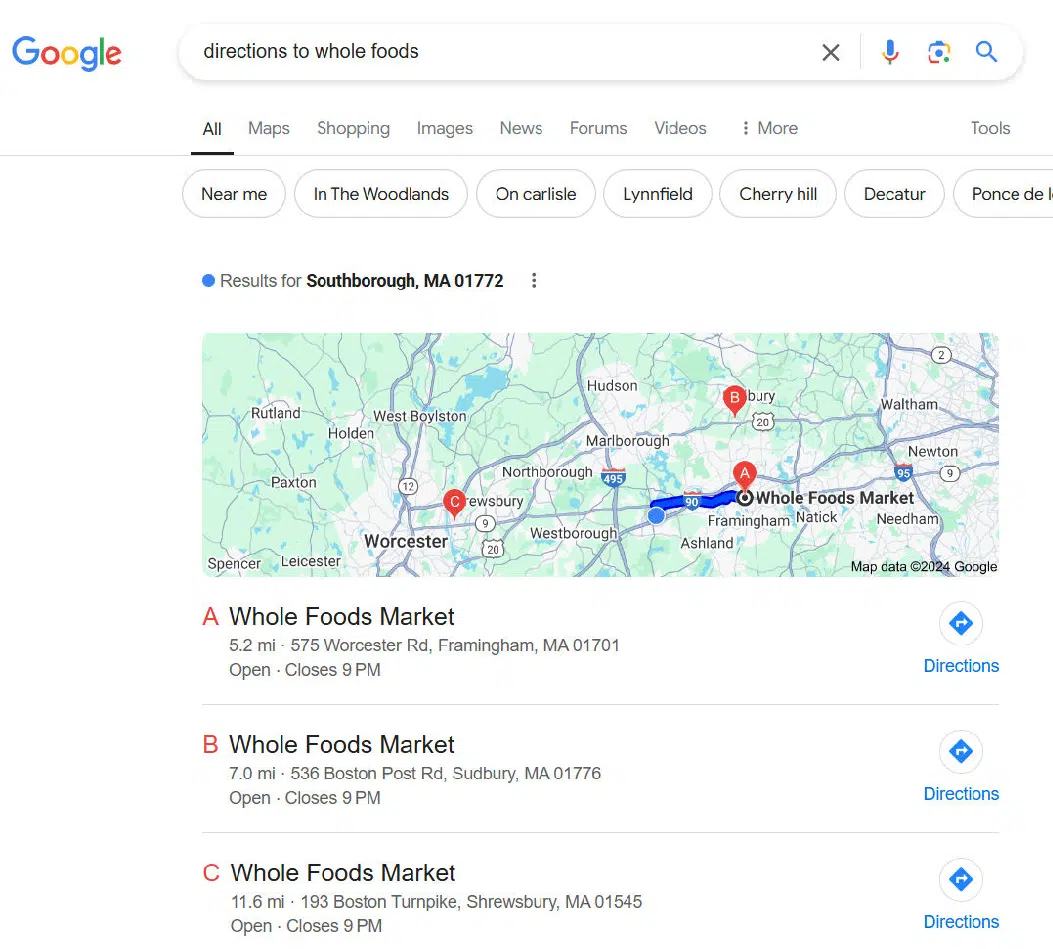

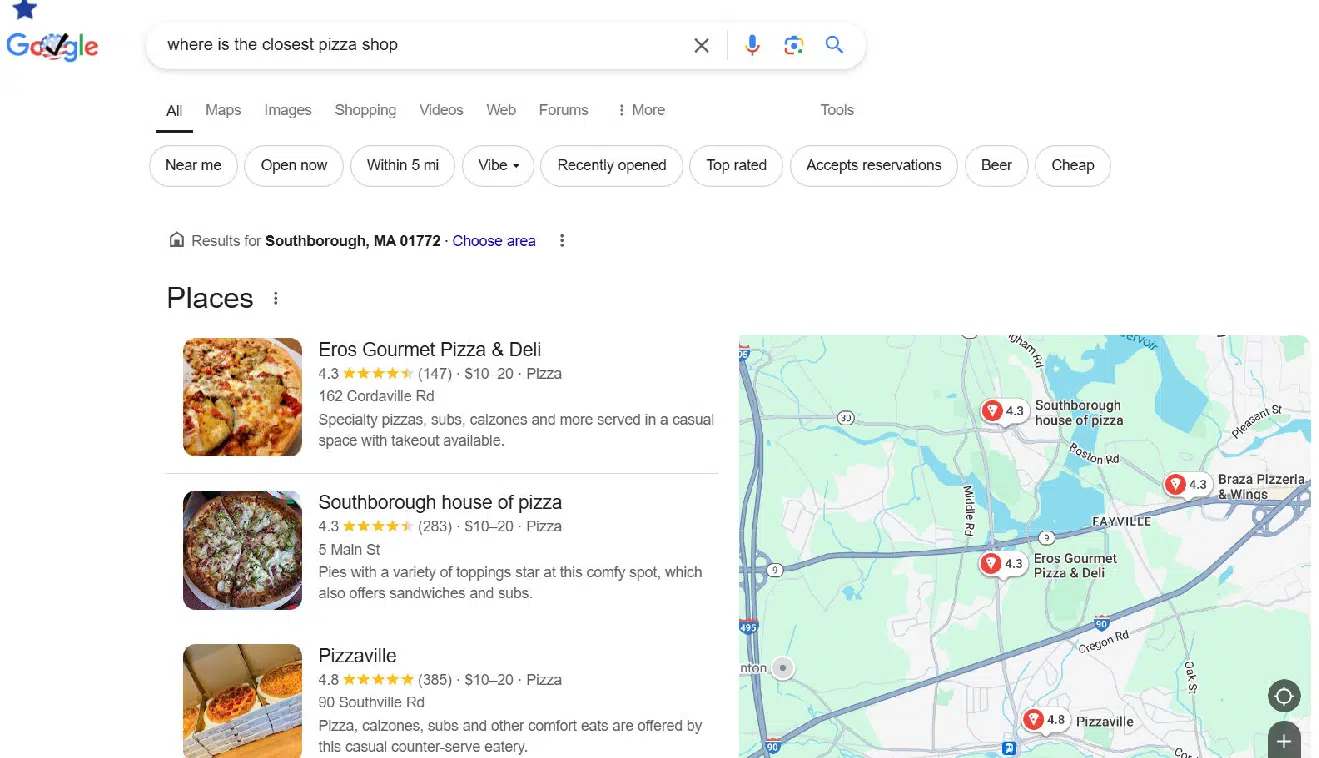

In contrast, Google nails it:

The reason why Google handles this better is simple.

Google Maps has an estimated 118 million users in the U.S., and Waze adds another 30 million users.

I wasn’t able to find a reasonable estimate for Bing Maps, but suffice it to say that it’s far lower than Google’s.

The reason Google is so much better than Bing here is simple – I use Google Maps, and that lets Google know exactly where I am.

This advantage applies to all Google Maps and Waze users in the U.S.

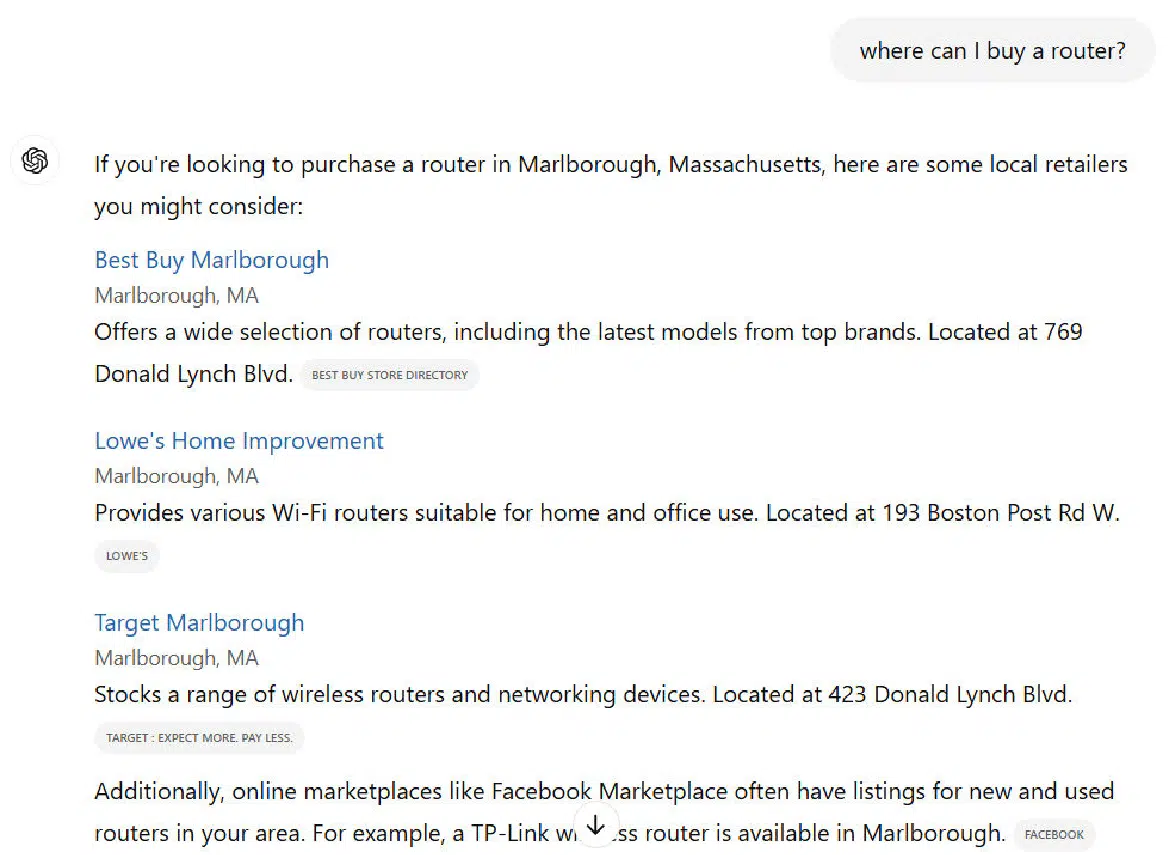

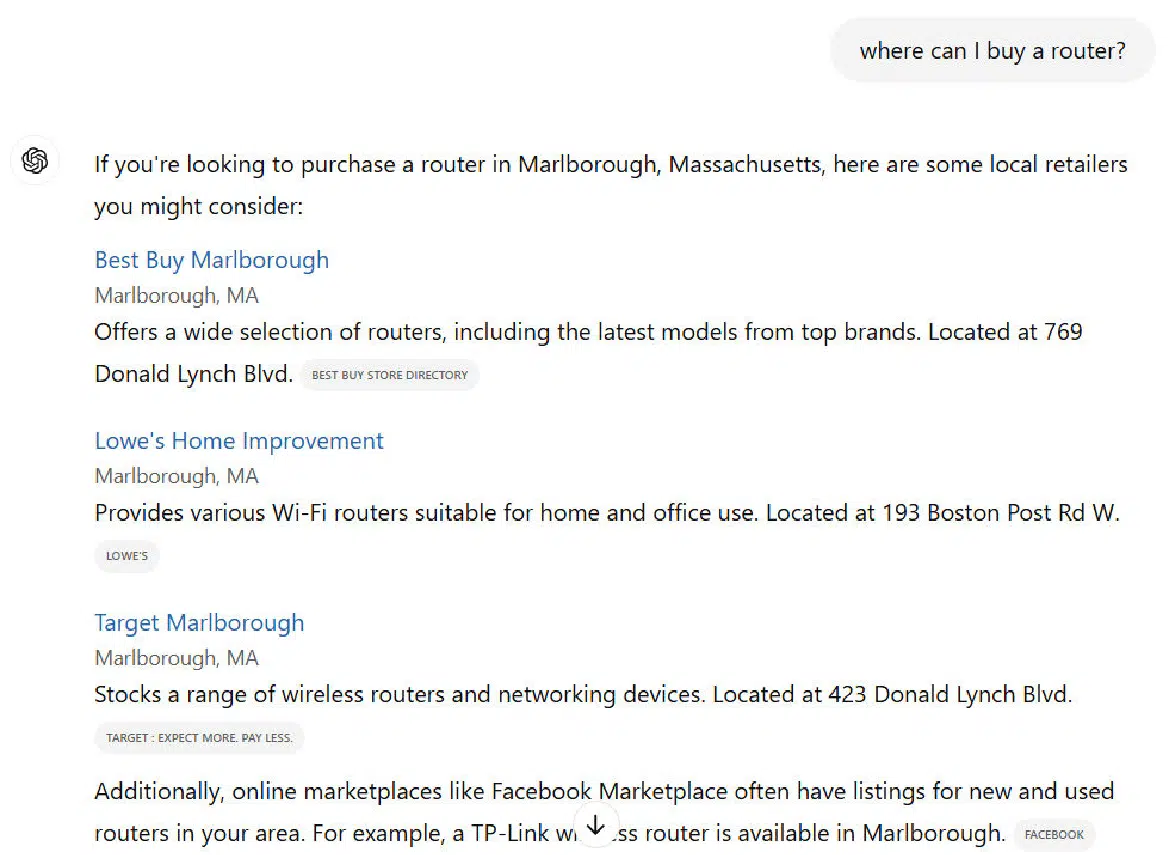

Query type: Local

Other types of local queries present similar issues to those of ChatGPT search. Note that a large percentage of search queries have local intent.

One estimate pegged this at 46% of all queries. This was reportedly shared by a Googler during a Secrets of Local Search conference at GoogleHQ in 2018.

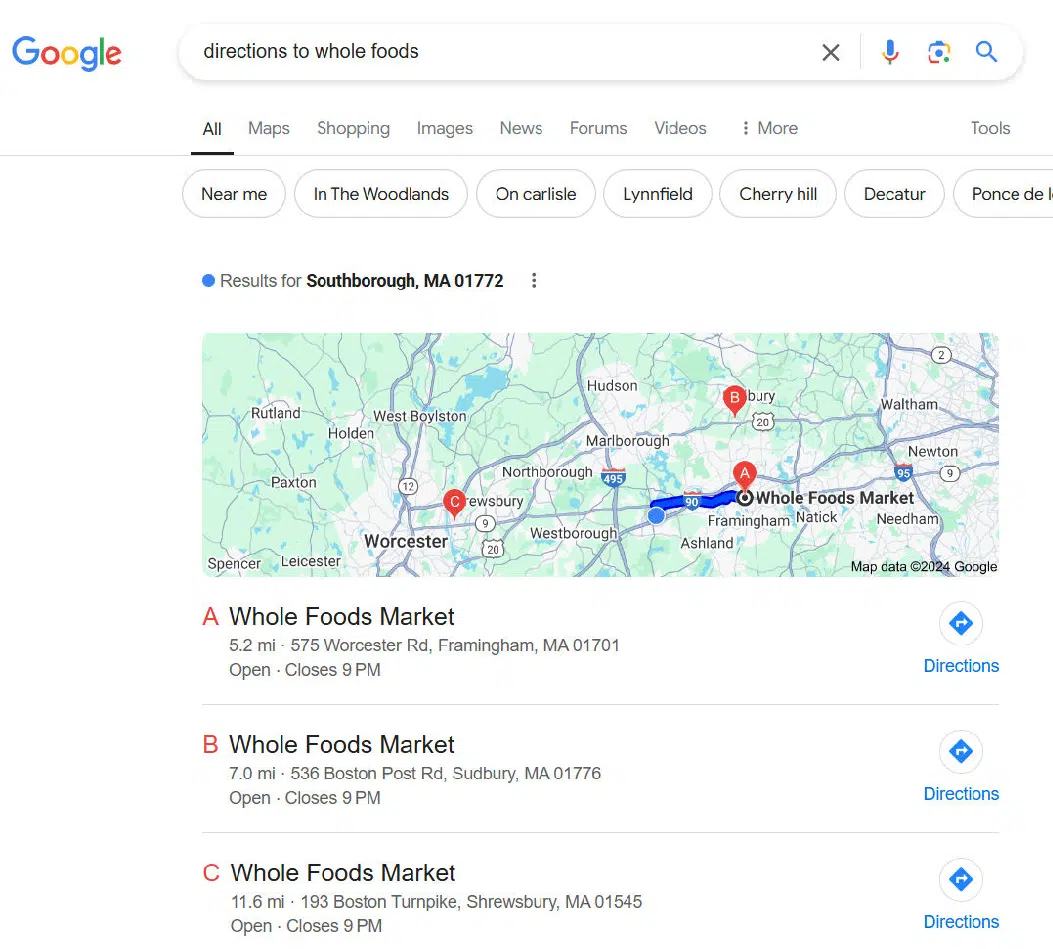

Here is ChatGPT’s response to one example query that I tested:

As with the directions example, it thinks that I’m in Marlborough.

In addition, it shows two pizza shops in Marlborough (only one of the two is shown in my screenshot).

Google’s response to this query is much more on point:

I also gave Google a second version of the query “Pizza shops in Marlborough,” and it returned 11 locations – 9 more than I saw from the ChatGPT search.

This shows us that Google also has far more access to local business data than ChatGPT search.

For this query class (including the Directions discussed previously), I assigned these scores:

- ChatGPT search: 2.00.

- Google: 6.25.

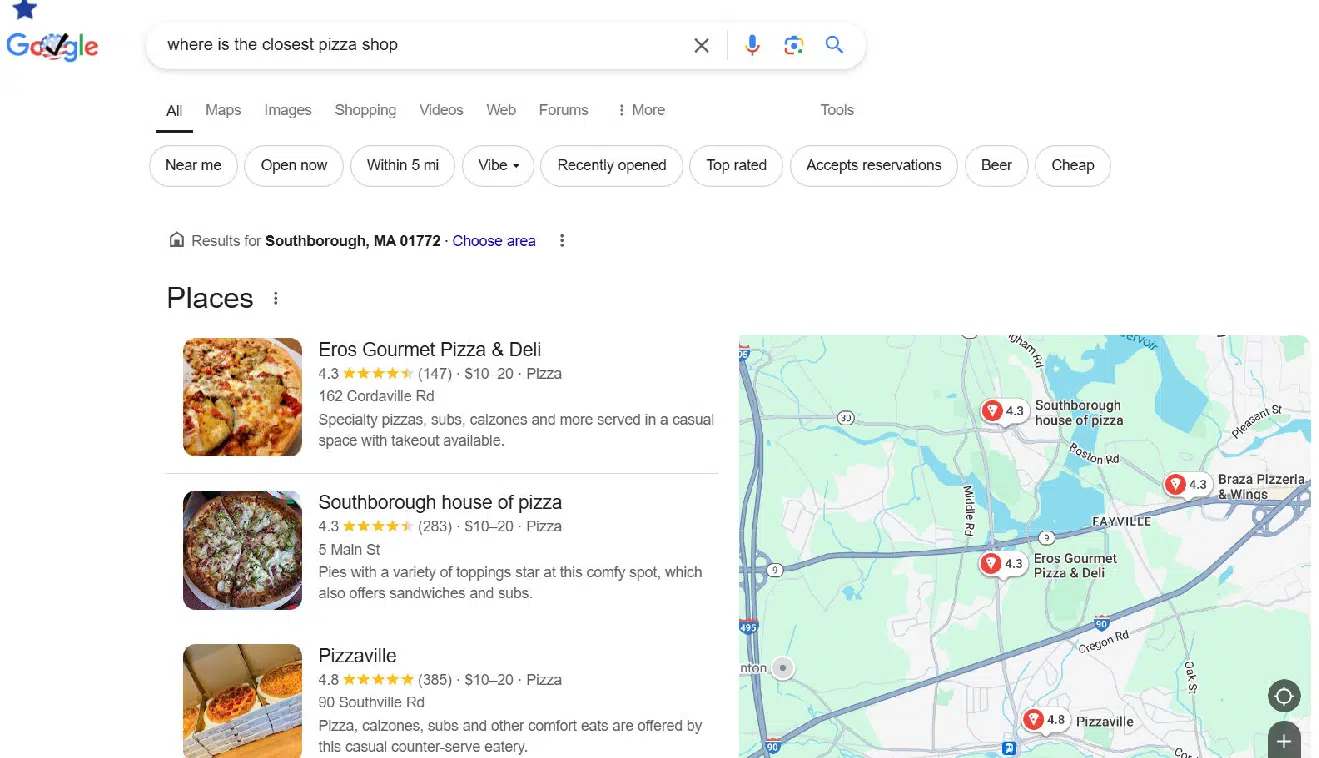

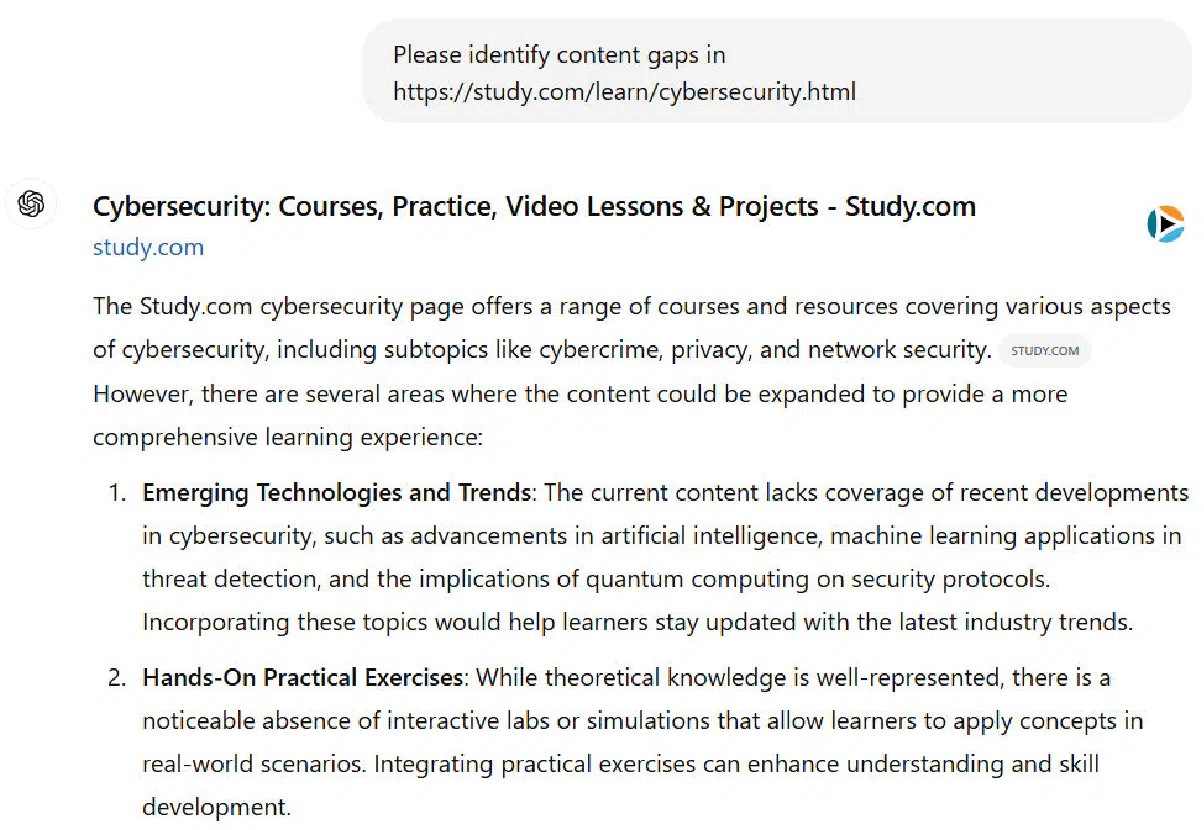

Query type: Content gap analysis

A content gap analysis is one of the most exciting SEO tasks that you can potentially do with generative AI tools.

The concept is simple: provide the tool of your choice a URL from a page on your site that you’d like to improve and ask it to identify weaknesses in the content.

As with most things involving generative AI tools, it’s best to use this type of query as part of a brainstorming process that your subject matter expert writer can use as input to a larger process they go through to update your content.

There are many other different types of content analysis queries that you can do with generative AI that you can’t do with Google (even with AI Overviews) at this point.

For this study, I did four content gap analysis queries to evaluate how well ChatGPT search did with its responses.

Google presented search results related to the page I targeted in the query but did not generate an AI Overview in any of the four cases.

However, ChatGPT search’s responses had significant errors for three of the four queries I tested.

Here is the beginning of ChatGPT search’s response to the one example query where the scope of errors was small:

This result from ChatGPT isn’t perfect (there are a few weaknesses, but it’s pretty good. The start of Google’s response to the same query:

As you can see, Google hasn’t even attempted to perform a content gap analysis. ChatGPT search is better set up to address this type of query.

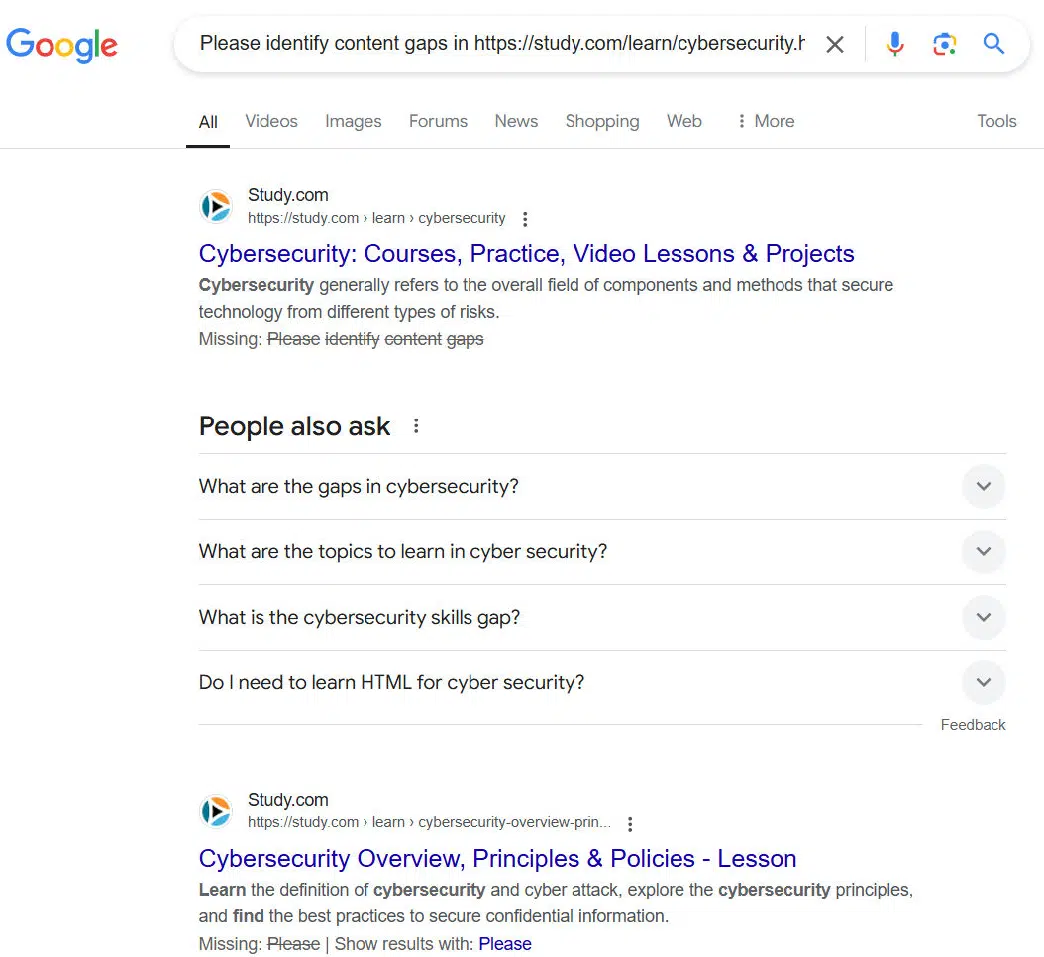

However, ChatGPT search doesn’t earn a clean sweep for this type of query.

Here is the first part of another example result:

This looks good in principle, but it’s filled with errors. Some of these are:

- The Britannica article does discuss the depth of Larry Bird’s impact on Indiana State University.

- The Britannica article does mention the importance of the Larry Bird / Magic Johnson rivalry to the NBA

- The ChatGPT search response is longer than shown here and there are other errors beyond what I mention here.

Overall, I tried four different content gap analysis queries and ChatGPT search made significant errors in three of them. For this query, I assigned these scores:

- ChatGPT search: 3.25.

- Google: 1.00.

Query type: Individual bio

How these queries perform is impacted by how well-known the person is.

If the person is very famous, such as Lionel Messi, there will be large volumes of material written about them.

If the amount of material written about the person is relatively limited, there is a higher probability that the published online information hasn’t been kept up to date or fact-checked.

We see that in the responses to the query from both ChatGPT search and Google.

Here is what we see from ChatGPT search:

The main issues with this response are in the third paragraph.

I haven’t written for Search Engine Journal in a long time, and it’s also been more than six years since I published a video on my YouTube channel (@stonetemplecons).

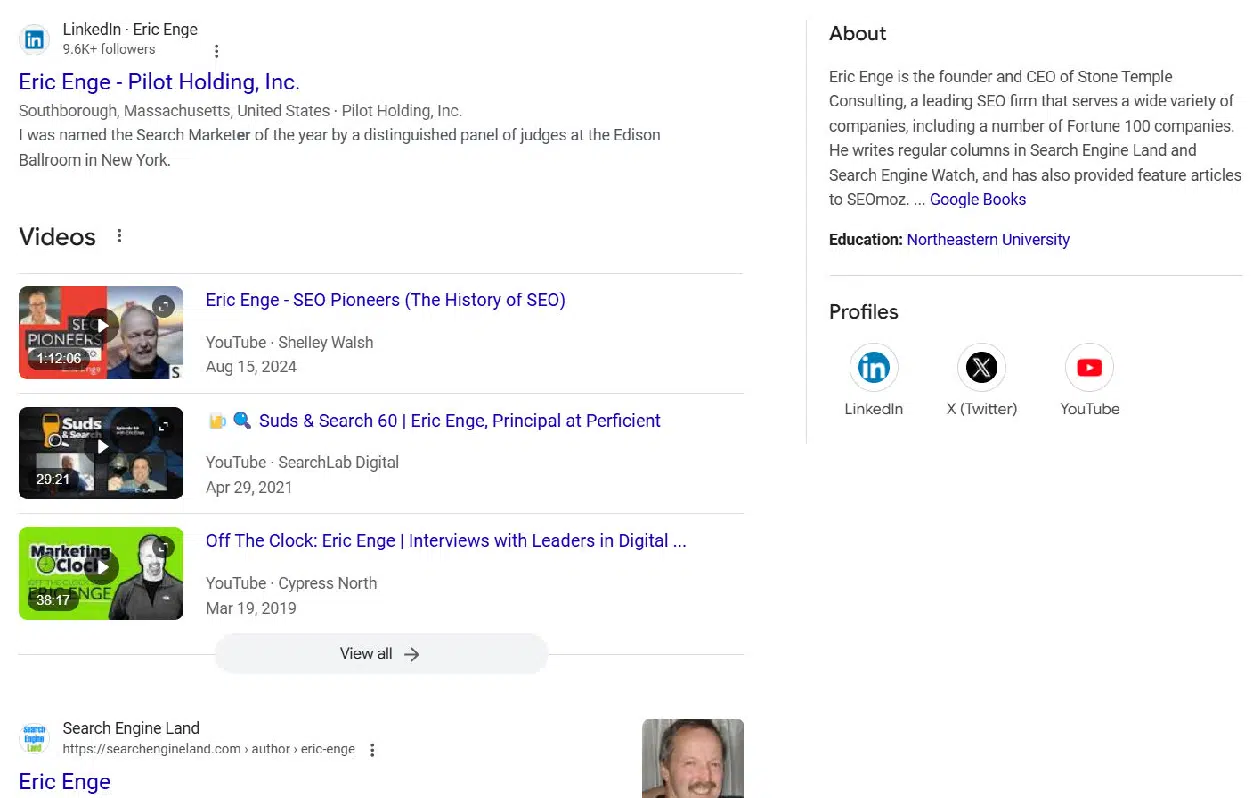

Let’s see what Google has to say:

Google also has problems with its response. They lead with quite a few images of me (which are all accurate), and below that, they show my LinkedIn profile and a summary of me drawn from Google Books.

Here, it says that I write for Search Engine Watch (haven’t done that for more than a decade!) and SEOMoz (which rebranded to SEOmoz to Moz in 2013) (also more than a decade!).

These responses are both examples of what I call “Garbage-In-Garbage-Out” queries.

If the web sources aren’t accurate, the tools don’t have the correct information to render.

For bio queries (3 of them), I scored the competitors as follows:

- ChatGPT search: 6.00.

- Google: 5.00.

Query type: Debatable user intent

Arguably, nearly every search query has debatable user intent, but some cases are more extreme than others.

Consider, for example, queries like these:

- Diabetes.

- Washington Commanders.

- Physics.

- Ford Mustang.

Each of these examples represents an extremely broad query that could have many different intents behind it.

In the case of diabetes:

- Does the person just discover that they have (or a loved one has) diabetes, and they want a wide range of general information on the topic?

- Are they focused on treatment options? Long-term outlook? Medications? All of the above?

Or, for a term like physics:

- Do they want a broad definition of what it’s about?

- Or is there some specific aspect of physics that they wish to learn much more about?

Creating the best possible user experience for queries like these is tricky because your response should provide opportunities for each of the most common possible user intents.

For example, here is how ChatGPT responded to the query “physics”:

The additional two paragraphs of the response focused on the definition of Physics and kept the response at a very high level.

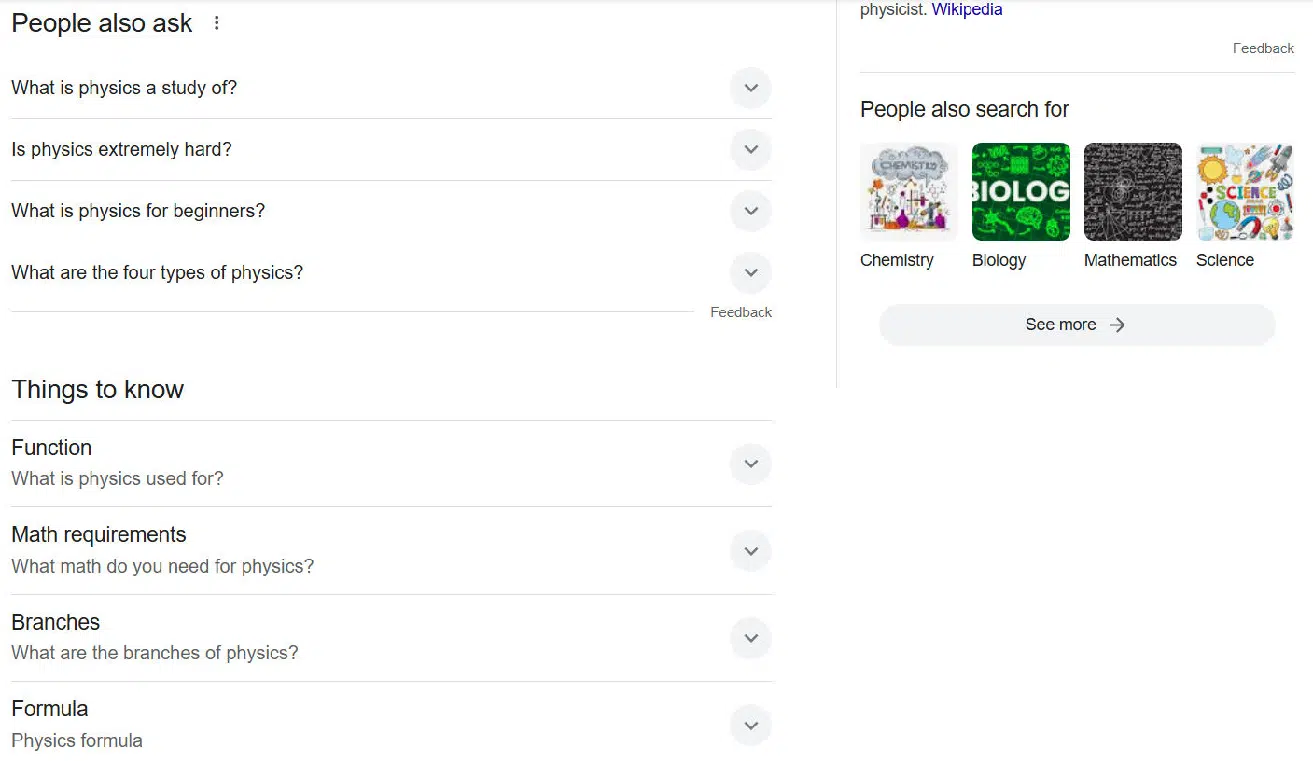

In contrast, the beginning of Google’s response also focuses on a broad definition of physics, but following that are People Also Ask and Things to Know boxes that address many other potential areas of interest to people who type in this search query:

This part of Google’s response shows a recognition of the many possible intents that users who type in the phrase “physics” may have in mind.

For this query, I assigned these scores:

- ChatGPT search: 5.00.

- Google: 7.00.

Query type: Disambiguation

One special class of debatable intents queries is words or phrases that require disambiguation. Here are some example queries that I included in my test set:

- Where is the best place to buy a router?

- What is a jaguar?

- What is mercury?

- What is a joker?

- What is a bat?

- Racket meaning.

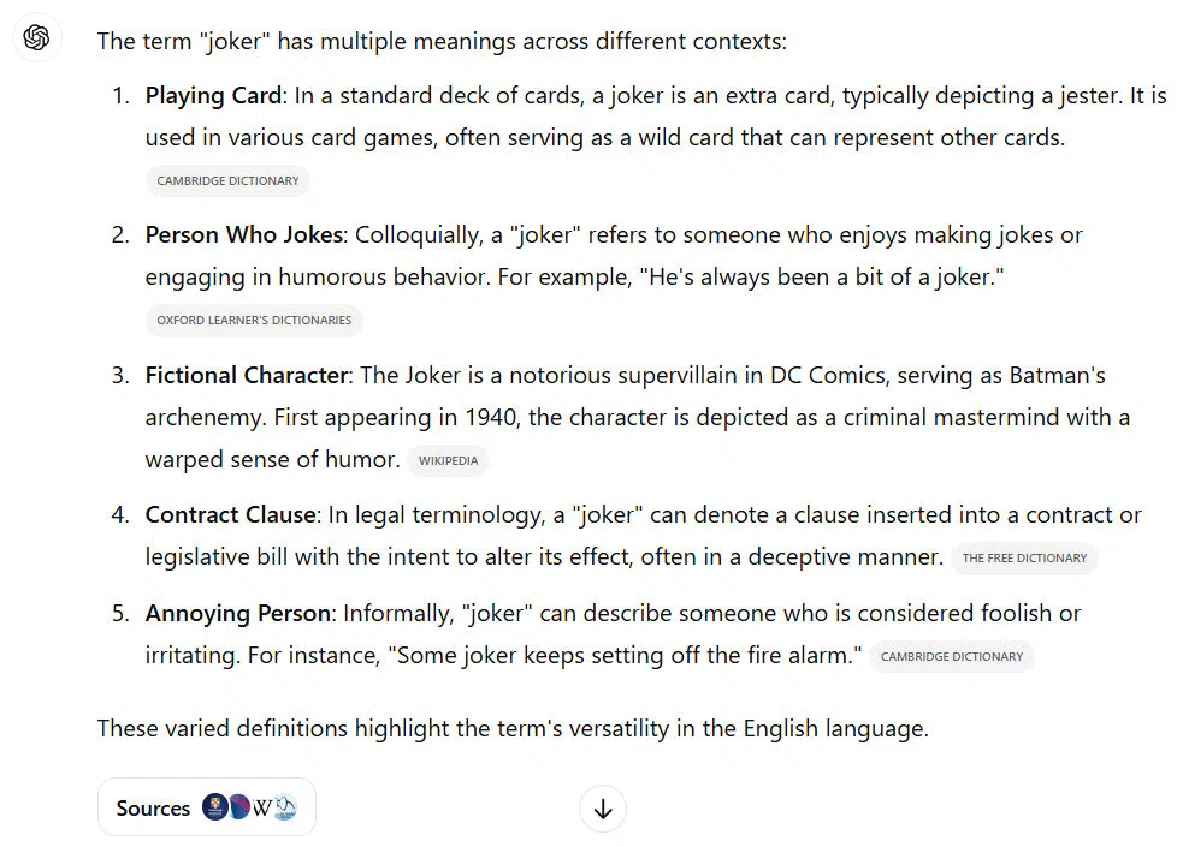

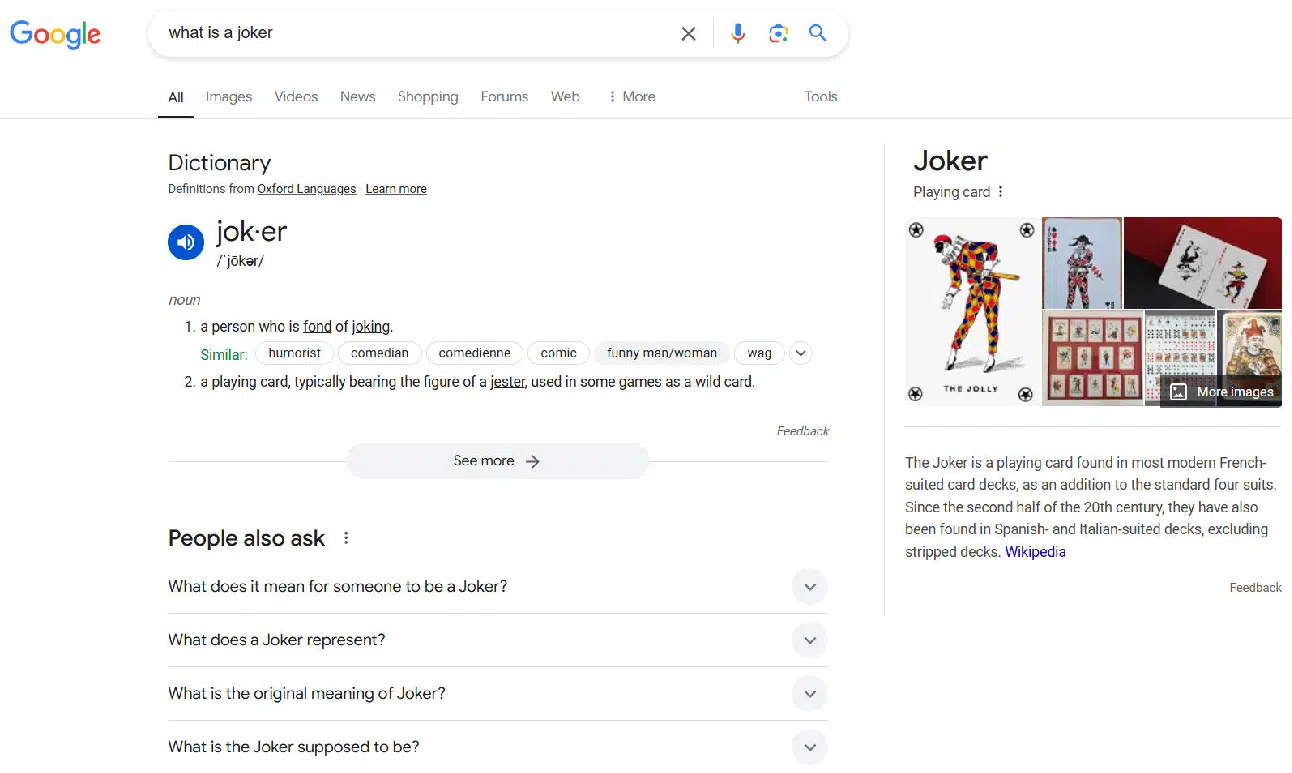

For example, here is how ChatGPT search responded to the question, “What is a joker query?”

We can see that it offers a nice disambiguation table that provides a brief definition for five different meanings of the term.

It also includes links to pages on the web that users can visit for information related to each meaning.

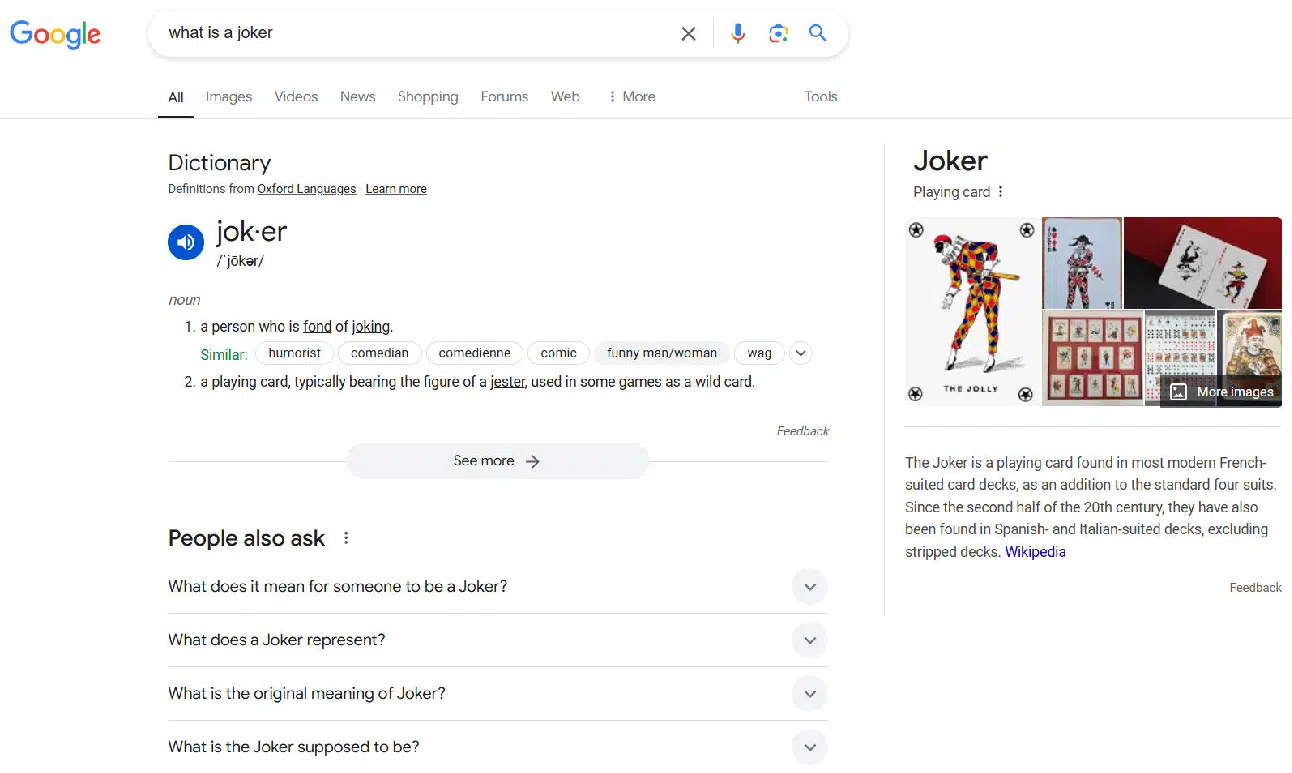

In contrast, Google focuses on two major intents:

Google’s focus is on the playing card and a person who tells a lot of jokes.

Following this part of the SERP, Google continues this approach with websites focusing on these two definitions.

This means that someone who’s interested in the word “joker” as it applies to contract clauses will have to do an additional search to find what they were looking for (e.g., “meaning of joker when referring to contract clauses”).

Which is better?

Well, it depends.

If the searchers interested in playing cards or people who tell lots of jokes make up more than 90% of the people who enter this search query, then the Google result might be the better of the two.

As it is, I scored the ChatGPT search result a bit higher than Google’s for this query.

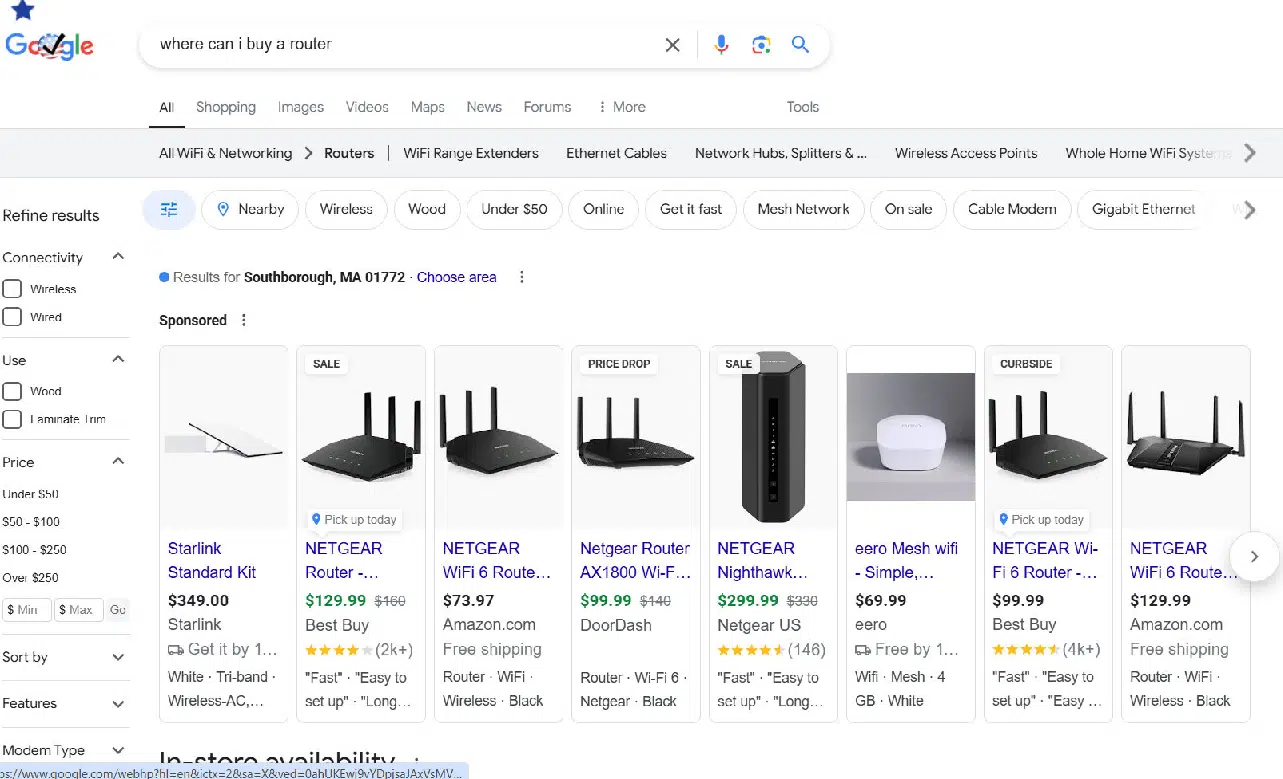

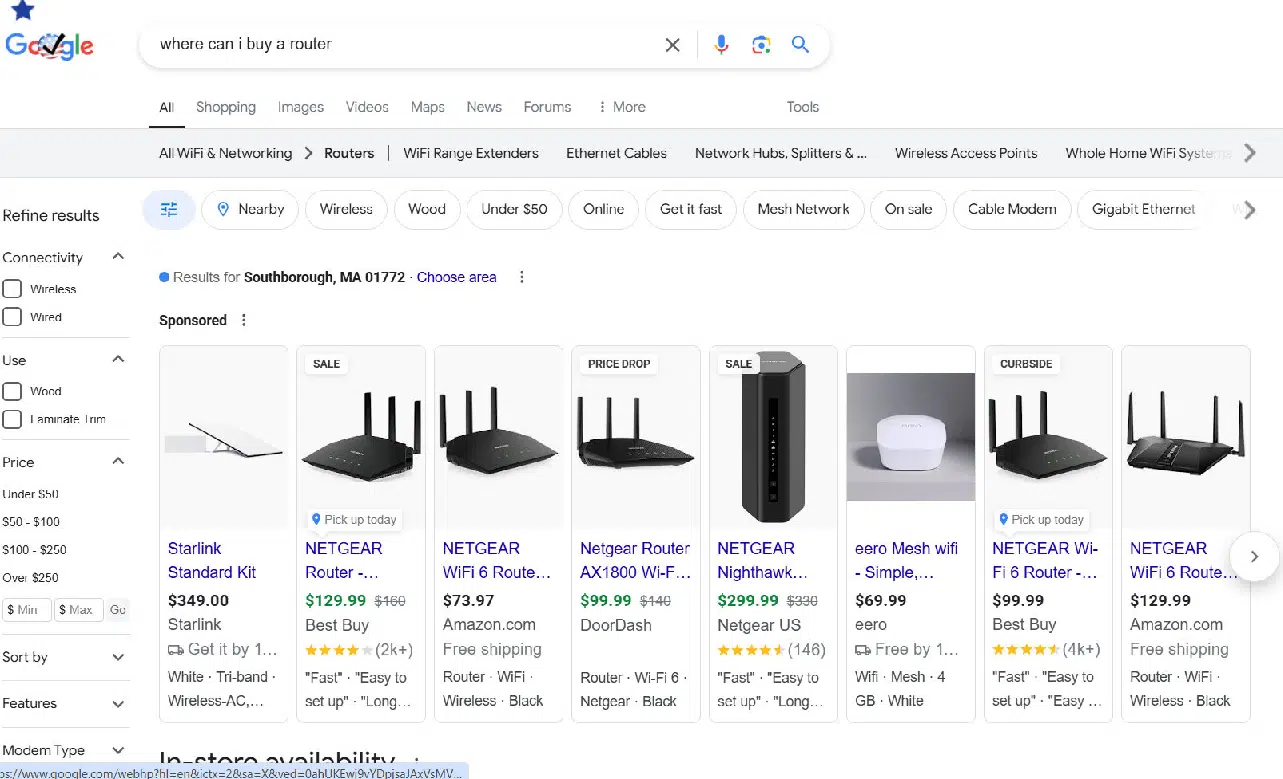

Another example of disambiguation failure is simply not addressing it at all. Consider the query example: “where is the best place to buy a router?”

Here is how ChatGPT search addressed it:

You might think this result is perfect, but routers also refer to a tool used in woodworking projects.

I use one frequently as a part of building furniture from scratch (true story).

There is a large enough audience of people who use these types of routers that I hope to see recognition of this in the SERPs.

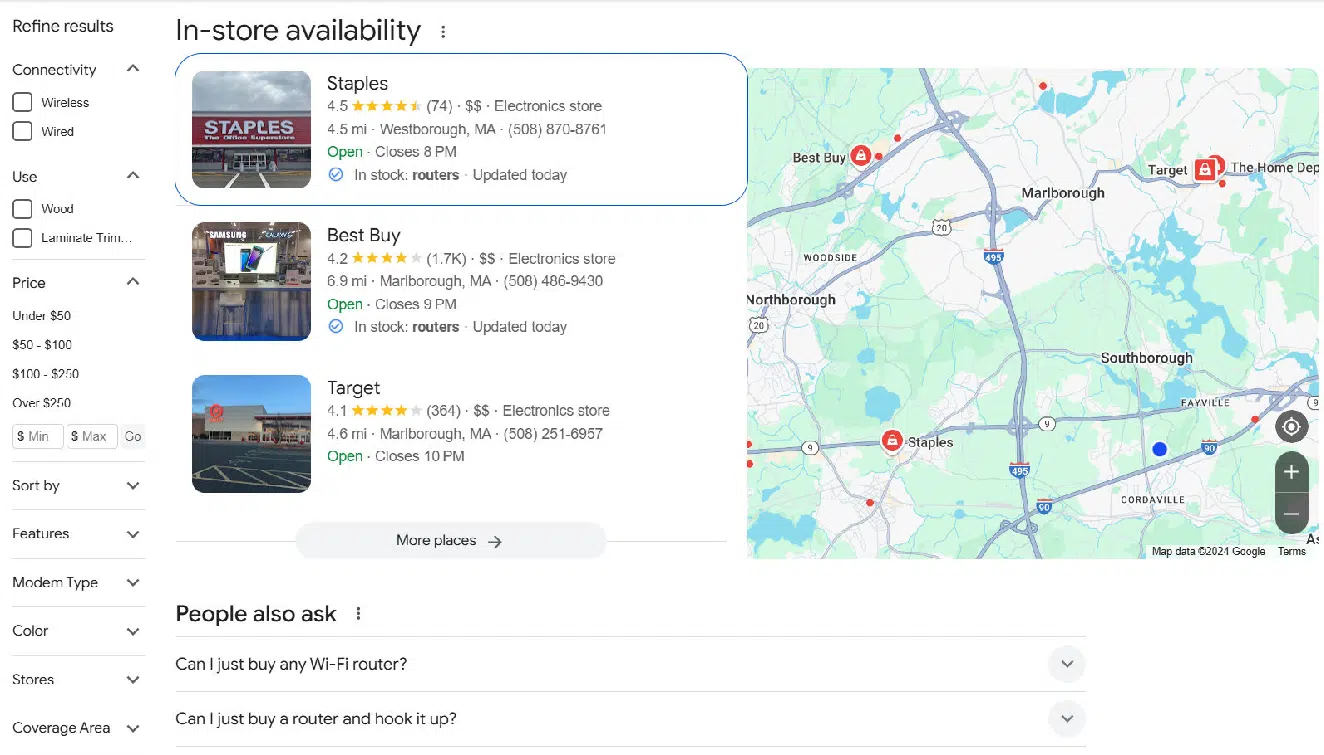

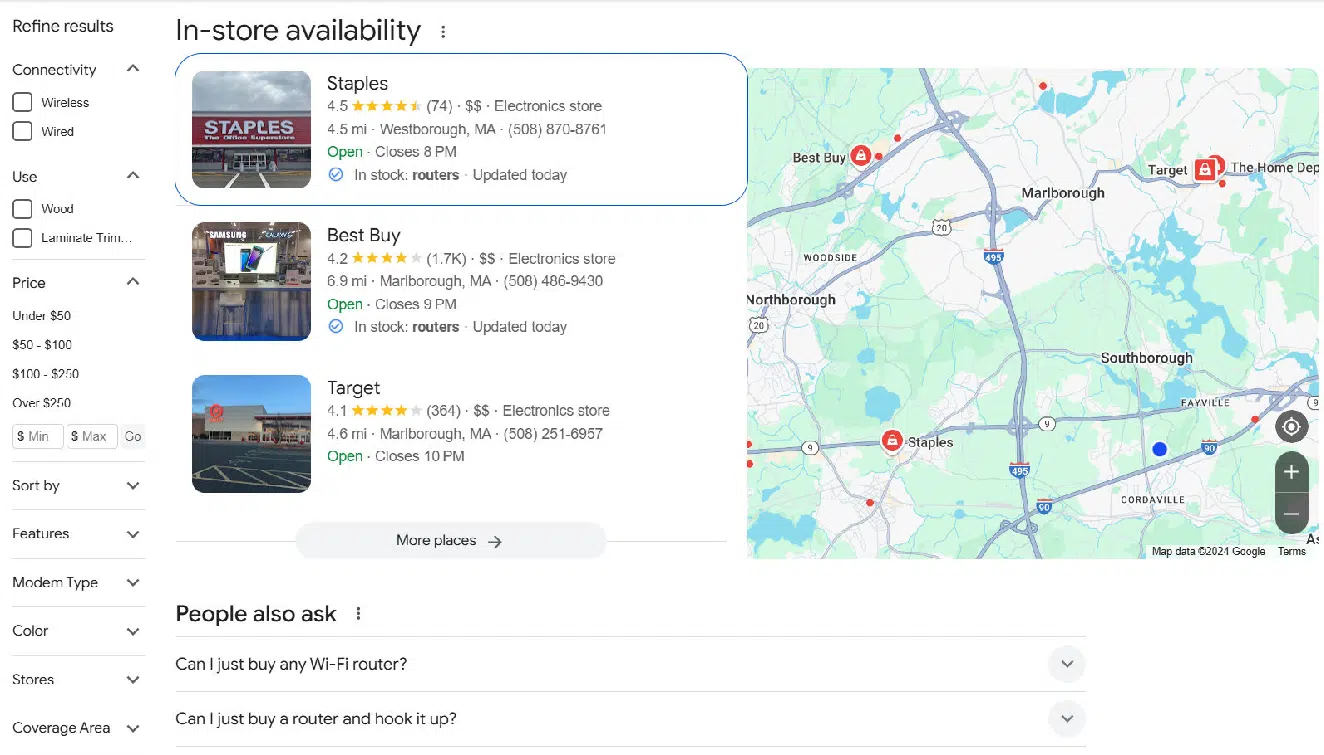

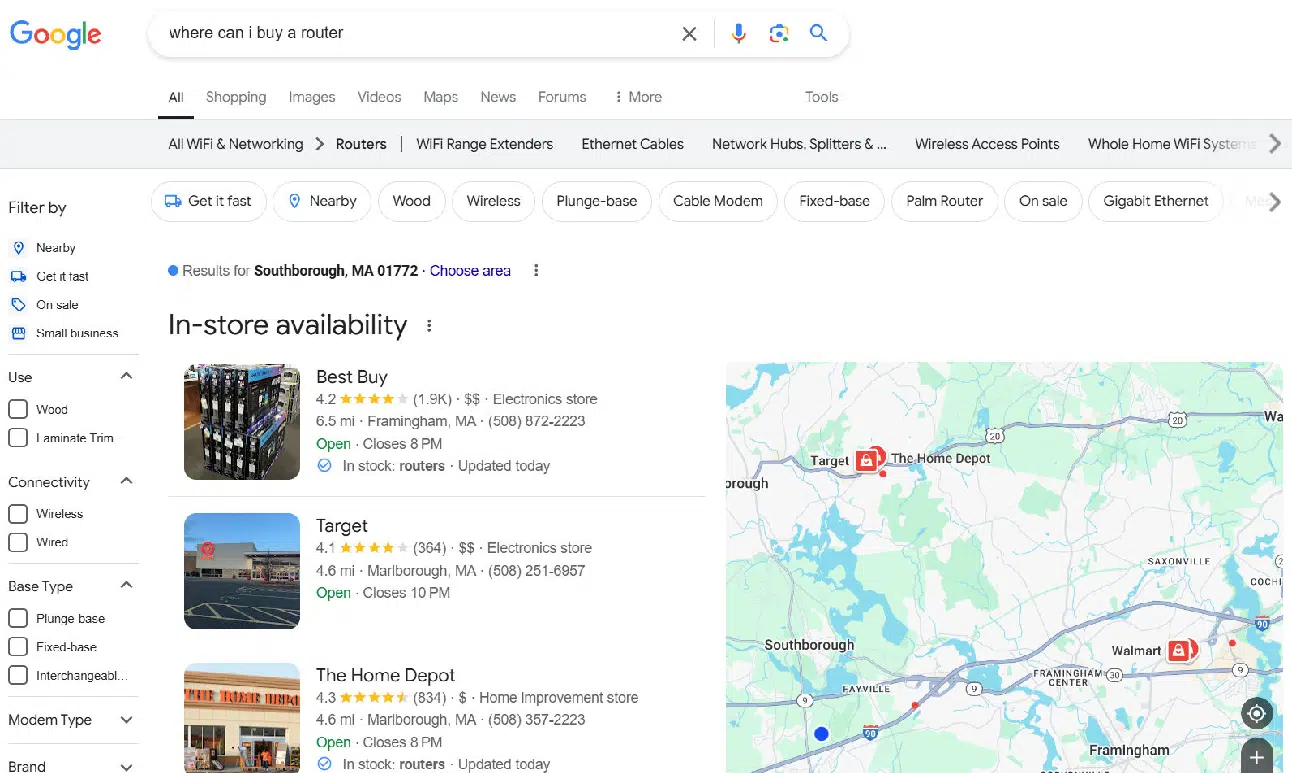

Here is Google’s response to the query:

This part of the SERP is followed by:

Google focuses on the internet router to the same degree as ChatGPT.

For this class of queries, I assigned these scores:

- ChatGPT search: 6.00.

- Google: 5.29.

Query type: Maintaining context in query sequences

Another interesting aspect of search is that users tend to enter queries in sequences.

Sometimes those query sequences contain much information that helps clarify their query intent.

An example query sequence is as follows:

- What is the best router to use for cutting a circular table top?

- Where can I buy a router?

As we’ve seen, the default assumption when people speak about routers is that they refer to devices for connecting devices to a single Internet source.

However, different types of devices, also called routers, are used in woodworking.

In the query sequence above, the reference to cutting a circular table should make it clear that the user’s interest is in the woodworking type of router.

ChatGPT’s response to the first query was to mention two specific models of routers and the general characteristics of different types of woodworking routers.

Then the response to “where can I buy a router” was a map with directions to Staples and the following content:

All of the context of the query was 100% lost.

Sadly, Google only performed slightly better.

It identified three locations, two of which were focused on networking routers and one which was focused on woodworking routers (Home Depot):

For this query, I scored the tools this way:

- ChatGPT search: 2.00.

- Google: 3.00.

Query type: Assumed typos

Another interesting example is queries where your search is relatively rare, yet it has a spelling that’s similar to another word.

For this issue, my search was: “Please discuss the history of the pinguin.”

The Pinguin was a commerce raider used by the German Navy in World War 2. It just has a spelling very similar to “penguin,” which is an aquatic flightless bird.

Both ChatGPT and Google simply assumed that I meant “penguin” and not “pinguin.”

Here is the result from ChatGPT:

The result continues after what I’ve shown here but continues to focus on the bird, not the boat.

Google makes the same mistake:

After the AI Overview and the featured snippet I’ve shown here, the SERPs continue to show more results focused on our flightless friends.

To be fair, I’ve referred to this as a mistake, but the reality is that the percentage of people who enter “pinguin” that simply misspelled “penguin” is probably far greater than those who actually mean the German Navy’s WW2 commerce raider.

However, you’ll notice that Google does one thing just a touch better than ChatGPT here.

At the top of the results, it acknowledges that it corrected “pinguin” to “penguin” and allows you to change it back.

The other way I addressed the problem was to do a second query: “Please discuss the history of the pinguin in WW2,” and both ChatGPT and Google gave results on the WW2 commerce raider.

For this query, I assigned these scores:

- ChatGPT search: 2.00.

- Google: 3.00.

Query type: Multiple options are a better experience

There are many queries where a single (even if it is well thought out) response is not what someone is probably looking for.

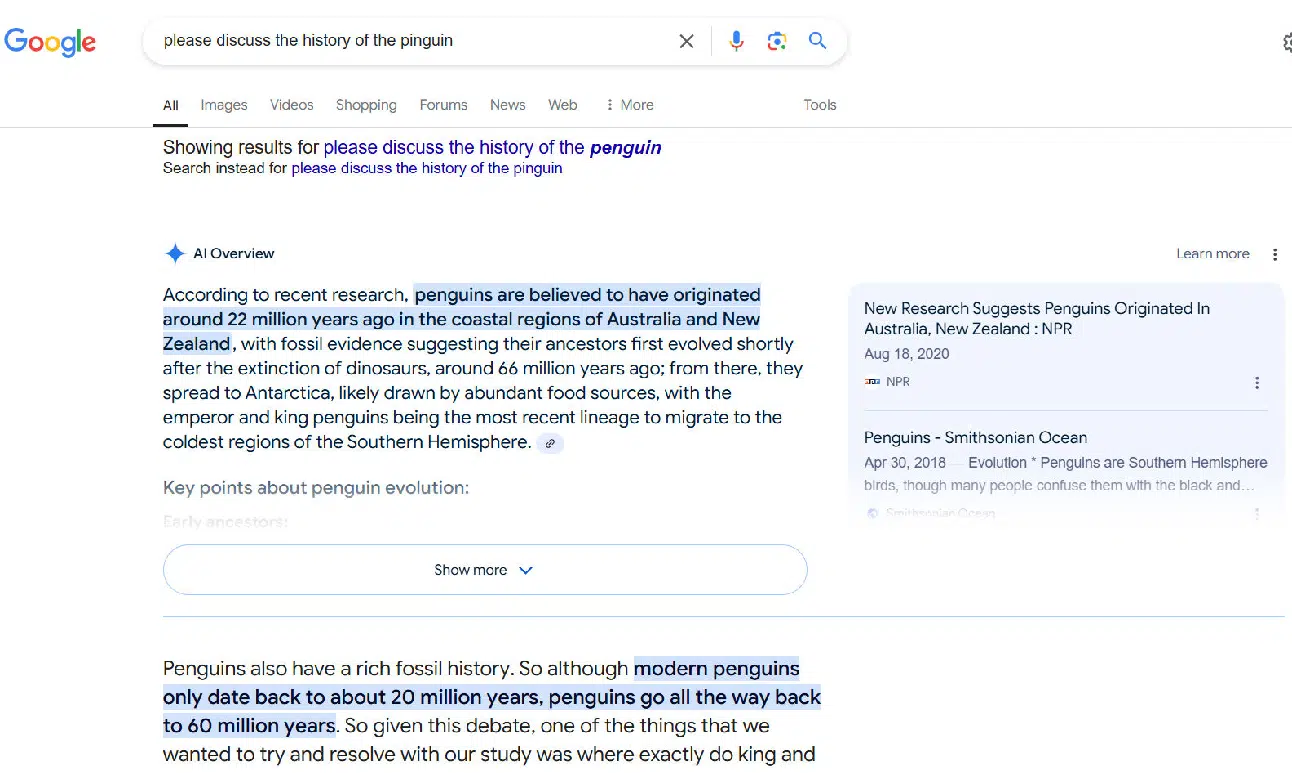

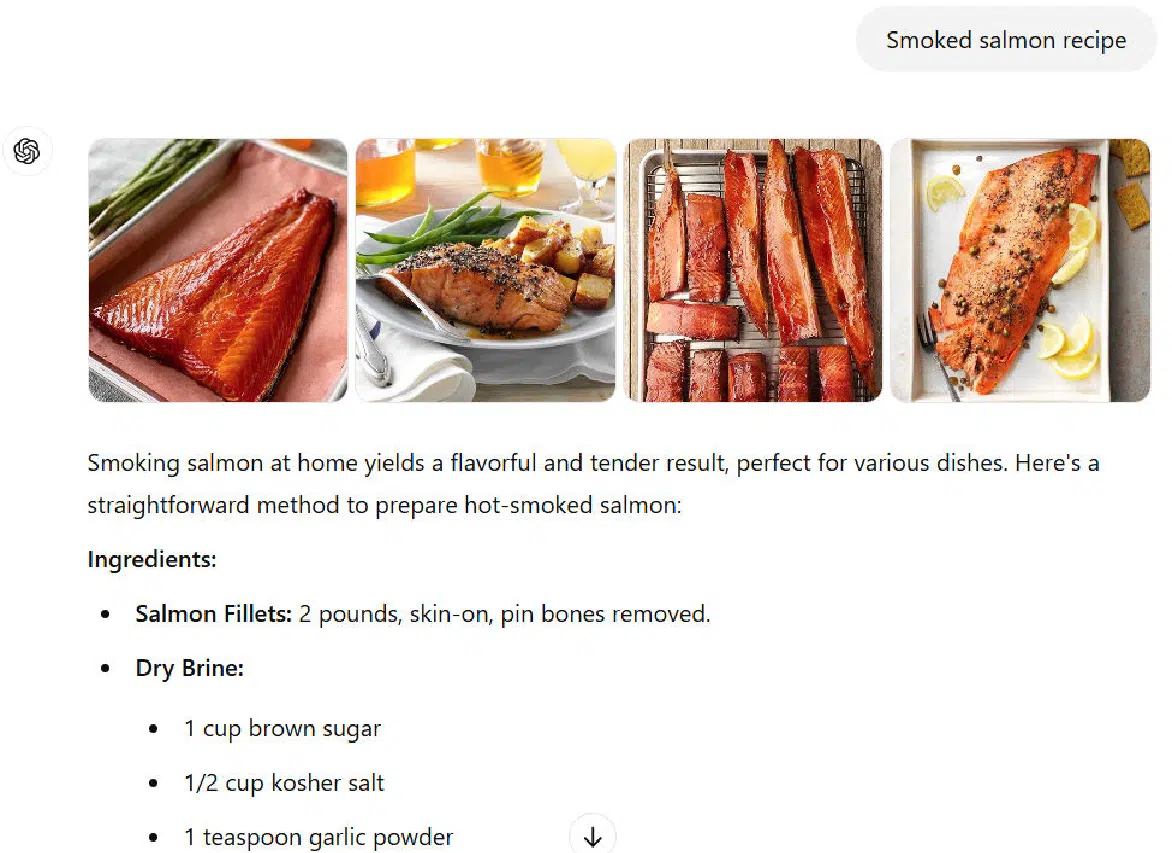

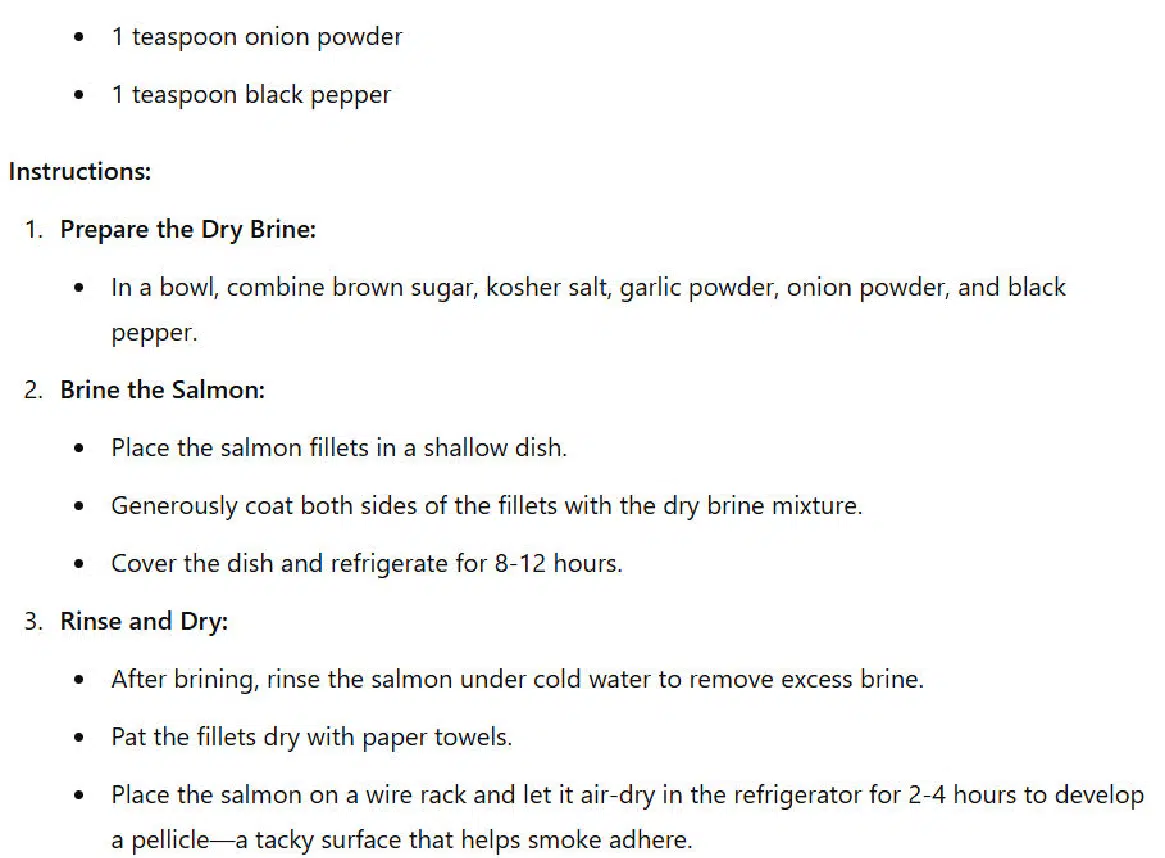

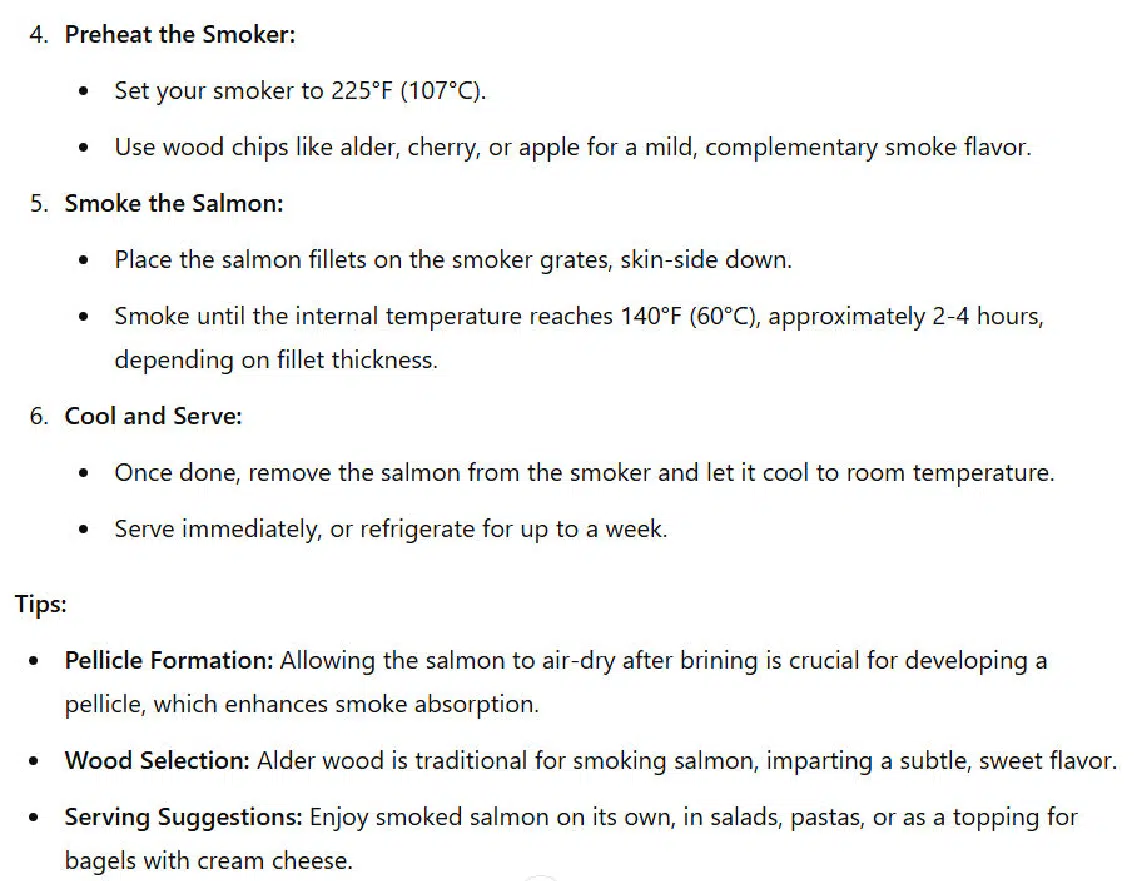

Consider, for example, a query like: “smoked salmon recipe.”

Even though the query is in the singular, there is little chance that anyone serious about cooking wants to see a single answer.

This type of searcher is looking for ideas and wants to look at several options before deciding what they want to do.

They may want to combine ideas from multiple recipes before they have what they want.

Let’s look at the response from ChatGPT search:

I’ve included the first three screens of the response (out of four), and here you will see that ChatGPT search provides one specific recipe from a site called Honest Food.

In addition, I see some things that don’t align with my experience.

For example, this write-up recommends cooking the salmon to 140 degrees. That’s already beginning to dry the salmon a bit.

From what I see on the Honest Food site, they suggest a range of possible temperatures starting from as low as 125.

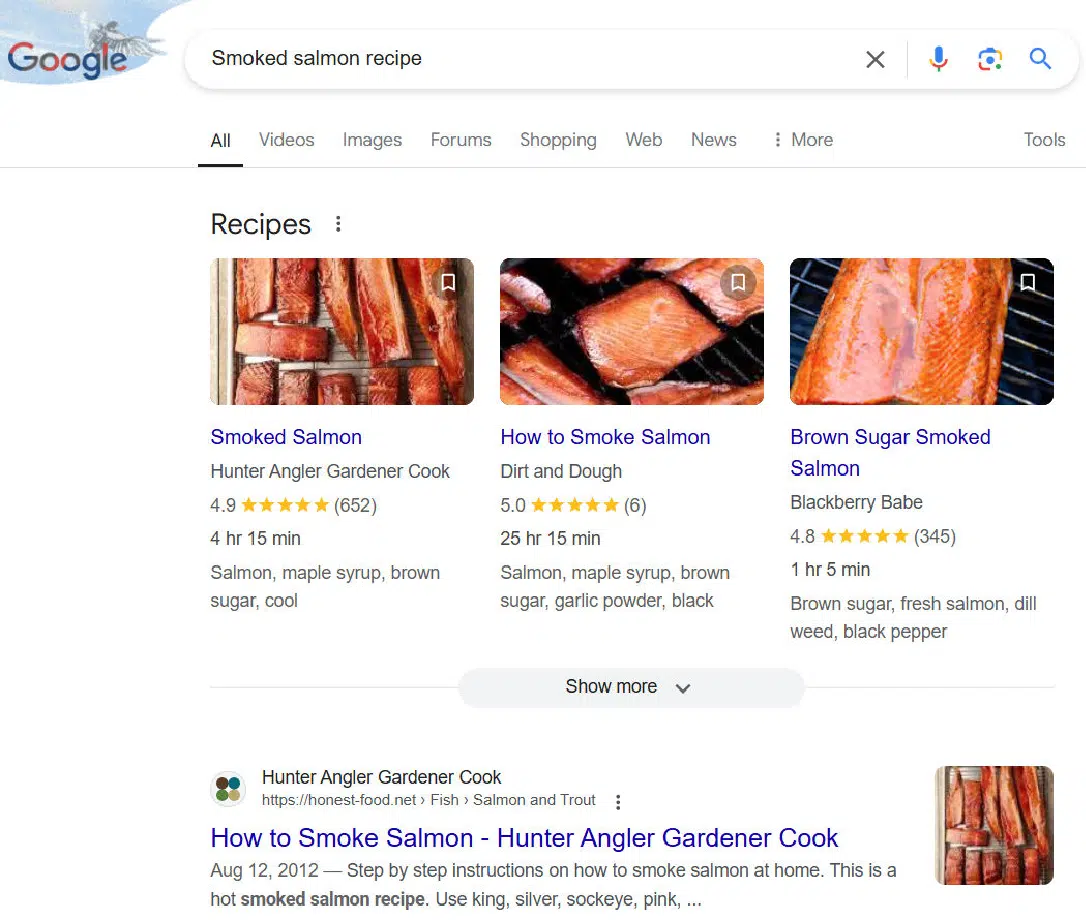

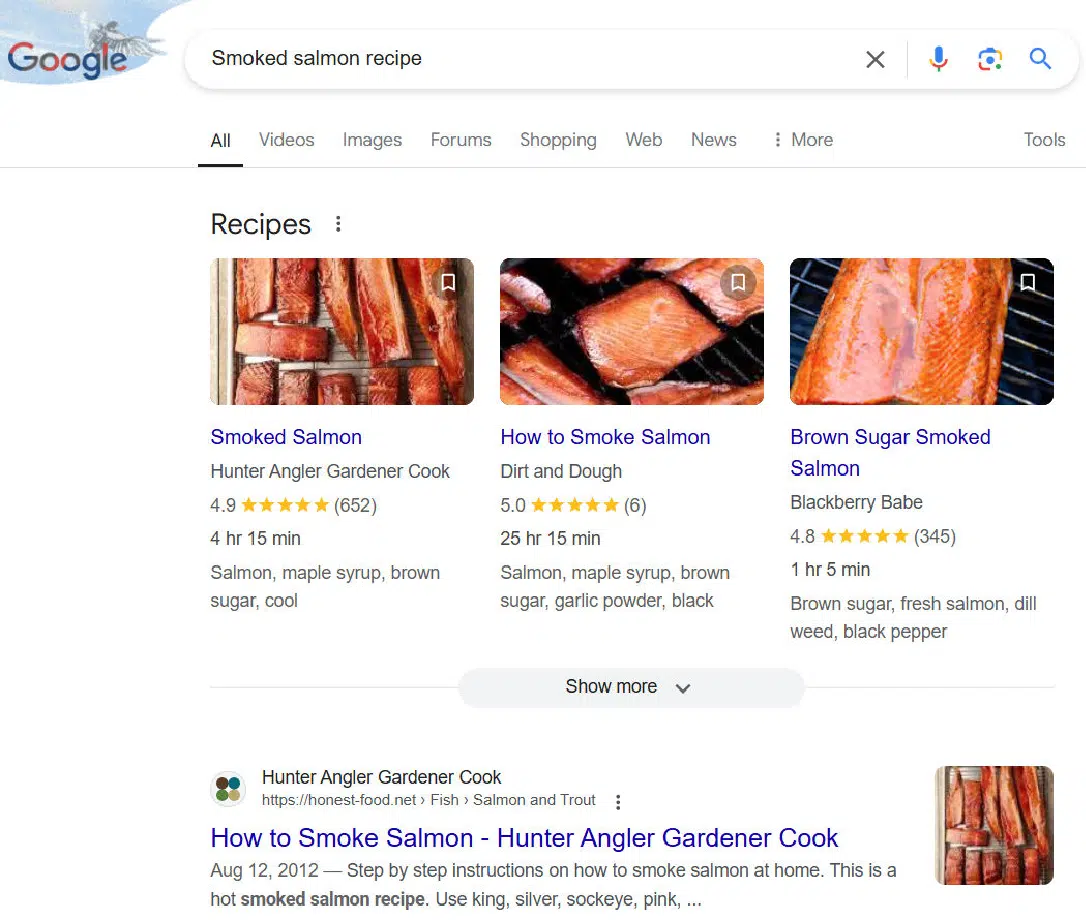

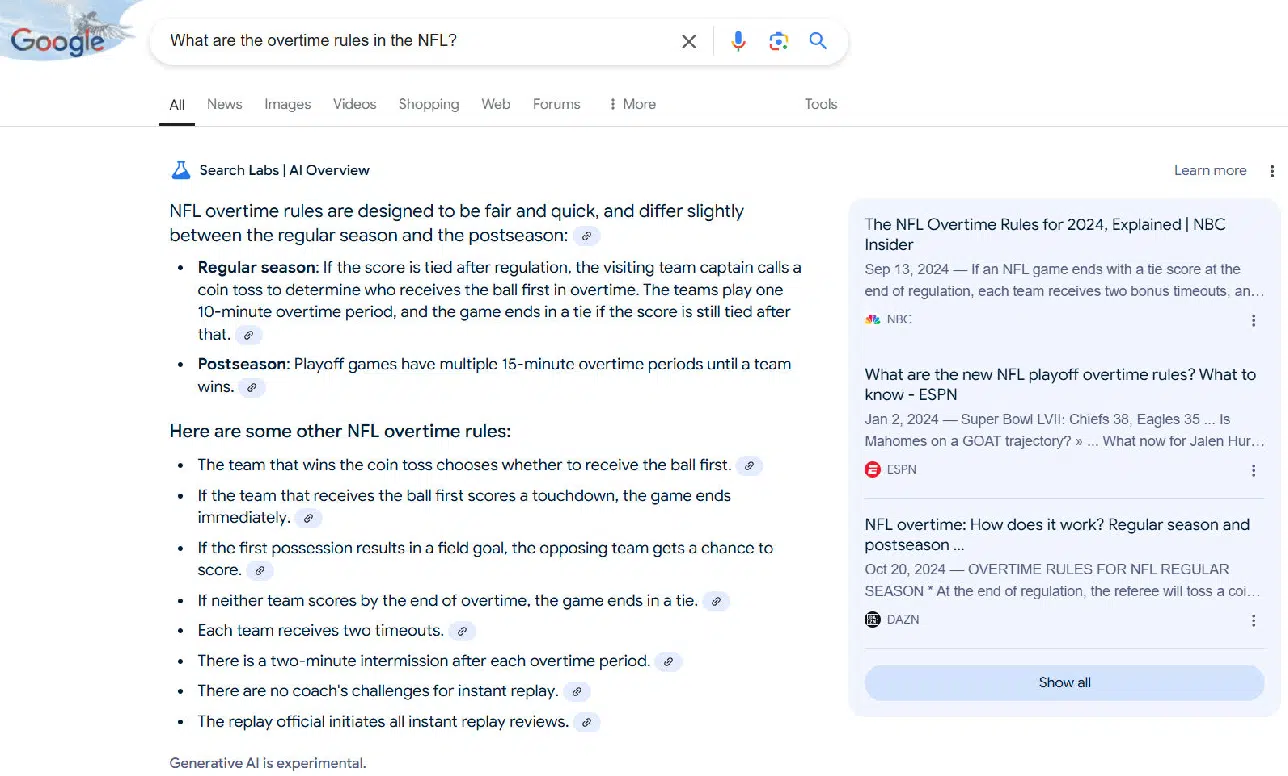

In contrast, Google offers multiple recipes that you can access from the SERPs:

This is an example of a query that I scored in Google’s favor, as having multiple options is what I believe most searchers will want.

The scores I assigned were:

- ChatGPT search: 4.00.

- Google: 8.00.

Get the newsletter search marketers rely on.

Types of problems

Next, we’ll examine the types of things that can go wrong. I looked for these issues while scoring the results.

The analysis noted where problems that generative AI tools are known for were found and potential areas of weakness in Google’s SERPs.

These included:

- Errors.

- Omissions.

- Weaknesses.

- Incomplete coverage.

- Insufficient follow-on resources.

Problem type: Errors

This is what the industry refers to as “hallucinations,” meaning that the information provided is simply wrong.

Sometimes errors aren’t necessarily your money or your life situations, but they still give the user incorrect information.

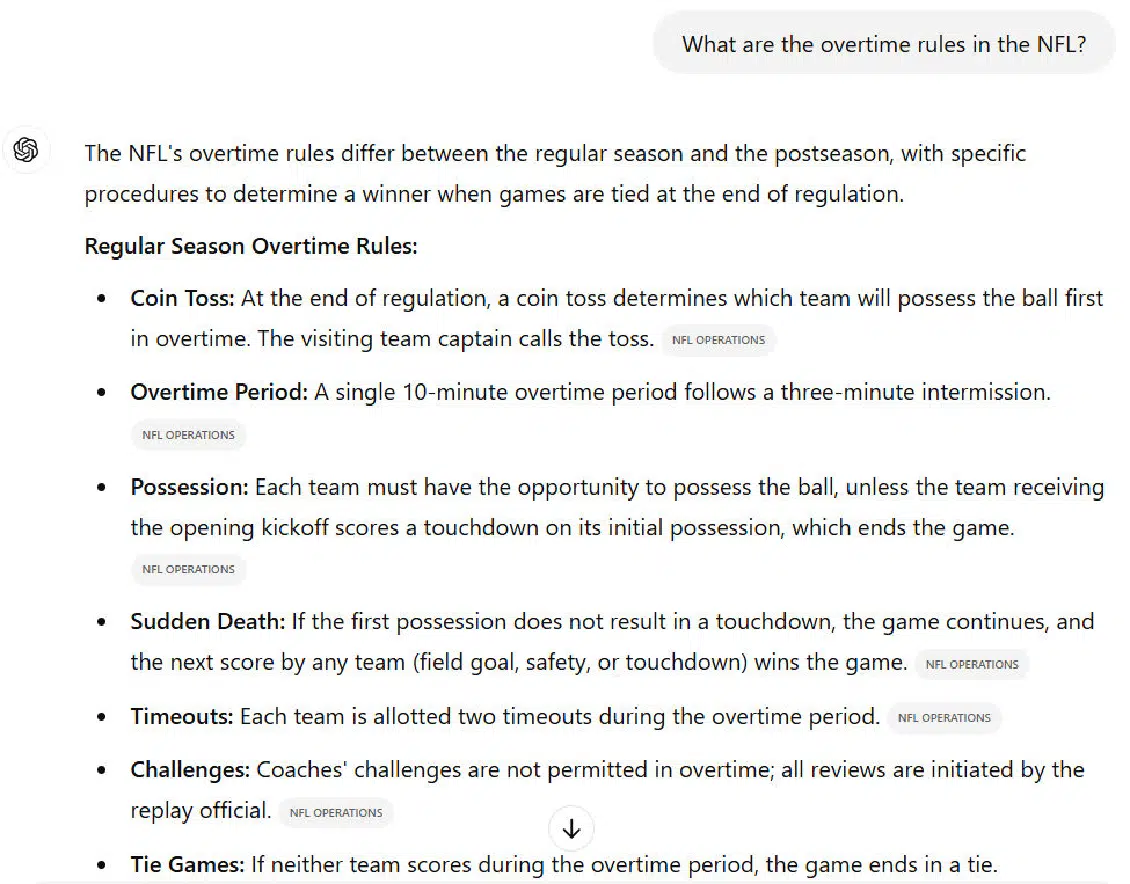

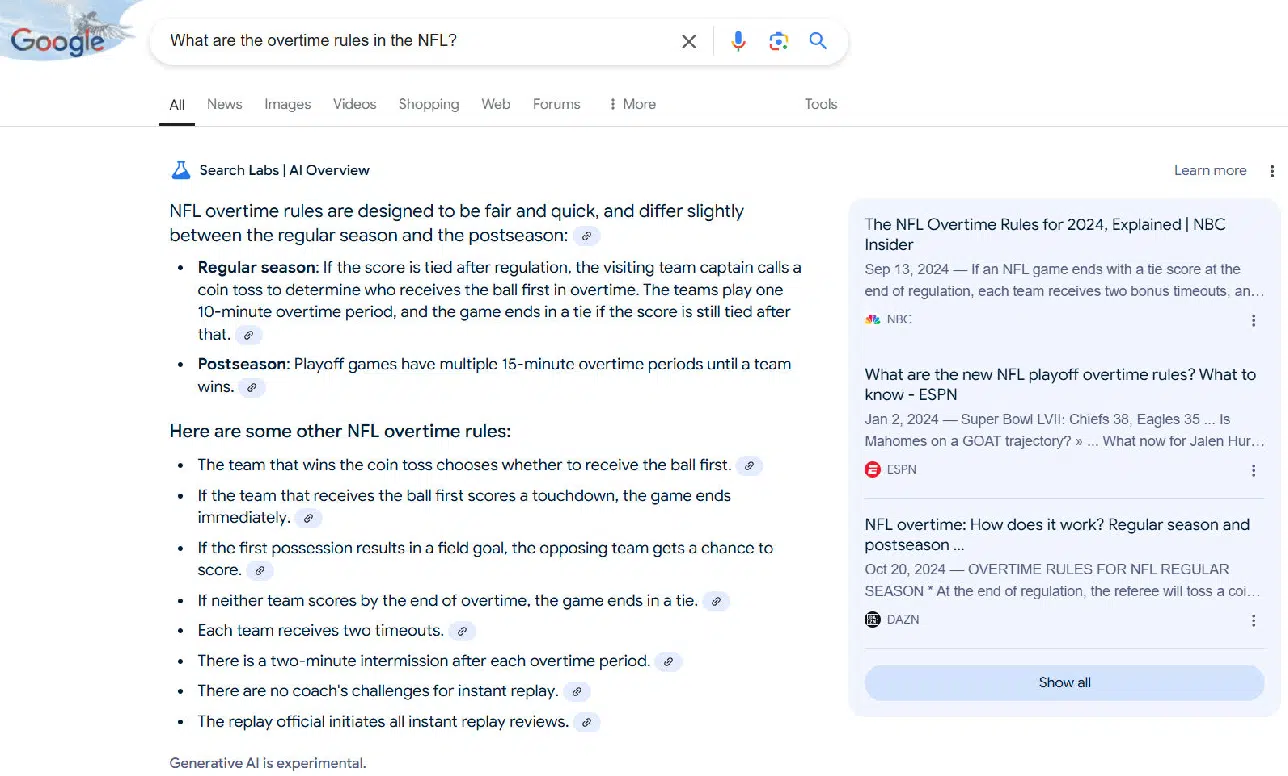

Consider how ChatGPT search responds to a query asking about the NFL’s overtime rules:

Notice the paragraph discussing how Sudden Death works. Unfortunately, it’s not correct.

It doesn’t account for when the first team that possesses the ball kicks a field goal, in which case they could win the game if the second team doesn’t score a field goal.

If the second team scores a field goal, this will tie the game.

In this event, it’s only after the field goal by the second team that the next score wins the game.

This nuance is missed by ChatGPT search.

Note: The information on the NFL Operations page that ChatGPT search used as a source is correct.

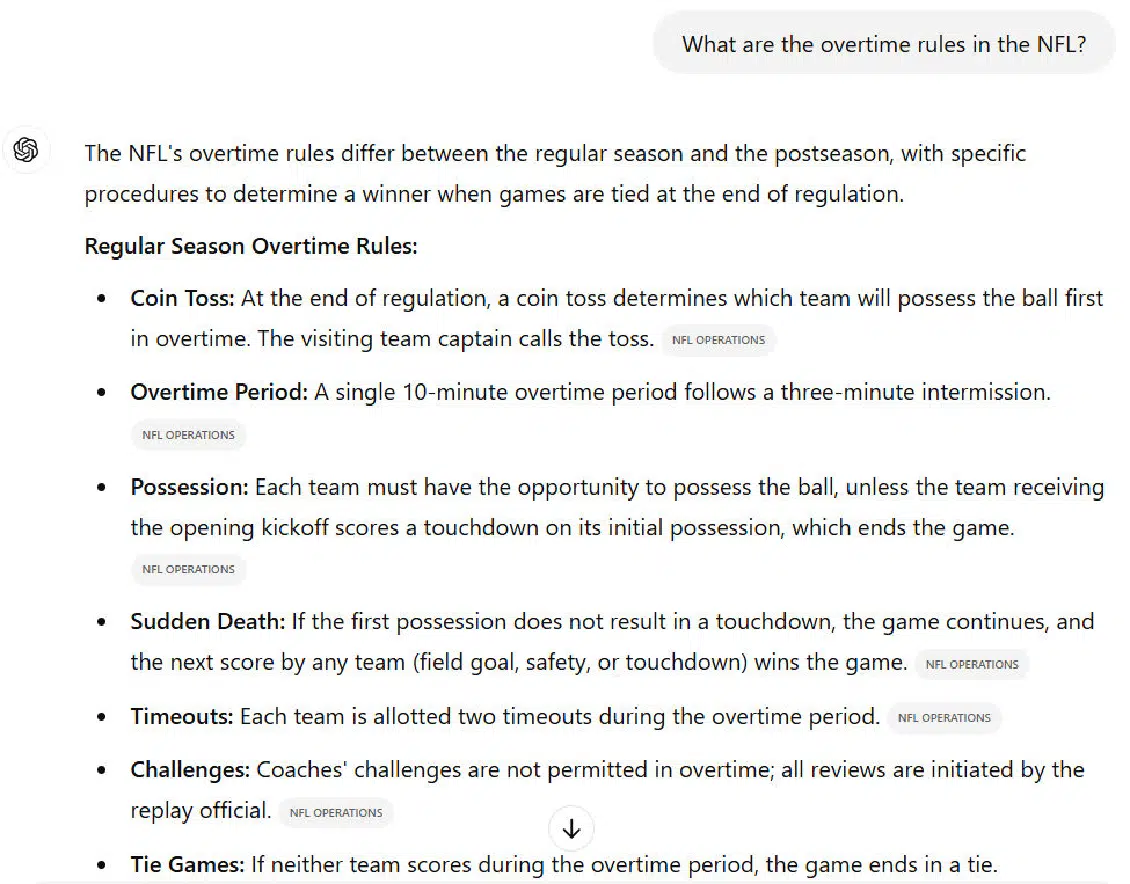

Google’s AI Overview also has an error in it:

In the second line, where Google outlines “some other NFL overtime rules,” it notes that the same ends if the first team to possess the ball scores a touchdown.

This is true for regular season games but not true in the postseason, where both teams always get an opportunity to possess the ball.

Scores were as follows:

- ChatGPT search: 3.00.

- Google: 4.00.

Problem type: Omissions

This type of issue arises when important information that belongs in the response is left out.

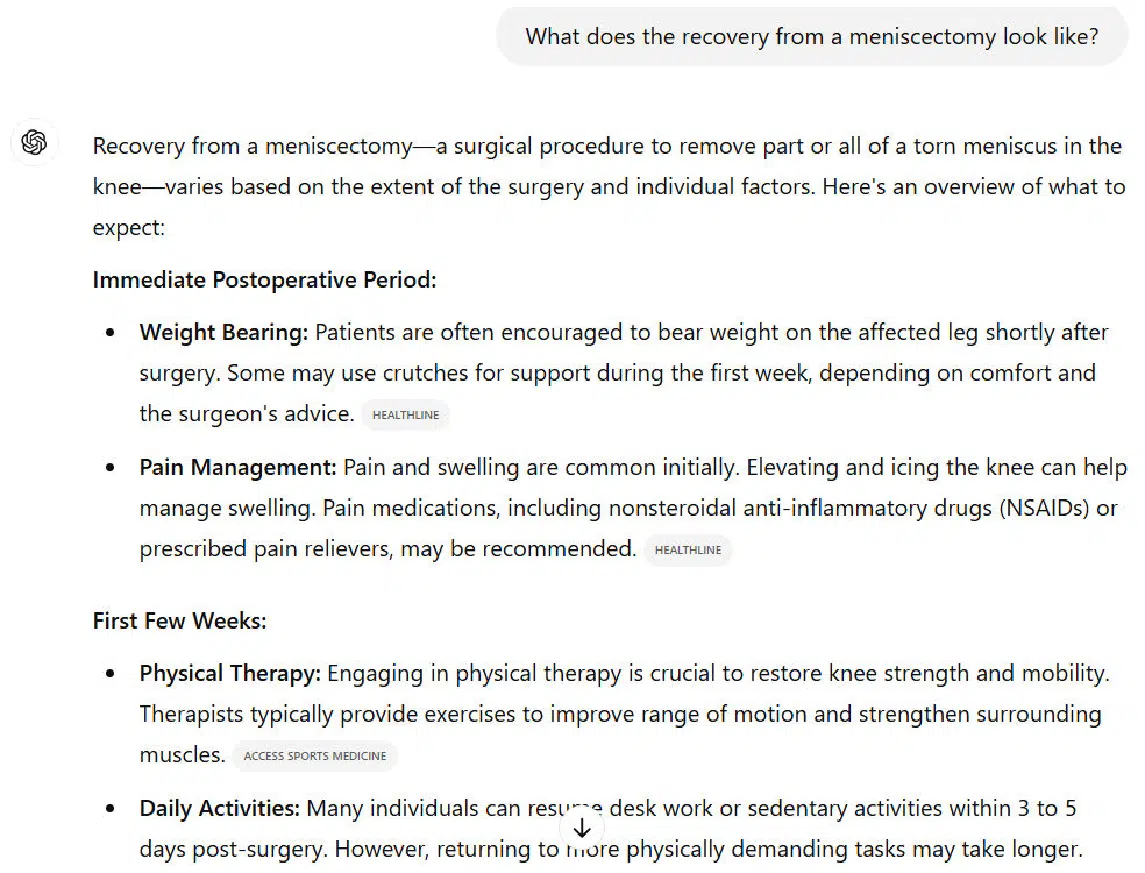

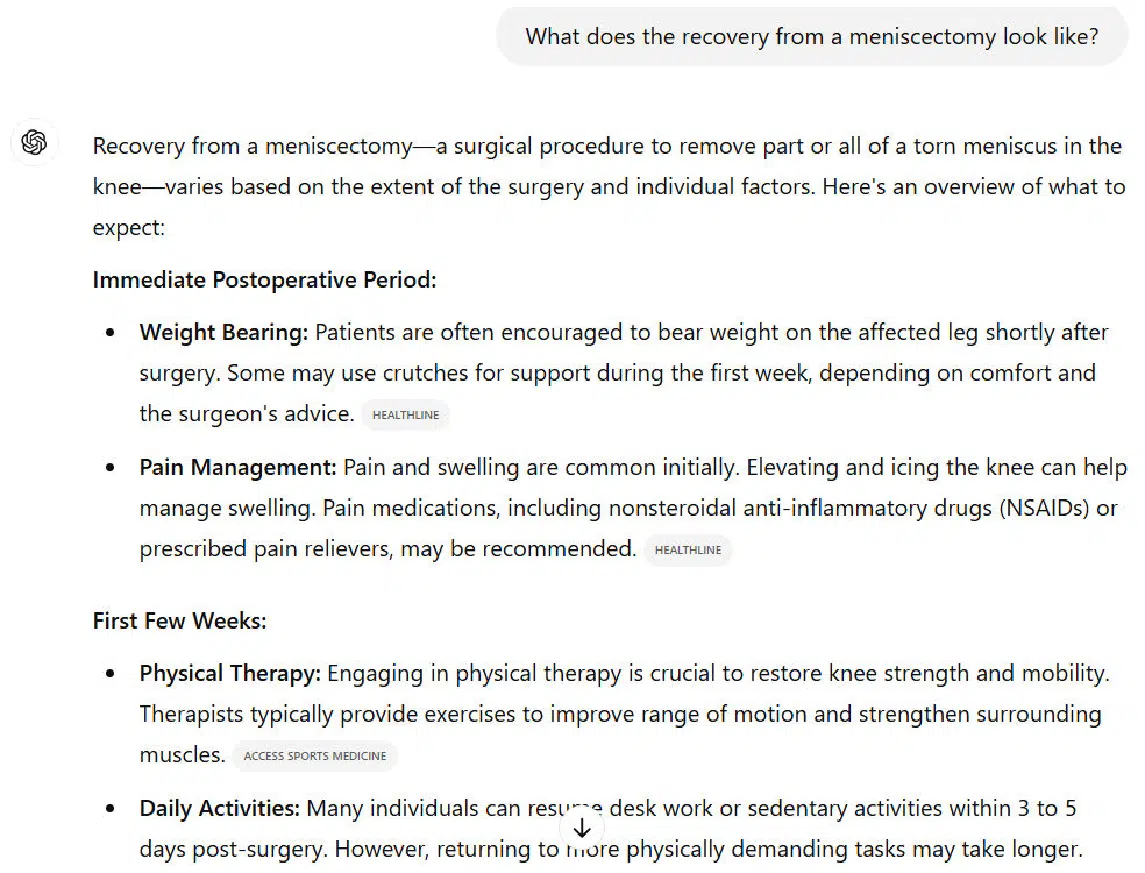

Here is an example where ChatGPT search does this:

Under Pain Management, there is no mention of Tylenol as a part of a pain management regimen.

This is an unfortunate omission, as many people use only a mix of Tylenol and Ibuprofen to manage the pain after a meniscectomy.

Scores were as follows:

- ChatGPT search: 6.00.

- Google: 5.00.

Problem type: Weaknesses

I used weaknesses to cover cases where aspects of the result could have been more helpful to the searcher but where the identified issue couldn’t properly be called an error or omission.

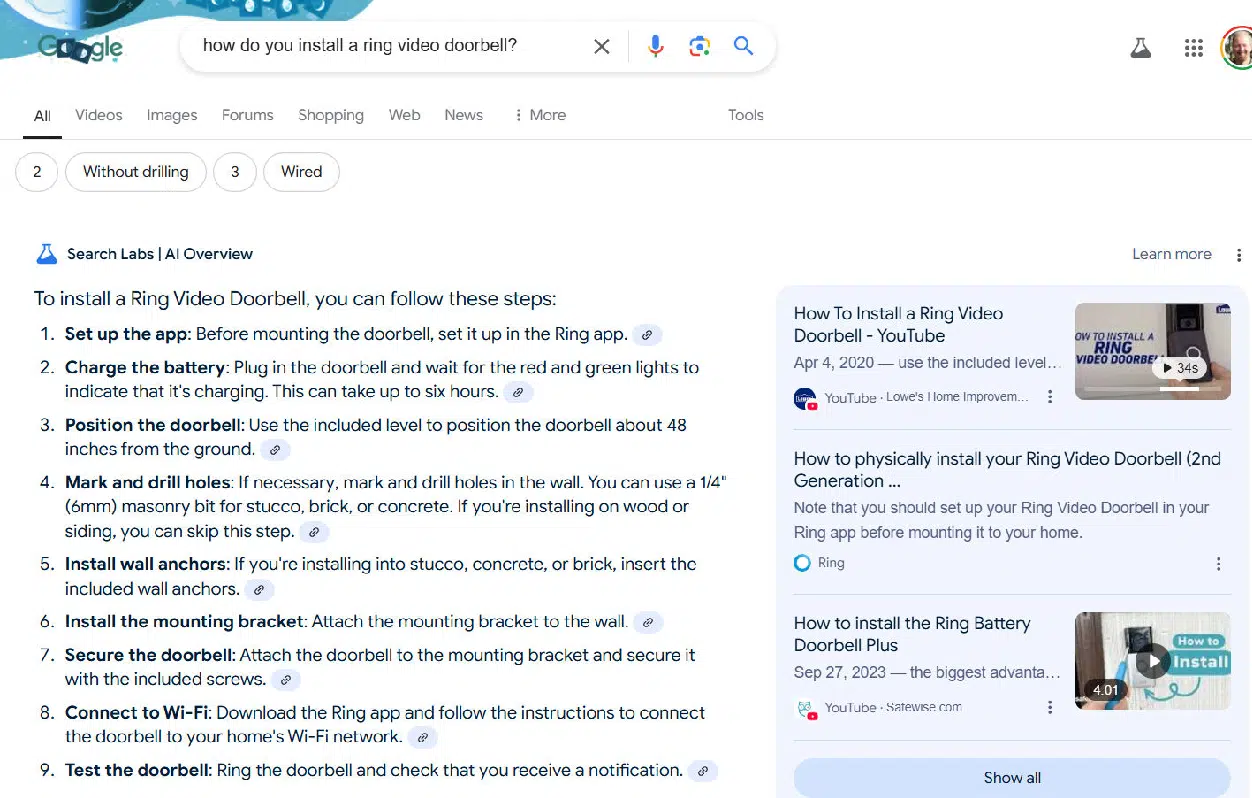

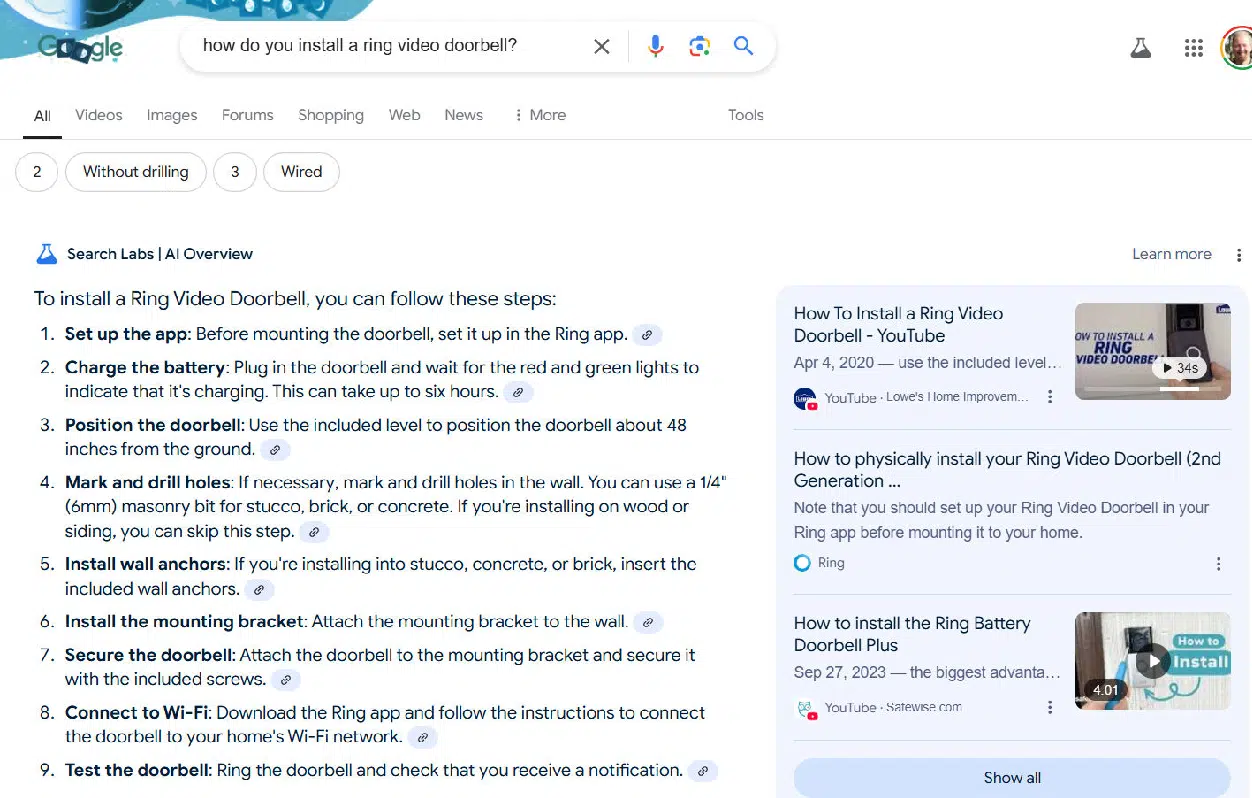

Here is an example of an AI Overview that illustrates this:

The weakness of this outline is that it makes the most sense to charge the battery as the first step.

Since it takes up to 6 hours to complet,e it’s not that useful to set up the app before completing this step.

Here is how I scored these two responses:

- ChatGPT search: 3.00.

- Google: 5.00.

Problem type: Incomplete coverage

This category is one that I used to identify results that failed to cover a significant user need for a query.

Note that “significant” is subjective, but I tried to use this only when many users would need a second query to get what they were looking for.

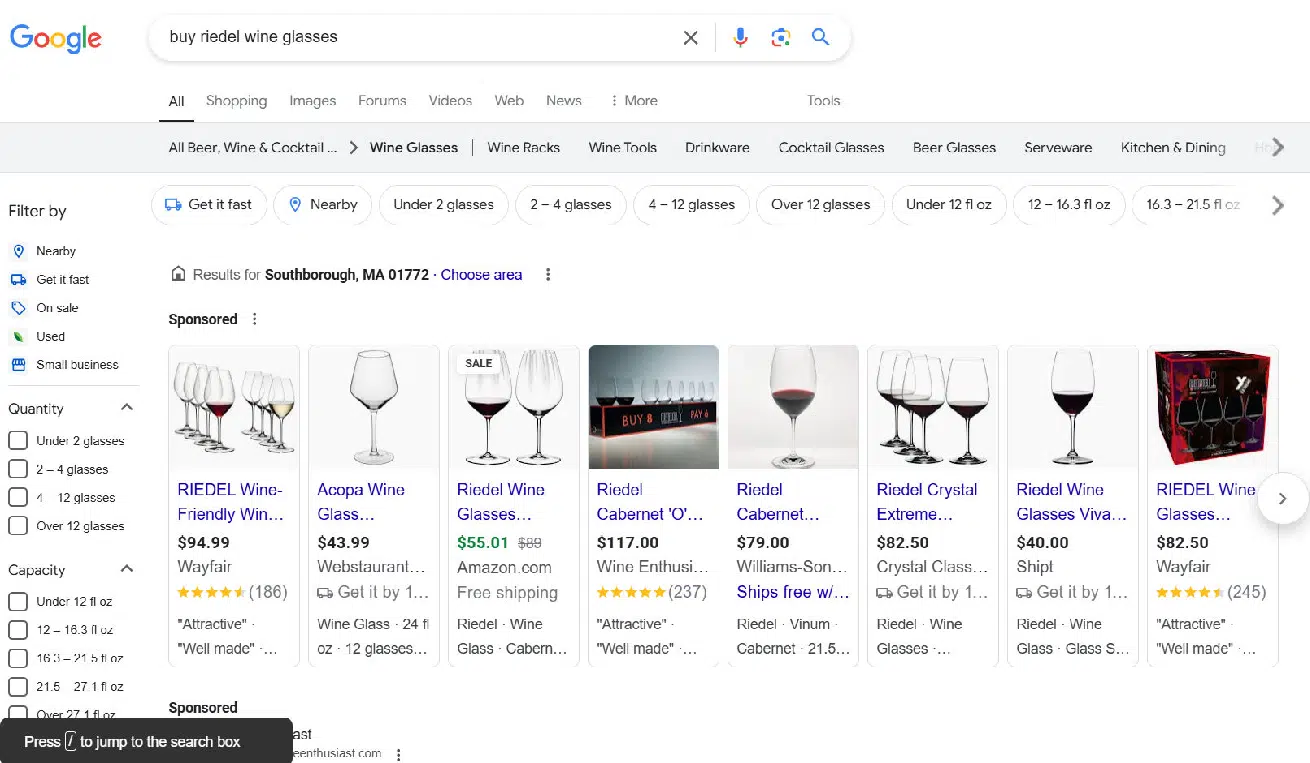

Here is an example of this from a Google SERP.

The results are dominated by Google Shopping (as shown above).

Below what I’ve shown, Google has two ads offering online buying opportunities and two pages from the Riedl website.

This result will leave a user who needs the glasses today and therefore wants to shop locally without an answer to their question.

ChatGPT search did a better job with this query as it listed both local retailers and online shopping sites.

Scores for this query:

- ChatGPT search: 6.00.

- Google: 4.00.

Problem type: Insufficient follow-on resources

As discussed in “How query sessions work” earlier in this article, it’s quite common that users will try a series of queries to get all the information they’re looking for.

As a result, a great search experience will facilitate that process.

This means providing a diverse set of resources that makes it easy for users to research and find what they want/need. When these aren’t easily accessed it offers them a poor experience.

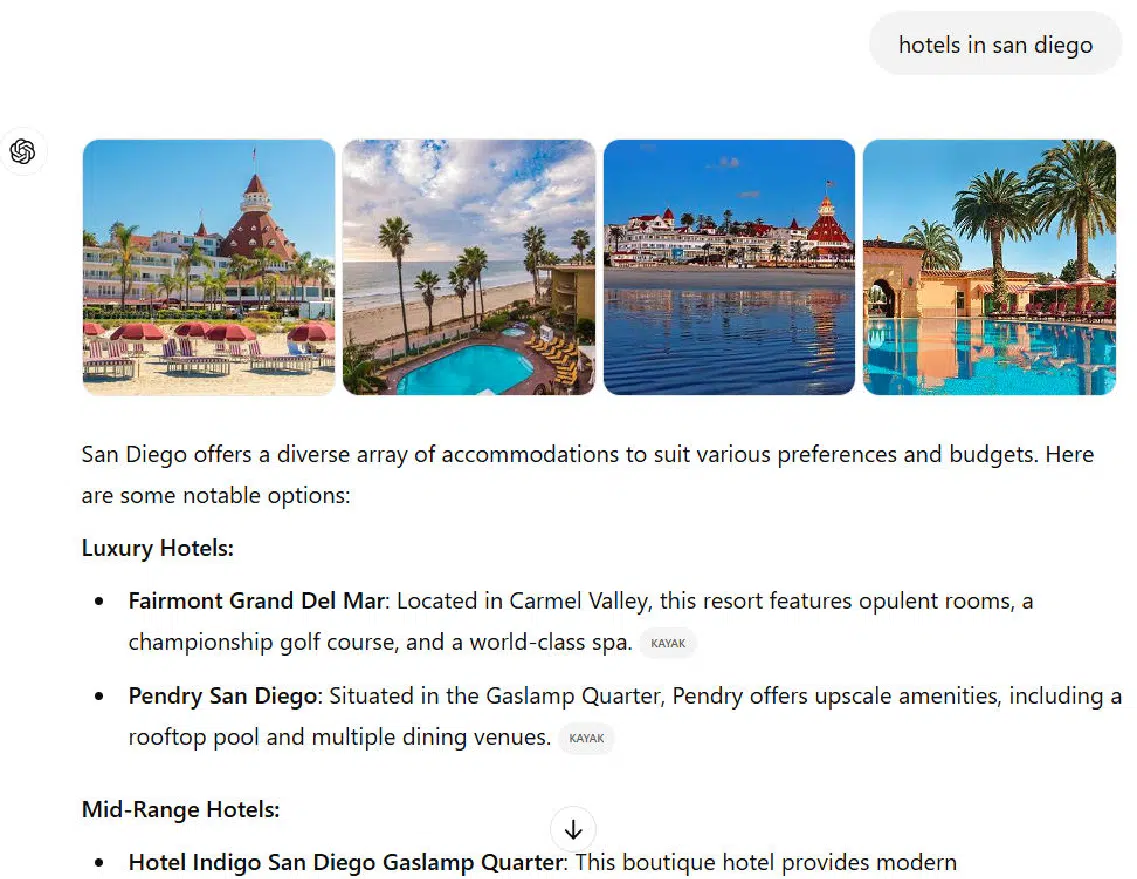

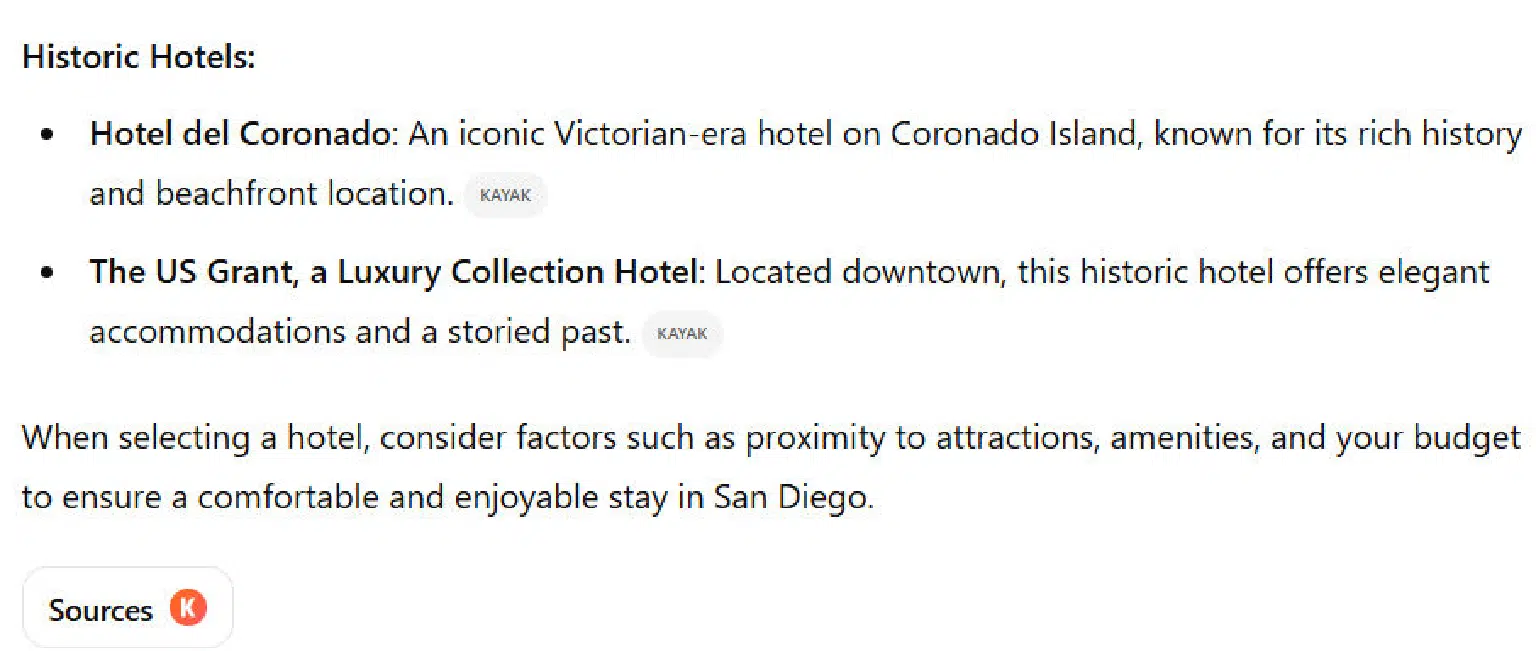

As an example, let’s look at how ChatGPT search responds to the query “hotels in San Diego”:

While this provides 11 hotels as options, there are far more than this throughout the San Diego area.

It’s also based on a single source: Kayak.

The user can click through to the Kayak site to get a complete list, but other resources aren’t made available to the user.

In contrast, Google’s results show many different sites that can be used to find what they want. The scores I assigned to the competitors for this one were:

- ChatGPT search: 3.00.

- Google: 6.00.

The winner?

It’s important to note that this analysis is based on a small sample of 62 queries, which is far too limited to draw definitive conclusions about all search scenarios.

A broader takeaway can be gained by reviewing the examples above to see where each platform tends to perform better.

Here’s a breakdown of category winners:

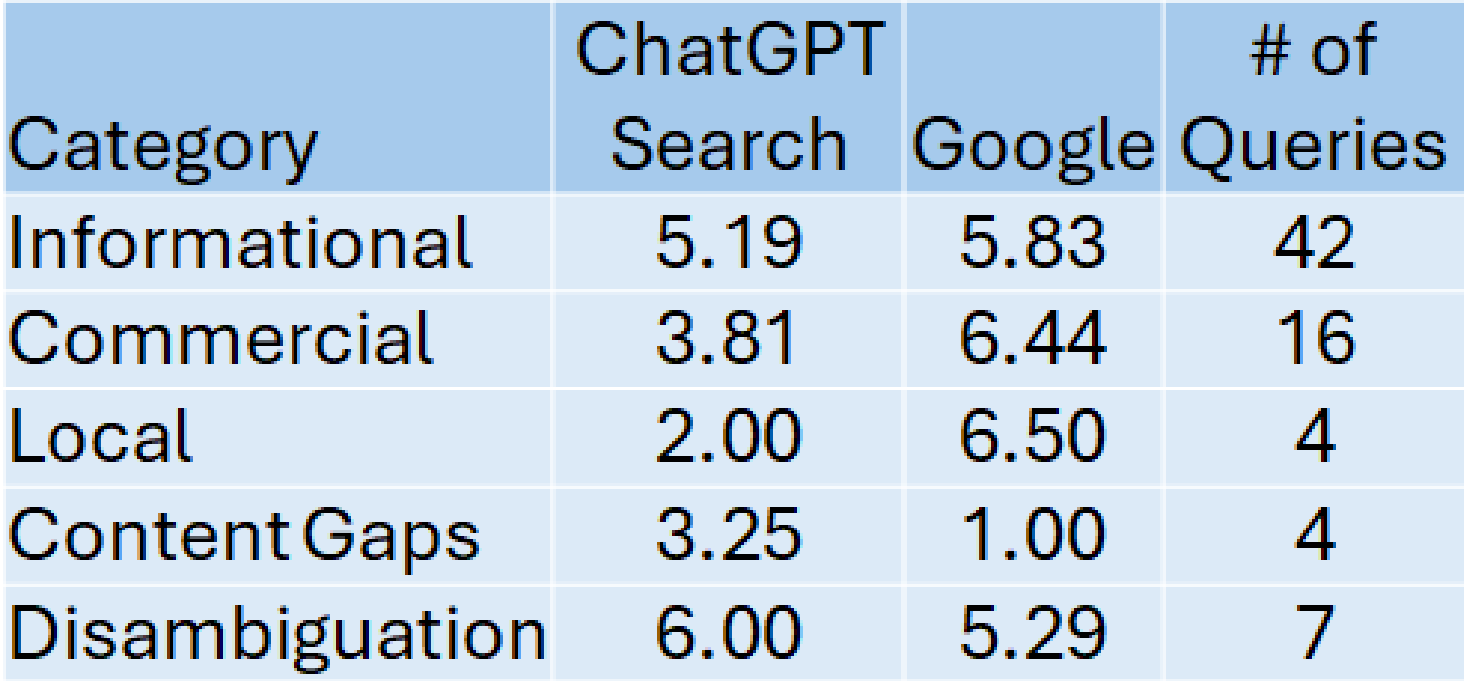

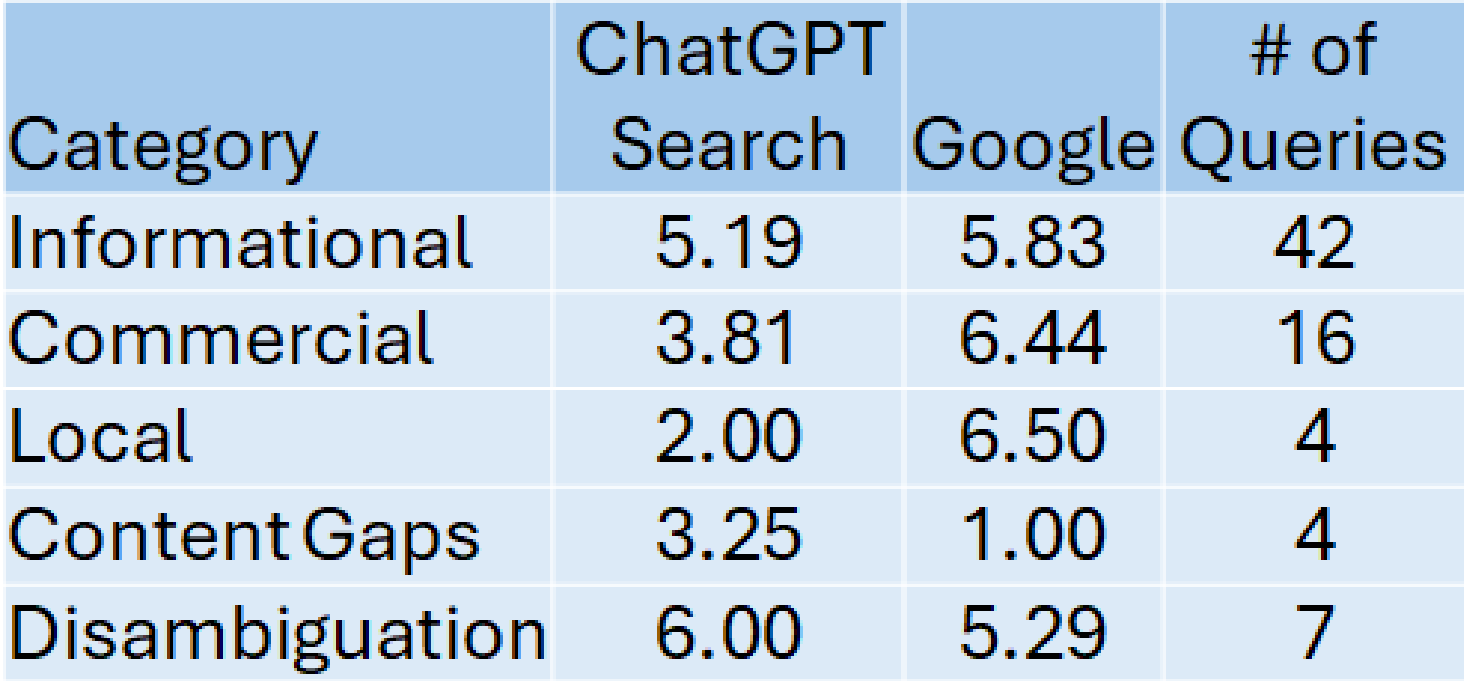

1. Informational queries

- Queries: 42

- Winner: Google

- Google’s average score: 5.83

- ChatGPT search’s average score: 5.19

Google’s slight edge aligns with its strong track record for informational searches.

However, ChatGPT Search performed respectably, despite challenges with errors, omissions, and incomplete responses.

2. Content gap analysis

- Winner: ChatGPT Search

- ChatGPT search’s average score: 3.25

- Google’s average score: 1.0

- ChatGPT Search excels in content gap analysis and related tasks, making it particularly useful for content creators. Winning use cases include:

- Content gap analysis

- Standalone content analysis

- Comparing direct or indirect SERP competitors

- Suggesting article topics and outlines

- Identifying facts/statistics with sources

- Recommending FAQs for articles

While ChatGPT search outperformed Google in this category, its lower overall score highlights areas where improvements are needed, such as accuracy.

3. Navigational queries

Navigational queries were excluded from the test since they typically don’t require detailed text responses.

Google’s dominance in this category is assumed based on its straightforward, website-focused results.

4. Local search queries

- Winner: Google

- Google’s average score: 6.25

- ChatGPT search’s average score: 2.0

Google’s extensive local business data, combined with tools like Google Maps and Waze, ensures its superiority in this category.

5. Commercial queries

- Winner: Google

- Google’s average score: 6.44

- ChatGPT search’s average score: 3.81

This category, comprising 16 queries, favored Google due to its stronger capabilities in showcasing product and service-related results.

6. Disambiguation queries

- Winner: ChatGPT search

- ChatGPT search’s average score: 6.0

- Google’s average score: 5.29

ChatGPT Search edged out Google by more effectively presenting multiple definitions or interpretations for ambiguous terms, providing users with greater clarity.

These scores are summarized in the following table:

Summary

After a detailed review of 62 queries, I still see Google as the better solution for most searches.

ChatGPT search is surprisingly competitive when it comes to informational queries, but Google edged ChatGPT search out here too.

Note that 62 queries are a tiny sample when considered against the scope of all search.

Nonetheless, as you consider your search plans going forward, I’d advise you to do a segmented analysis like what I did before deciding which platform is the better choice for your projects.

Contributing authors are invited to create content for Search Engine Land and are chosen for their expertise and contribution to the search community. Our contributors work under the oversight of the editorial staff and contributions are checked for quality and relevance to our readers. The opinions they express are their own.

You may like

Noticias

Revivir el compromiso en el aula de español: un desafío musical con chatgpt – enfoque de la facultad

Published

8 meses agoon

6 junio, 2025

A mitad del semestre, no es raro notar un cambio en los niveles de energía de sus alumnos (Baghurst y Kelley, 2013; Kumari et al., 2021). El entusiasmo inicial por aprender un idioma extranjero puede disminuir a medida que otros cursos con tareas exigentes compitan por su atención. Algunos estudiantes priorizan las materias que perciben como más directamente vinculadas a su especialidad o carrera, mientras que otros simplemente sienten el peso del agotamiento de mediados de semestre. En la primavera, los largos meses de invierno pueden aumentar esta fatiga, lo que hace que sea aún más difícil mantener a los estudiantes comprometidos (Rohan y Sigmon, 2000).

Este es el momento en que un instructor de idiomas debe pivotar, cambiando la dinámica del aula para reavivar la curiosidad y la motivación. Aunque los instructores se esfuerzan por incorporar actividades que se adapten a los cinco estilos de aprendizaje preferidos (Felder y Henriques, 1995)-Visual (aprendizaje a través de imágenes y comprensión espacial), auditivo (aprendizaje a través de la escucha y discusión), lectura/escritura (aprendizaje a través de interacción basada en texto), Kinesthetic (aprendizaje a través de movimiento y actividades prácticas) y multimodal (una combinación de múltiples estilos)-its is beneficiales). Estructurado y, después de un tiempo, clases predecibles con actividades que rompen el molde. La introducción de algo inesperado y diferente de la dinámica del aula establecida puede revitalizar a los estudiantes, fomentar la creatividad y mejorar su entusiasmo por el aprendizaje.

La música, en particular, ha sido durante mucho tiempo un aliado de instructores que enseñan un segundo idioma (L2), un idioma aprendido después de la lengua nativa, especialmente desde que el campo hizo la transición hacia un enfoque más comunicativo. Arraigado en la interacción y la aplicación del mundo real, el enfoque comunicativo prioriza el compromiso significativo sobre la memorización de memoria, ayudando a los estudiantes a desarrollar fluidez de formas naturales e inmersivas. La investigación ha destacado constantemente los beneficios de la música en la adquisición de L2, desde mejorar la pronunciación y las habilidades de escucha hasta mejorar la retención de vocabulario y la comprensión cultural (DeGrave, 2019; Kumar et al. 2022; Nuessel y Marshall, 2008; Vidal y Nordgren, 2024).

Sobre la base de esta tradición, la actividad que compartiremos aquí no solo incorpora música sino que también integra inteligencia artificial, agregando una nueva capa de compromiso y pensamiento crítico. Al usar la IA como herramienta en el proceso de aprendizaje, los estudiantes no solo se familiarizan con sus capacidades, sino que también desarrollan la capacidad de evaluar críticamente el contenido que genera. Este enfoque los alienta a reflexionar sobre el lenguaje, el significado y la interpretación mientras participan en el análisis de texto, la escritura creativa, la oratoria y la gamificación, todo dentro de un marco interactivo y culturalmente rico.

Descripción de la actividad: Desafío musical con Chatgpt: “Canta y descubre”

Objetivo:

Los estudiantes mejorarán su comprensión auditiva y su producción escrita en español analizando y recreando letras de canciones con la ayuda de ChatGPT. Si bien las instrucciones se presentan aquí en inglés, la actividad debe realizarse en el idioma de destino, ya sea que se enseñe el español u otro idioma.

Instrucciones:

1. Escuche y decodifique

- Divida la clase en grupos de 2-3 estudiantes.

- Elija una canción en español (por ejemplo, La Llorona por chavela vargas, Oye CÓMO VA por Tito Puente, Vivir mi Vida por Marc Anthony).

- Proporcione a cada grupo una versión incompleta de la letra con palabras faltantes.

- Los estudiantes escuchan la canción y completan los espacios en blanco.

2. Interpretar y discutir

- Dentro de sus grupos, los estudiantes analizan el significado de la canción.

- Discuten lo que creen que transmiten las letras, incluidas las emociones, los temas y cualquier referencia cultural que reconocan.

- Cada grupo comparte su interpretación con la clase.

- ¿Qué crees que la canción está tratando de comunicarse?

- ¿Qué emociones o sentimientos evocan las letras para ti?

- ¿Puedes identificar alguna referencia cultural en la canción? ¿Cómo dan forma a su significado?

- ¿Cómo influye la música (melodía, ritmo, etc.) en su interpretación de la letra?

- Cada grupo comparte su interpretación con la clase.

3. Comparar con chatgpt

- Después de formar su propio análisis, los estudiantes preguntan a Chatgpt:

- ¿Qué crees que la canción está tratando de comunicarse?

- ¿Qué emociones o sentimientos evocan las letras para ti?

- Comparan la interpretación de ChatGPT con sus propias ideas y discuten similitudes o diferencias.

4. Crea tu propio verso

- Cada grupo escribe un nuevo verso que coincide con el estilo y el ritmo de la canción.

- Pueden pedirle ayuda a ChatGPT: “Ayúdanos a escribir un nuevo verso para esta canción con el mismo estilo”.

5. Realizar y cantar

- Cada grupo presenta su nuevo verso a la clase.

- Si se sienten cómodos, pueden cantarlo usando la melodía original.

- Es beneficioso que el profesor tenga una versión de karaoke (instrumental) de la canción disponible para que las letras de los estudiantes se puedan escuchar claramente.

- Mostrar las nuevas letras en un monitor o proyector permite que otros estudiantes sigan y canten juntos, mejorando la experiencia colectiva.

6. Elección – El Grammy va a

Los estudiantes votan por diferentes categorías, incluyendo:

- Mejor adaptación

- Mejor reflexión

- Mejor rendimiento

- Mejor actitud

- Mejor colaboración

7. Reflexión final

- ¿Cuál fue la parte más desafiante de comprender la letra?

- ¿Cómo ayudó ChatGPT a interpretar la canción?

- ¿Qué nuevas palabras o expresiones aprendiste?

Pensamientos finales: música, IA y pensamiento crítico

Un desafío musical con Chatgpt: “Canta y descubre” (Desafío Musical Con Chatgpt: “Cantar y Descubrir”) es una actividad que he encontrado que es especialmente efectiva en mis cursos intermedios y avanzados. Lo uso cuando los estudiantes se sienten abrumados o distraídos, a menudo alrededor de los exámenes parciales, como una forma de ayudarlos a relajarse y reconectarse con el material. Sirve como un descanso refrescante, lo que permite a los estudiantes alejarse del estrés de las tareas y reenfocarse de una manera divertida e interactiva. Al incorporar música, creatividad y tecnología, mantenemos a los estudiantes presentes en la clase, incluso cuando todo lo demás parece exigir su atención.

Más allá de ofrecer una pausa bien merecida, esta actividad provoca discusiones atractivas sobre la interpretación del lenguaje, el contexto cultural y el papel de la IA en la educación. A medida que los estudiantes comparan sus propias interpretaciones de las letras de las canciones con las generadas por ChatGPT, comienzan a reconocer tanto el valor como las limitaciones de la IA. Estas ideas fomentan el pensamiento crítico, ayudándoles a desarrollar un enfoque más maduro de la tecnología y su impacto en su aprendizaje.

Agregar el elemento de karaoke mejora aún más la experiencia, dando a los estudiantes la oportunidad de realizar sus nuevos versos y divertirse mientras practica sus habilidades lingüísticas. Mostrar la letra en una pantalla hace que la actividad sea más inclusiva, lo que permite a todos seguirlo. Para hacerlo aún más agradable, seleccionando canciones que resuenen con los gustos de los estudiantes, ya sea un clásico como La Llorona O un éxito contemporáneo de artistas como Bad Bunny, Selena, Daddy Yankee o Karol G, hace que la actividad se sienta más personal y atractiva.

Esta actividad no se limita solo al aula. Es una gran adición a los clubes españoles o eventos especiales, donde los estudiantes pueden unirse a un amor compartido por la música mientras practican sus habilidades lingüísticas. Después de todo, ¿quién no disfruta de una buena parodia de su canción favorita?

Mezclar el aprendizaje de idiomas con música y tecnología, Desafío Musical Con Chatgpt Crea un entorno dinámico e interactivo que revitaliza a los estudiantes y profundiza su conexión con el lenguaje y el papel evolutivo de la IA. Convierte los momentos de agotamiento en oportunidades de creatividad, exploración cultural y entusiasmo renovado por el aprendizaje.

Angela Rodríguez Mooney, PhD, es profesora asistente de español y la Universidad de Mujeres de Texas.

Referencias

Baghurst, Timothy y Betty C. Kelley. “Un examen del estrés en los estudiantes universitarios en el transcurso de un semestre”. Práctica de promoción de la salud 15, no. 3 (2014): 438-447.

DeGrave, Pauline. “Música en el aula de idiomas extranjeros: cómo y por qué”. Revista de Enseñanza e Investigación de Lenguas 10, no. 3 (2019): 412-420.

Felder, Richard M. y Eunice R. Henriques. “Estilos de aprendizaje y enseñanza en la educación extranjera y de segundo idioma”. Anales de idiomas extranjeros 28, no. 1 (1995): 21-31.

Nuessel, Frank y April D. Marshall. “Prácticas y principios para involucrar a los tres modos comunicativos en español a través de canciones y música”. Hispania (2008): 139-146.

Kumar, Tribhuwan, Shamim Akhter, Mehrunnisa M. Yunus y Atefeh Shamsy. “Uso de la música y las canciones como herramientas pedagógicas en la enseñanza del inglés como contextos de idiomas extranjeros”. Education Research International 2022, no. 1 (2022): 1-9

Noticias

5 indicaciones de chatgpt que pueden ayudar a los adolescentes a lanzar una startup

Published

8 meses agoon

5 junio, 2025

Teen emprendedor que usa chatgpt para ayudarlo con su negocio

El emprendimiento adolescente sigue en aumento. Según Junior Achievement Research, el 66% de los adolescentes estadounidenses de entre 13 y 17 años dicen que es probable que considere comenzar un negocio como adultos, con el monitor de emprendimiento global 2023-2024 que encuentra que el 24% de los jóvenes de 18 a 24 años son actualmente empresarios. Estos jóvenes fundadores no son solo soñando, están construyendo empresas reales que generan ingresos y crean un impacto social, y están utilizando las indicaciones de ChatGPT para ayudarlos.

En Wit (lo que sea necesario), la organización que fundó en 2009, hemos trabajado con más de 10,000 jóvenes empresarios. Durante el año pasado, he observado un cambio en cómo los adolescentes abordan la planificación comercial. Con nuestra orientación, están utilizando herramientas de IA como ChatGPT, no como atajos, sino como socios de pensamiento estratégico para aclarar ideas, probar conceptos y acelerar la ejecución.

Los emprendedores adolescentes más exitosos han descubierto indicaciones específicas que los ayudan a pasar de una idea a otra. Estas no son sesiones genéricas de lluvia de ideas: están utilizando preguntas específicas que abordan los desafíos únicos que enfrentan los jóvenes fundadores: recursos limitados, compromisos escolares y la necesidad de demostrar sus conceptos rápidamente.

Aquí hay cinco indicaciones de ChatGPT que ayudan constantemente a los emprendedores adolescentes a construir negocios que importan.

1. El problema del primer descubrimiento chatgpt aviso

“Me doy cuenta de que [specific group of people]

luchar contra [specific problem I’ve observed]. Ayúdame a entender mejor este problema explicando: 1) por qué existe este problema, 2) qué soluciones existen actualmente y por qué son insuficientes, 3) cuánto las personas podrían pagar para resolver esto, y 4) tres formas específicas en que podría probar si este es un problema real que vale la pena resolver “.

Un adolescente podría usar este aviso después de notar que los estudiantes en la escuela luchan por pagar el almuerzo. En lugar de asumir que entienden el alcance completo, podrían pedirle a ChatGPT que investigue la deuda del almuerzo escolar como un problema sistémico. Esta investigación puede llevarlos a crear un negocio basado en productos donde los ingresos ayuden a pagar la deuda del almuerzo, lo que combina ganancias con el propósito.

Los adolescentes notan problemas de manera diferente a los adultos porque experimentan frustraciones únicas, desde los desafíos de las organizaciones escolares hasta las redes sociales hasta las preocupaciones ambientales. Según la investigación de Square sobre empresarios de la Generación de la Generación Z, el 84% planea ser dueños de negocios dentro de cinco años, lo que los convierte en candidatos ideales para las empresas de resolución de problemas.

2. El aviso de chatgpt de chatgpt de chatgpt de realidad de la realidad del recurso

“Soy [age] años con aproximadamente [dollar amount] invertir y [number] Horas por semana disponibles entre la escuela y otros compromisos. Según estas limitaciones, ¿cuáles son tres modelos de negocio que podría lanzar de manera realista este verano? Para cada opción, incluya costos de inicio, requisitos de tiempo y los primeros tres pasos para comenzar “.

Este aviso se dirige al elefante en la sala: la mayoría de los empresarios adolescentes tienen dinero y tiempo limitados. Cuando un empresario de 16 años emplea este enfoque para evaluar un concepto de negocio de tarjetas de felicitación, puede descubrir que pueden comenzar con $ 200 y escalar gradualmente. Al ser realistas sobre las limitaciones por adelantado, evitan el exceso de compromiso y pueden construir hacia objetivos de ingresos sostenibles.

Según el informe de Gen Z de Square, el 45% de los jóvenes empresarios usan sus ahorros para iniciar negocios, con el 80% de lanzamiento en línea o con un componente móvil. Estos datos respaldan la efectividad de la planificación basada en restricciones: cuando funcionan los adolescentes dentro de las limitaciones realistas, crean modelos comerciales más sostenibles.

3. El aviso de chatgpt del simulador de voz del cliente

“Actúa como un [specific demographic] Y dame comentarios honestos sobre esta idea de negocio: [describe your concept]. ¿Qué te excitaría de esto? ¿Qué preocupaciones tendrías? ¿Cuánto pagarías de manera realista? ¿Qué necesitaría cambiar para que se convierta en un cliente? “

Los empresarios adolescentes a menudo luchan con la investigación de los clientes porque no pueden encuestar fácilmente a grandes grupos o contratar firmas de investigación de mercado. Este aviso ayuda a simular los comentarios de los clientes haciendo que ChatGPT adopte personas específicas.

Un adolescente que desarrolla un podcast para atletas adolescentes podría usar este enfoque pidiéndole a ChatGPT que responda a diferentes tipos de atletas adolescentes. Esto ayuda a identificar temas de contenido que resuenan y mensajes que se sienten auténticos para el público objetivo.

El aviso funciona mejor cuando se vuelve específico sobre la demografía, los puntos débiles y los contextos. “Actúa como un estudiante de último año de secundaria que solicita a la universidad” produce mejores ideas que “actuar como un adolescente”.

4. El mensaje mínimo de diseñador de prueba viable chatgpt

“Quiero probar esta idea de negocio: [describe concept] sin gastar más de [budget amount] o más de [time commitment]. Diseñe tres experimentos simples que podría ejecutar esta semana para validar la demanda de los clientes. Para cada prueba, explique lo que aprendería, cómo medir el éxito y qué resultados indicarían que debería avanzar “.

Este aviso ayuda a los adolescentes a adoptar la metodología Lean Startup sin perderse en la jerga comercial. El enfoque en “This Week” crea urgencia y evita la planificación interminable sin acción.

Un adolescente que desea probar un concepto de línea de ropa podría usar este indicador para diseñar experimentos de validación simples, como publicar maquetas de diseño en las redes sociales para evaluar el interés, crear un formulario de Google para recolectar pedidos anticipados y pedirles a los amigos que compartan el concepto con sus redes. Estas pruebas no cuestan nada más que proporcionar datos cruciales sobre la demanda y los precios.

5. El aviso de chatgpt del generador de claridad de tono

“Convierta esta idea de negocio en una clara explicación de 60 segundos: [describe your business]. La explicación debe incluir: el problema que resuelve, su solución, a quién ayuda, por qué lo elegirían sobre las alternativas y cómo se ve el éxito. Escríbelo en lenguaje de conversación que un adolescente realmente usaría “.

La comunicación clara separa a los empresarios exitosos de aquellos con buenas ideas pero una ejecución deficiente. Este aviso ayuda a los adolescentes a destilar conceptos complejos a explicaciones convincentes que pueden usar en todas partes, desde las publicaciones en las redes sociales hasta las conversaciones con posibles mentores.

El énfasis en el “lenguaje de conversación que un adolescente realmente usaría” es importante. Muchas plantillas de lanzamiento comercial suenan artificiales cuando se entregan jóvenes fundadores. La autenticidad es más importante que la jerga corporativa.

Más allá de las indicaciones de chatgpt: estrategia de implementación

La diferencia entre los adolescentes que usan estas indicaciones de manera efectiva y aquellos que no se reducen a seguir. ChatGPT proporciona dirección, pero la acción crea resultados.

Los jóvenes empresarios más exitosos con los que trabajo usan estas indicaciones como puntos de partida, no de punto final. Toman las sugerencias generadas por IA e inmediatamente las prueban en el mundo real. Llaman a clientes potenciales, crean prototipos simples e iteran en función de los comentarios reales.

Investigaciones recientes de Junior Achievement muestran que el 69% de los adolescentes tienen ideas de negocios, pero se sienten inciertos sobre el proceso de partida, con el miedo a que el fracaso sea la principal preocupación para el 67% de los posibles empresarios adolescentes. Estas indicaciones abordan esa incertidumbre al desactivar los conceptos abstractos en los próximos pasos concretos.

La imagen más grande

Los emprendedores adolescentes que utilizan herramientas de IA como ChatGPT representan un cambio en cómo está ocurriendo la educación empresarial. Según la investigación mundial de monitores empresariales, los jóvenes empresarios tienen 1,6 veces más probabilidades que los adultos de querer comenzar un negocio, y son particularmente activos en la tecnología, la alimentación y las bebidas, la moda y los sectores de entretenimiento. En lugar de esperar clases de emprendimiento formales o programas de MBA, estos jóvenes fundadores están accediendo a herramientas de pensamiento estratégico de inmediato.

Esta tendencia se alinea con cambios más amplios en la educación y la fuerza laboral. El Foro Económico Mundial identifica la creatividad, el pensamiento crítico y la resiliencia como las principales habilidades para 2025, la capacidad de las capacidades que el espíritu empresarial desarrolla naturalmente.

Programas como WIT brindan soporte estructurado para este viaje, pero las herramientas en sí mismas se están volviendo cada vez más accesibles. Un adolescente con acceso a Internet ahora puede acceder a recursos de planificación empresarial que anteriormente estaban disponibles solo para empresarios establecidos con presupuestos significativos.

La clave es usar estas herramientas cuidadosamente. ChatGPT puede acelerar el pensamiento y proporcionar marcos, pero no puede reemplazar el arduo trabajo de construir relaciones, crear productos y servir a los clientes. La mejor idea de negocio no es la más original, es la que resuelve un problema real para personas reales. Las herramientas de IA pueden ayudar a identificar esas oportunidades, pero solo la acción puede convertirlos en empresas que importan.

Noticias

Chatgpt vs. gemini: he probado ambos, y uno definitivamente es mejor

Published

8 meses agoon

5 junio, 2025

Precio

ChatGPT y Gemini tienen versiones gratuitas que limitan su acceso a características y modelos. Los planes premium para ambos también comienzan en alrededor de $ 20 por mes. Las características de chatbot, como investigaciones profundas, generación de imágenes y videos, búsqueda web y más, son similares en ChatGPT y Gemini. Sin embargo, los planes de Gemini pagados también incluyen el almacenamiento en la nube de Google Drive (a partir de 2TB) y un conjunto robusto de integraciones en las aplicaciones de Google Workspace.

Los niveles de más alta gama de ChatGPT y Gemini desbloquean el aumento de los límites de uso y algunas características únicas, pero el costo mensual prohibitivo de estos planes (como $ 200 para Chatgpt Pro o $ 250 para Gemini Ai Ultra) los pone fuera del alcance de la mayoría de las personas. Las características específicas del plan Pro de ChatGPT, como el modo O1 Pro que aprovecha el poder de cálculo adicional para preguntas particularmente complicadas, no son especialmente relevantes para el consumidor promedio, por lo que no sentirá que se está perdiendo. Sin embargo, es probable que desee las características que son exclusivas del plan Ai Ultra de Gemini, como la generación de videos VEO 3.

Ganador: Géminis

Plataformas

Puede acceder a ChatGPT y Gemini en la web o a través de aplicaciones móviles (Android e iOS). ChatGPT también tiene aplicaciones de escritorio (macOS y Windows) y una extensión oficial para Google Chrome. Gemini no tiene aplicaciones de escritorio dedicadas o una extensión de Chrome, aunque se integra directamente con el navegador.

(Crédito: OpenAI/PCMAG)

Chatgpt está disponible en otros lugares, Como a través de Siri. Como se mencionó, puede acceder a Gemini en las aplicaciones de Google, como el calendario, Documento, ConducirGmail, Mapas, Mantener, FotosSábanas, y Música de YouTube. Tanto los modelos de Chatgpt como Gemini también aparecen en sitios como la perplejidad. Sin embargo, obtiene la mayor cantidad de funciones de estos chatbots en sus aplicaciones y portales web dedicados.

Las interfaces de ambos chatbots son en gran medida consistentes en todas las plataformas. Son fáciles de usar y no lo abruman con opciones y alternar. ChatGPT tiene algunas configuraciones más para jugar, como la capacidad de ajustar su personalidad, mientras que la profunda interfaz de investigación de Gemini hace un mejor uso de los bienes inmuebles de pantalla.

Ganador: empate

Modelos de IA

ChatGPT tiene dos series primarias de modelos, la serie 4 (su línea de conversación, insignia) y la Serie O (su compleja línea de razonamiento). Gemini ofrece de manera similar una serie Flash de uso general y una serie Pro para tareas más complicadas.

Los últimos modelos de Chatgpt son O3 y O4-Mini, y los últimos de Gemini son 2.5 Flash y 2.5 Pro. Fuera de la codificación o la resolución de una ecuación, pasará la mayor parte de su tiempo usando los modelos de la serie 4-Series y Flash. A continuación, puede ver cómo funcionan estos modelos en una variedad de tareas. Qué modelo es mejor depende realmente de lo que quieras hacer.

Ganador: empate

Búsqueda web

ChatGPT y Gemini pueden buscar información actualizada en la web con facilidad. Sin embargo, ChatGPT presenta mosaicos de artículos en la parte inferior de sus respuestas para una lectura adicional, tiene un excelente abastecimiento que facilita la vinculación de reclamos con evidencia, incluye imágenes en las respuestas cuando es relevante y, a menudo, proporciona más detalles en respuesta. Gemini no muestra nombres de fuente y títulos de artículos completos, e incluye mosaicos e imágenes de artículos solo cuando usa el modo AI de Google. El abastecimiento en este modo es aún menos robusto; Google relega las fuentes a los caretes que se pueden hacer clic que no resaltan las partes relevantes de su respuesta.

Como parte de sus experiencias de búsqueda en la web, ChatGPT y Gemini pueden ayudarlo a comprar. Si solicita consejos de compra, ambos presentan mosaicos haciendo clic en enlaces a los minoristas. Sin embargo, Gemini generalmente sugiere mejores productos y tiene una característica única en la que puede cargar una imagen tuya para probar digitalmente la ropa antes de comprar.

Ganador: chatgpt

Investigación profunda

ChatGPT y Gemini pueden generar informes que tienen docenas de páginas e incluyen más de 50 fuentes sobre cualquier tema. La mayor diferencia entre los dos se reduce al abastecimiento. Gemini a menudo cita más fuentes que CHATGPT, pero maneja el abastecimiento en informes de investigación profunda de la misma manera que lo hace en la búsqueda en modo AI, lo que significa caretas que se puede hacer clic sin destacados en el texto. Debido a que es más difícil conectar las afirmaciones en los informes de Géminis a fuentes reales, es más difícil creerles. El abastecimiento claro de ChatGPT con destacados en el texto es más fácil de confiar. Sin embargo, Gemini tiene algunas características de calidad de vida en ChatGPT, como la capacidad de exportar informes formateados correctamente a Google Docs con un solo clic. Su tono también es diferente. Los informes de ChatGPT se leen como publicaciones de foro elaboradas, mientras que los informes de Gemini se leen como documentos académicos.

Ganador: chatgpt

Generación de imágenes

La generación de imágenes de ChatGPT impresiona independientemente de lo que solicite, incluso las indicaciones complejas para paneles o diagramas cómicos. No es perfecto, pero los errores y la distorsión son mínimos. Gemini genera imágenes visualmente atractivas más rápido que ChatGPT, pero rutinariamente incluyen errores y distorsión notables. Con indicaciones complicadas, especialmente diagramas, Gemini produjo resultados sin sentido en las pruebas.

Arriba, puede ver cómo ChatGPT (primera diapositiva) y Géminis (segunda diapositiva) les fue con el siguiente mensaje: “Genere una imagen de un estudio de moda con una decoración simple y rústica que contrasta con el espacio más agradable. Incluya un sofá marrón y paredes de ladrillo”. La imagen de ChatGPT limita los problemas al detalle fino en las hojas de sus plantas y texto en su libro, mientras que la imagen de Gemini muestra problemas más notables en su tubo de cordón y lámpara.

Ganador: chatgpt

¡Obtenga nuestras mejores historias!

Toda la última tecnología, probada por nuestros expertos

Regístrese en el boletín de informes de laboratorio para recibir las últimas revisiones de productos de PCMAG, comprar asesoramiento e ideas.

Al hacer clic en Registrarme, confirma que tiene más de 16 años y acepta nuestros Términos de uso y Política de privacidad.

¡Gracias por registrarse!

Su suscripción ha sido confirmada. ¡Esté atento a su bandeja de entrada!

Generación de videos

La generación de videos de Gemini es la mejor de su clase, especialmente porque ChatGPT no puede igualar su capacidad para producir audio acompañante. Actualmente, Google bloquea el último modelo de generación de videos de Gemini, VEO 3, detrás del costoso plan AI Ultra, pero obtienes más videos realistas que con ChatGPT. Gemini también tiene otras características que ChatGPT no, como la herramienta Flow Filmmaker, que le permite extender los clips generados y el animador AI Whisk, que le permite animar imágenes fijas. Sin embargo, tenga en cuenta que incluso con VEO 3, aún necesita generar videos varias veces para obtener un gran resultado.

En el ejemplo anterior, solicité a ChatGPT y Gemini a mostrarme un solucionador de cubos de Rubik Rubik que resuelva un cubo. La persona en el video de Géminis se ve muy bien, y el audio acompañante es competente. Al final, hay una buena atención al detalle con el marco que se desplaza, simulando la detención de una grabación de selfies. Mientras tanto, Chatgpt luchó con su cubo, distorsionándolo en gran medida.

Ganador: Géminis

Procesamiento de archivos

Comprender los archivos es una fortaleza de ChatGPT y Gemini. Ya sea que desee que respondan preguntas sobre un manual, editen un currículum o le informen algo sobre una imagen, ninguno decepciona. Sin embargo, ChatGPT tiene la ventaja sobre Gemini, ya que ofrece un reconocimiento de imagen ligeramente mejor y respuestas más detalladas cuando pregunta sobre los archivos cargados. Ambos chatbots todavía a veces inventan citas de documentos proporcionados o malinterpretan las imágenes, así que asegúrese de verificar sus resultados.

Ganador: chatgpt

Escritura creativa

Chatgpt y Gemini pueden generar poemas, obras, historias y más competentes. CHATGPT, sin embargo, se destaca entre los dos debido a cuán únicas son sus respuestas y qué tan bien responde a las indicaciones. Las respuestas de Gemini pueden sentirse repetitivas si no calibra cuidadosamente sus solicitudes, y no siempre sigue todas las instrucciones a la carta.

En el ejemplo anterior, solicité ChatGPT (primera diapositiva) y Gemini (segunda diapositiva) con lo siguiente: “Sin hacer referencia a nada en su memoria o respuestas anteriores, quiero que me escriba un poema de verso gratuito. Preste atención especial a la capitalización, enjambment, ruptura de línea y puntuación. Dado que es un verso libre, no quiero un medidor familiar o un esquema de retiro de la rima, pero quiero que tenga un estilo de coohes. ChatGPT logró entregar lo que pedí en el aviso, y eso era distinto de las generaciones anteriores. Gemini tuvo problemas para generar un poema que incorporó cualquier cosa más allá de las comas y los períodos, y su poema anterior se lee de manera muy similar a un poema que generó antes.

Recomendado por nuestros editores

Ganador: chatgpt

Razonamiento complejo

Los modelos de razonamiento complejos de Chatgpt y Gemini pueden manejar preguntas de informática, matemáticas y física con facilidad, así como mostrar de manera competente su trabajo. En las pruebas, ChatGPT dio respuestas correctas un poco más a menudo que Gemini, pero su rendimiento es bastante similar. Ambos chatbots pueden y le darán respuestas incorrectas, por lo que verificar su trabajo aún es vital si está haciendo algo importante o tratando de aprender un concepto.

Ganador: chatgpt

Integración

ChatGPT no tiene integraciones significativas, mientras que las integraciones de Gemini son una característica definitoria. Ya sea que desee obtener ayuda para editar un ensayo en Google Docs, comparta una pestaña Chrome para hacer una pregunta, pruebe una nueva lista de reproducción de música de YouTube personalizada para su gusto o desbloquee ideas personales en Gmail, Gemini puede hacer todo y mucho más. Es difícil subestimar cuán integrales y poderosas son realmente las integraciones de Géminis.

Ganador: Géminis

Asistentes de IA

ChatGPT tiene GPT personalizados, y Gemini tiene gemas. Ambos son asistentes de IA personalizables. Tampoco es una gran actualización sobre hablar directamente con los chatbots, pero los GPT personalizados de terceros agregan una nueva funcionalidad, como el fácil acceso a Canva para editar imágenes generadas. Mientras tanto, terceros no pueden crear gemas, y no puedes compartirlas. Puede permitir que los GPT personalizados accedan a la información externa o tomen acciones externas, pero las GEM no tienen una funcionalidad similar.

Ganador: chatgpt

Contexto Windows y límites de uso

La ventana de contexto de ChatGPT sube a 128,000 tokens en sus planes de nivel superior, y todos los planes tienen límites de uso dinámicos basados en la carga del servidor. Géminis, por otro lado, tiene una ventana de contexto de 1,000,000 token. Google no está demasiado claro en los límites de uso exactos para Gemini, pero también son dinámicos dependiendo de la carga del servidor. Anecdóticamente, no pude alcanzar los límites de uso usando los planes pagados de Chatgpt o Gemini, pero es mucho más fácil hacerlo con los planes gratuitos.

Ganador: Géminis

Privacidad

La privacidad en Chatgpt y Gemini es una bolsa mixta. Ambos recopilan cantidades significativas de datos, incluidos todos sus chats, y usan esos datos para capacitar a sus modelos de IA de forma predeterminada. Sin embargo, ambos le dan la opción de apagar el entrenamiento. Google al menos no recopila y usa datos de Gemini para fines de capacitación en aplicaciones de espacio de trabajo, como Gmail, de forma predeterminada. ChatGPT y Gemini también prometen no vender sus datos o usarlos para la orientación de anuncios, pero Google y OpenAI tienen historias sórdidas cuando se trata de hacks, filtraciones y diversos fechorías digitales, por lo que recomiendo no compartir nada demasiado sensible.

Ganador: empate

Related posts

Trending

-

Startups2 años ago

Startups2 años agoRemove.bg: La Revolución en la Edición de Imágenes que Debes Conocer

-

Tutoriales2 años ago

Tutoriales2 años agoCómo Comenzar a Utilizar ChatGPT: Una Guía Completa para Principiantes

-

Startups2 años ago

Startups2 años agoStartups de IA en EE.UU. que han recaudado más de $100M en 2024

-

Startups2 años ago

Startups2 años agoDeepgram: Revolucionando el Reconocimiento de Voz con IA

-

Recursos2 años ago

Recursos2 años agoCómo Empezar con Popai.pro: Tu Espacio Personal de IA – Guía Completa, Instalación, Versiones y Precios

-

Recursos2 años ago

Recursos2 años agoPerplexity aplicado al Marketing Digital y Estrategias SEO

-

Estudiar IA2 años ago

Estudiar IA2 años agoCurso de Inteligencia Artificial Aplicada de 4Geeks Academy 2024

-

Estudiar IA2 años ago

Estudiar IA2 años agoCurso de Inteligencia Artificial de UC Berkeley estratégico para negocios